Как распознать, что фото создано с помощью ИИ

Быстрые ссылки

Что такое фотография, созданная ИИ?

4 способа проверить — создано ли фото ИИ

Будущее изображений, сгенерированных ИИ

Краткое содержание

Чтобы понять, создано ли изображение искусственным интеллектом, сначала посмотрите на возможные визуальные ошибки: несоответствующие серьги, искажённые черты лица, «плавающие» предметы. Всегда читайте подписи и комментарии: авторы часто отмечают, что использовали Midjourney, DALL·E или Stable Diffusion. Дополнительно можно прибегнуть к инструментам обнаружения GAN и к обратному поиску по картинке.

Отличить цифровую подделку становится сложнее: современные генераторы создают всё более реалистичные сцены. Однако сочетание визуальной проверки и технических методов остаётся надёжным подходом.

Что такое фотография, созданная ИИ?

Фотография, созданная ИИ, — это любое изображение, полностью или частично сгенерированное или изменённое с помощью алгоритмов машинного обучения. Современные генераторы изображений (например, DALL·E, Midjourney, Stable Diffusion) могут производить фотореалистичные картинки, иногда практически неотличимые от настоящих снимков.

Короткое определение: генеративные модели создают новые изображения на основе обучения на больших наборах данных. Понятие охватывает полностью синтезированные кадры и ретушь/манипуляции, выполненные ИИ.

Важно: многие люди используют инструменты генерации для творчества и прототипирования. Проблема возникает, когда такие изображения применяются обманным путём — в дезинформации, фальсификациях или без согласия изображённых.

4 способа проверить, сделано ли фото ИИ

Ни один метод не даёт 100% гарантии сам по себе. Лучший результат достигается комбинацией быстрых визуальных проверок и технических приёмов.

Проверьте подпись, описание и комментарии

Почему это работает: пользователи часто прямо указывают, что использовали ИИ, или публикуют промпты и хештеги: #aiart, #midjourney, #stablehub и т. п.

Как проверять:

- Прочитайте подпись под публикацией и комментарии — автор мог раскрыть источник.

- Поиск по хештегам и упоминаниям версии (например, mjv5) даёт контекст о генераторе.

- Если есть слайды/ответные публикации, автор может показать исходные фото или процесс генерации.

Когда это не поможет: злоумышленник может не указывать источник, или подпись может быть поддельной.

Ищите визуальные странности

Наиболее очевидный способ — внимательный визуальный осмотр. Даже продвинутые модели иногда ошибаются в деталях, особенно при сложных объектах.

На что обращать внимание:

- Пальцы рук: их количество, длина и изгибы часто бывают неправильными.

- Зубы и рот: неестественная симметрия, «слияние» зубов.

- Очки и аксессуары: рамки могут «врезаться» в кожу или исчезать.

- Текст на изображении: буковки смазаны, неправильная последовательность символов.

- Фон и отражения: тени и источники света, не соответствующие основной сцене.

- Поверхности и текстуры: слишком ровные «пластиковые» лица, повторяющиеся текстуры.

- Вода и жидкость: часто выглядят «плохо» или исходят из неожиданных мест.

Пример: в серии изображений, где папа изображён с игрушечным распылителем в толпе, лица на заднем плане выглядят искажёнными, а вода «появляется из ниоткуда».

Когда это не помогает: продвинутые модели (новые версии Midjourney, коммерческие решения) заметно снизили количество таких артефактов.

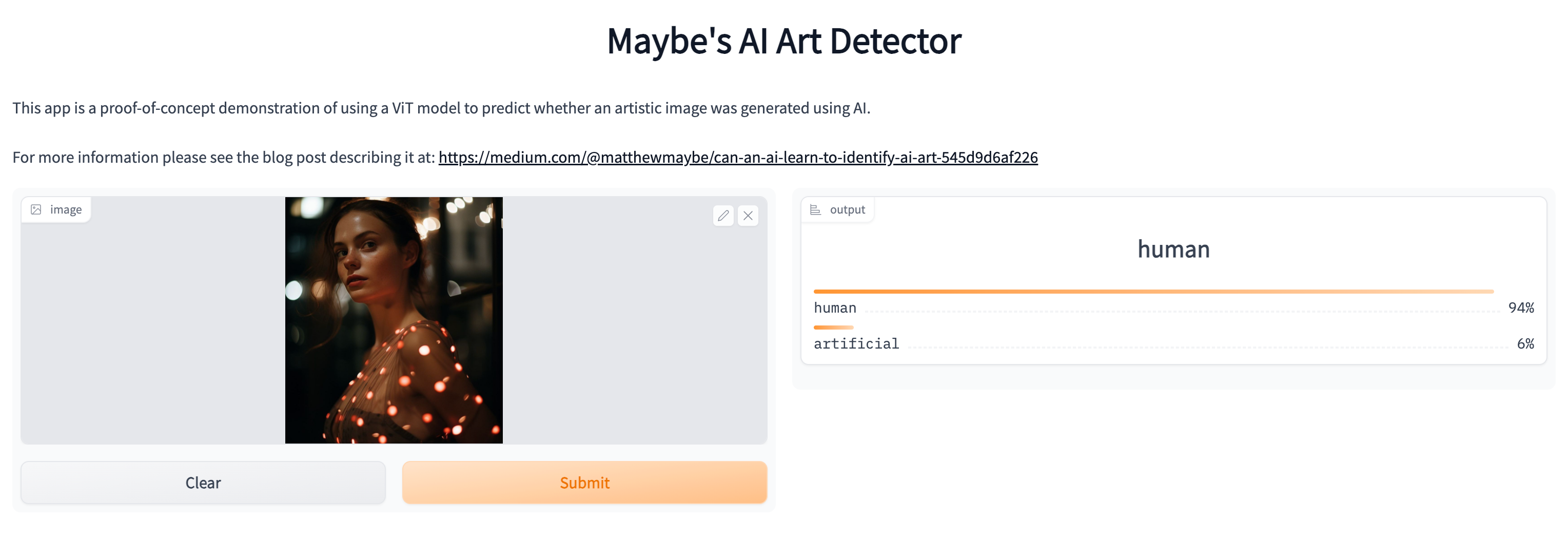

Используйте детекторы GAN и плагины

Что это такое: инструменты, анализирующие цифровые шумы и статистику изображения, чтобы оценить вероятность генерации алгоритмом.

Как применять:

- Расширения браузера: некоторые плагины позволяют правой кнопкой проверить профильное фото на предмет GAN-артефактов.

- Веб-сервисы: загрузите изображение в онлайн-детектор (помните о конфиденциальности).

Ограничения:

- Ложные срабатывания возможны: детектор может пометить реальную фотографию как «ИИ» и наоборот.

- Детекторы часто обучаются на старых моделях и отстают от передовых генераторов.

Пример из практики: изображение, созданное Midjourney V5, было ошибочно классифицировано как «человеческое» одним детектором.

Сделайте обратный поиск по изображению

Почему это помогает: обратный поиск (Google Images, TinEye) показывает, где ещё встречается картинка или похожие варианты. Для реального события обычно есть несколько источников.

Процесс:

- Правый клик → «Найти изображение в Google» (или загрузка в TinEye).

- В разделе результатов проверьте «Найти источник изображения» или похожие изображения.

- Ищите публикации в новостях, статьи или исходные фото, которые могли быть использованы для тренировки/основы.

Интерпретация:

- Нет совпадений вовсе — возможна синтетика, но также это может быть уникальная фотография, ещё не индексированная поисковиками.

- Совпадения с неоднократно ретушированными версиями — обратите внимание на EXIF/метаданные (если доступны).

Когда не работает: генеративные модели создают уникальные композиции, которых ещё нет в сети, поэтому отсутствие результатов не доказывает подделку или подлинность.

Дополнительные проверки и методы

Ниже — расширенные практики, полезные, если изображение критично важно.

Проверка метаданных (EXIF)

Опишите: EXIF — встроенные в файлы JPEG/HEIC данные о камере, дате съёмки, настройках и иногда GPS. Сгенерированные изображения часто не содержат правдивых EXIF-метаданных или содержат признаки постобработки.

Как проверять:

- Скачайте файл и откройте его в утилите просмотра EXIF (например, ExifTool).

- Проверьте поля Camera Model, DateTime, Software. Наличие имени генератора в поле Software — явный сигнал.

Ограничение: EXIF легко редактировать или удалять, поэтому отсутствие метаданных не означает, что фото — ИИ.

Контекст и фактчекинг

Для новостных или сенсационных изображений критично проверять контекст:

- Ищите другие источники и свидетельства события.

- Сверьте геолокацию и временные метки (если доступны).

- Обратитесь к профильным экспертам или источникам в сети, у которых есть доказательства сцены.

Когда эти методы могут не сработать

- Профессионально сгенерированные изображения и комбинированные кадры (частично настоящие фото + ИИ-ретушь) могут скрывать очевидные признаки.

- Автор может умышленно ретушировать EXIF и подписи.

- Детекторы и обратный поиск отстают от новых моделей; поэтому проверка должна основываться на множестве сигналов.

Практическая модель принятия решения (Mermaid)

flowchart TD

A[Начать проверку изображения] --> B{Есть подпись/хештеги?}

B -- Да --> C[Ищем упоминания генератора]

B -- Нет --> D[Осмотр на визуальные артефакты]

C --> E{Указан ИИ?}

E -- Да --> Z[Вероятно сгенерировано ИИ]

E -- Нет --> D

D --> F[Запустить обратный поиск]

F --> G{Найдены совпадения?}

G -- Да --> H[Проверить источники: новости, EXIF]

G -- Нет --> I[Запустить детектор GAN]

I --> J{Детектор говорит ИИ?}

J -- Да --> Z

J -- Нет --> K[Если важно — обратитесь к экспертам]

H --> L{Источник надёжен?}

L -- Да --> M[Вероятно реальное]

L -- Нет --> Z

K --> ZКонтрольный список по проверке изображений

Используйте этот список в качестве чеклиста при верификации:

- Прочитал подпись и комментарии — есть упоминания ИИ?

- Осмотрел лицо, руки, аксессуары, фон на артефакты

- Выполнен обратный поиск по изображению

- Проверены метаданные (EXIF) при наличии исходного файла

- Проведён анализ детектором GAN/специальным плагином

- Сверены источники (новости, свидетели) для событийных фото

- Если нужно — привлечён эксперт/сторонняя служба верификации

Рольные чеклисты:

- Журналист: приоритет — вторичный источник, подтверждение фактов, запись контактов свидетелей.

- Модератор соцсети: приоритет — быстрый визуальный осмотр, обратный поиск, пометка на рассмотрение.

- Обычный пользователь: приоритет — проверка подписи и быстрый обратный поиск перед репостом.

Краткое руководство по процедурам (SOP)

- Зафиксируйте изображение (скриншот или скачивание).

- Проверьте подпись и метаданные.

- Выполните обратный поиск изображения и сохраните результаты.

- Просканируйте изображение детектором GAN, зафиксируйте результат и метаданные детектора (версия/дата).

- Сопоставьте визуальные сигналы с результатами поиска и анализа.

- Примите решение: опубликовать, пометить как возможную подделку, или запросить экспертную проверку.

Критерии приёмки (когда считать изображение аутентичным):

- Наличие нескольких независимых первичных источников с одинаковой хронологией событий.

- EXIF-данные соответствуют контексту (например, модель камеры с указанной датой).

- Обратный поиск возвращает новостные публикации/оригинальный авторский материал.

Быстрое руководство для социальных сетей (соц-превью)

OG title: Как отличить фото ИИ от настоящего OG description: Узнайте 4 быстрых способа распознать изображения, созданные ИИ: подписи, визуальные артефакты, обратный поиск и детекторы GAN.

Короткий анонс (100–200 слов):

Современные генераторы изображений создают убедительные фальшивки. Этот материал объясняет простые и технические методы проверки — от чтения подписи и анализа визуальных артефактов до использования обратного поиска и детекторов GAN. Включён практический чеклист и процесс действий для журналистов, модераторов и обычных пользователей.

Будущее изображений, созданных ИИ

Тенденция очевидна: генераторы и детекторы продолжают соревноваться. Новые модели постепенно устраняют классические ошибки (например, неправильные пальцы), но это порождает новые вызовы: комбинированные техники (частично реальные фотографии + ИИ-ретушь), генерация с высоким разрешением и модели, умеющие воспроизводить стиль конкретного фотографа.

Регулирование и этика также будут играть всё большую роль: маркировка ИИ-контента, правила использования лиц и согласия — ключевые вопросы ближайших лет.

Заключение

Главная идея: не полагайтесь на один сигнал. Быстрая проверка подписи и визуальный осмотр даст вам первичное впечатление; обратный поиск и детекторы усилят вывод. Для критичных случаев используйте формализованный процесс проверки и привлекайте экспертов.

Важное: если вы не уверены, лучше пометить изображение как «проверяется» и не распространять сенсационные выводы.

Ключевые рекомендации:

- Сначала — подпись и контекст.

- Затем — визуальная проверка на артефакты.

- После — обратный поиск и инструменты анализа.

- Если изображение может повлиять на репутацию или безопасность — привлекайте экспертизу.

Похожие материалы

RDP: полный гид по настройке и безопасности

Android как клавиатура и трекпад для Windows

Советы и приёмы для работы с PDF

Calibration в Lightroom Classic: как и когда использовать

Отключить Siri Suggestions на iPhone