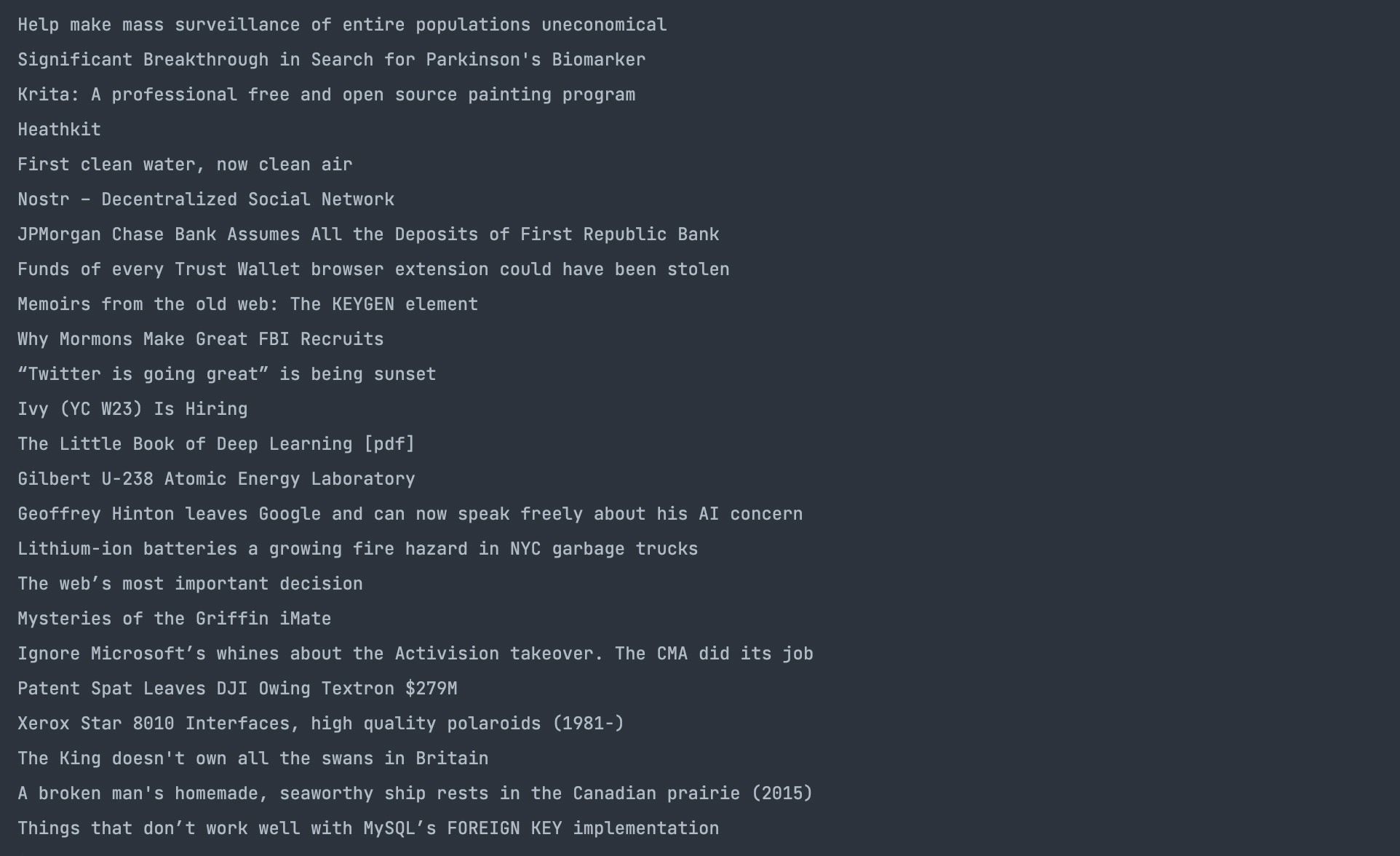

Веб-скрапинг на Rust: быстро и безопасно

Почему Rust подходит для веб-скрапинга

Rust обеспечивает высокую скорость выполнения и строгую модель владения памятью, что снижает вероятность утечек и гонок. Для веб-скрапинга это важно: парсеры часто обрабатывают большие объёмы HTML и могут работать в многопоточной среде. Небольшие задержки при парсинге или управлении памятью могут накапливаться при массовом сборе данных.

Краткое определение: веб-скрапинг — автоматизированный сбор данных со страниц веб-сайтов, когда API недоступно или слишком ограничено.

Быстрый старт: reqwest + scraper

Большинство проектных примеров в сообществе Rust используют сочетание reqwest для HTTP-запросов и scraper для парсинга DOM через CSS-селекторы. Ниже — минимальный набор зависимостей, который обычно добавляют в Cargo.toml:

[dependencies]

reqwest = {version = "0.11", features = ["blocking"]}

scraper = "0.12.0"

Эти зависимости дают простой синхронный путь для начала. В продакшне часто применяют асинхронную версию (без features = [“blocking”]) для лучшей масштабируемости.

Получение страницы с помощью Reqwest

Прежде чем парсить, нужно загрузить HTML. Простой пример получения HTML-строки с помощью reqwest:

fn retrieve_html() -> String {

let response = get("https://news.ycombinator.com").unwrap().text().unwrap();

return response;

}

Пояснение: get отправляет GET-запрос, а text возвращает тело ответа как строку. В реальном коде unwrap заменяют на обработку ошибок.

Разбор HTML с помощью Scraper

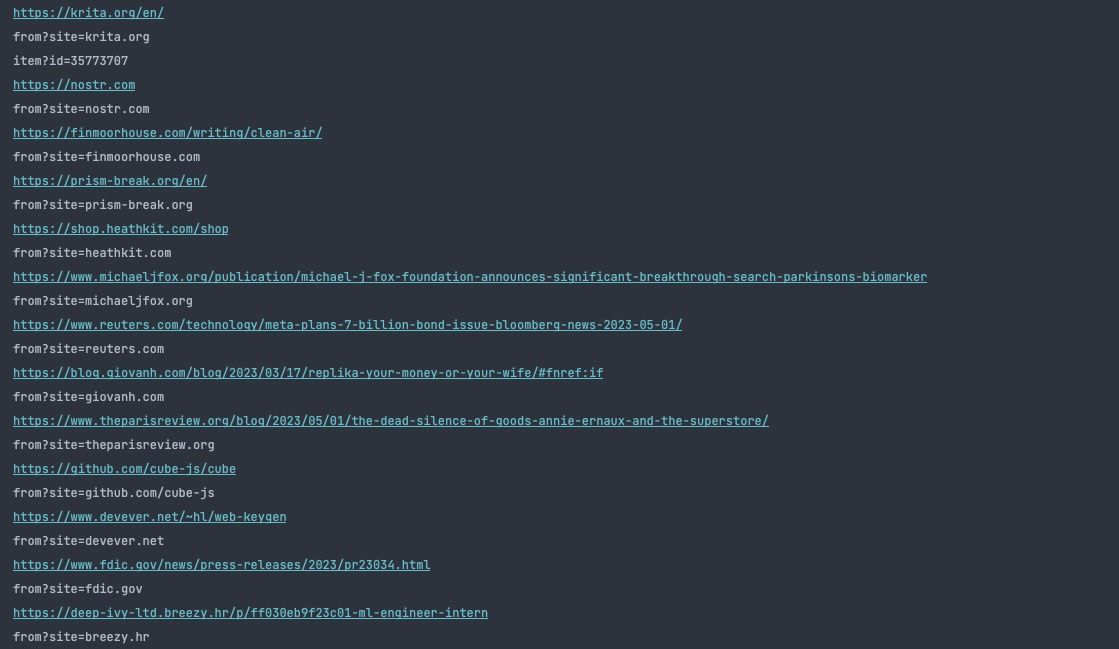

Scraper предоставляет структуры Html и Selector для разбора документа и выборки элементов по CSS. Пример, который собирает заголовки со страницы Hacker News:

use scraper::{Html, Selector};

fn main() {

let response = reqwest::blocking::get(

"https://news.ycombinator.com/").unwrap().text().unwrap();

// parse the HTML document

let doc_body = Html::parse_document(&response);

// select the elements with titleline class

let title = Selector::parse(".titleline").unwrap();

for title in doc_body.select(&title) {

let titles = title.text().collect::>();

println!("{}", titles[0])

}

}

Функция parse_document строит дерево документа, Selector::parse создаёт селектор по CSS-классу. Цикл проходит по найденным узлам и выводит текст первого текстового блока в каждом.

Выбор атрибутов с помощью Scraper

Чтобы получить значение атрибута (например, href у тега a), используйте метод attr на value узла:

use reqwest::blocking::get;

use scraper::{Html, Selector};

fn main() {

let response = get("https://news.ycombinator.com").unwrap().text().unwrap();

let html_doc = Html::parse_document(&response);

let class_selector = Selector::parse(".titleline").unwrap();

for element in html_doc.select(&class_selector) {

let link_selector = Selector::parse("a").unwrap();

for link in element.select(&link_selector) {

if let Some(href) = link.value().attr("href") {

println!("{}", href);

}

}

}

}

Этот пример показывает классический паттерн: выбрать родительский элемент, затем внутри искать теги a и читать атрибуты.

Советы по надёжности и масштабированию

- Обработка ошибок: никогда не используйте unwrap в продакшн-коде. Оборачивайте в Result, логируйте и реализуйте повторные попытки с ростом задержки (exponential backoff).

- Таймауты: устанавливайте таймауты для HTTP-запросов, чтобы одна «зависшая» страница не блокировала весь обход.

- Ограничение параллелизма: контролируйте количество одновременных запросов, чтобы не перегружать целевой сайт и свою систему.

- User-Agent и задержки: корректно указывайте User-Agent и соблюдайте robots.txt; добавляйте искусственные задержки между запросами.

- Кэширование: сохраняйте недавно полученные HTML-ответы локально, чтобы избежать повторных запросов при отладке.

- Асинхронность: для большого объёма данных используйте async reqwest + tokio для высокой пропускной способности.

Когда веб-скрапинг на Rust не лучший выбор

- Если проект требует быстрой прототипной разработки с минимальным набором знаний — Python с BeautifulSoup и requests может быть быстрее для старта.

- Если нужно взаимодействие с JavaScript-рендерингом — используйте headless-браузер (Puppeteer, Playwright). Для Rust есть bindings, но они менее зрелые.

- Если целью является простой экспорт данных через официальный API — всегда предпочитайте API, если он доступен.

Альтернативные подходы

- Асинхронный стек: reqwest (async) + tokio + scraper для высокой конкурентности.

- Headless-обходы: запуск Chromium через Playwright/Chromium binding, затем парсинг DOM или JSON из страницы.

- Интеграция на уровне сервера: сборка микросервиса на Actix или Rocket, который отвечает за агрегацию и нормализацию данных.

Мини-методология: как построить устойчивый скрапер

- Определите цель сбора и структуру выходных данных.

- Напишите модуль, который скачивает страницу с обработкой ошибок и таймаутами.

- Отдельный модуль — парсер DOM (используйте тесты на фрагментах HTML).

- Очистка и нормализация данных (дата, число, валюта, URL).

- Сохранение в durable-хранилище (БД, очередь).

- Мониторинг: SLO/alert на процент успешных обходов и среднее время ответа.

Критерии приёмки

- Скрапер стабильно извлекает необходимые поля из 95% тестовых страниц (в рамках текущей версии сайта).

- Обработка ошибок и повторные попытки реализованы для 5xx и сетевых ошибок.

- Лимит параллелизма настроен и документирован.

- Логирование и метрики (успех/ошибка/латентность) подключены.

Чек-лист для продакшна

- Таймауты и лимиты параллелизма заданы.

- Реализация retries с backoff.

- Кэширование и дедупликация URL.

- Соблюдение robots.txt и корректный User-Agent.

- Метрики и алерты настроены.

Краткий справочник терминов

- Reqwest — HTTP-клиент для Rust.

- Scraper — библиотека для парсинга HTML и выборки через CSS-селекторы.

- Selector — объект, представляющий CSS-селектор.

- Html::parse_document — функция, строящая дерево документа из строки.

Примеры типичных ошибок и как их избежать

- Проблема: страницы с динамическим контентом (JS). Решение: использовать headless-браузер или искать JSON-эндпоинты.

- Проблема: неожиданный формат даты. Решение: иметь набор паттернов и библиотеку для парсинга дат (chrono).

- Проблема: блокировки IP. Решение: уменьшить частоту запросов, соблюдать правила сайта, применять прокси и ротацию IP при необходимости.

Безопасность и приватность

- Не храните чувствительные данные без шифрования.

- Соблюдайте юридические требования и правила сайта (Terms of Service).

- Для персональных данных убедитесь в соответствии с местными законами о защите данных.

Заключение

Rust — отличный выбор для создания эффективных и надёжных веб-скрапер-решений: он сочетает скорость, контроль над памятью и богатую экосистему библиотек. Для большинства задач достаточно связки reqwest и scraper; при росте нагрузки переходите на асинхронную модель и добавляйте надёжность через мониторинг, ожидания и кэширование.

Ключевые шаги: определить структуру данных, реализовать скачивание с таймаутами и retry, корректно распарсить HTML и нормализовать результаты.

Вывод: начните с простого синхронного прототипа, затем постепенно вводите асинхронность и меры надёжности по мере роста нагрузки.

Похожие материалы

RDP: полный гид по настройке и безопасности

Android как клавиатура и трекпад для Windows

Советы и приёмы для работы с PDF

Calibration в Lightroom Classic: как и когда использовать

Отключить Siri Suggestions на iPhone