Как распознать AI‑фейки в Facebook и соцсетях

Быстрые ссылки

AI-сгенерированные фото захватывают Facebook

Как находить AI‑подделки

Видео — следующий рубеж

Это не только проблема Facebook

Краткое содержание

- AI‑изображения заполонили Facebook; их часто не замечают из‑за быстрого прогресса генеративных моделей.

- Не все пользователи умеют отличать AI‑фейки; появление AI‑видео создаст новые риски.

- Проблема касается всех платформ: Google Images, Instagram, TikTok и сайты объявлений.

AI‑сгенерированные фото захватывают Facebook

Генеративные модели (DALL·E, Midjourney и им подобные) создают изображения за секунды. Каждое обновление делает результаты реалистичнее. Для одних пользователей подделки очевидны. Для других — это обычные посты в ленте.

«Видеть — значит верить» утратило смысл. Проблема началась ещё в эпоху Photoshop, но AI вносит новые сложности: многие подделки не имеют ручных артефактов, которые можно заметить невооружённым глазом. Особенно заметно это в массовых мемах и челленджах внутри закрытых групп, где контент многократно репостят.

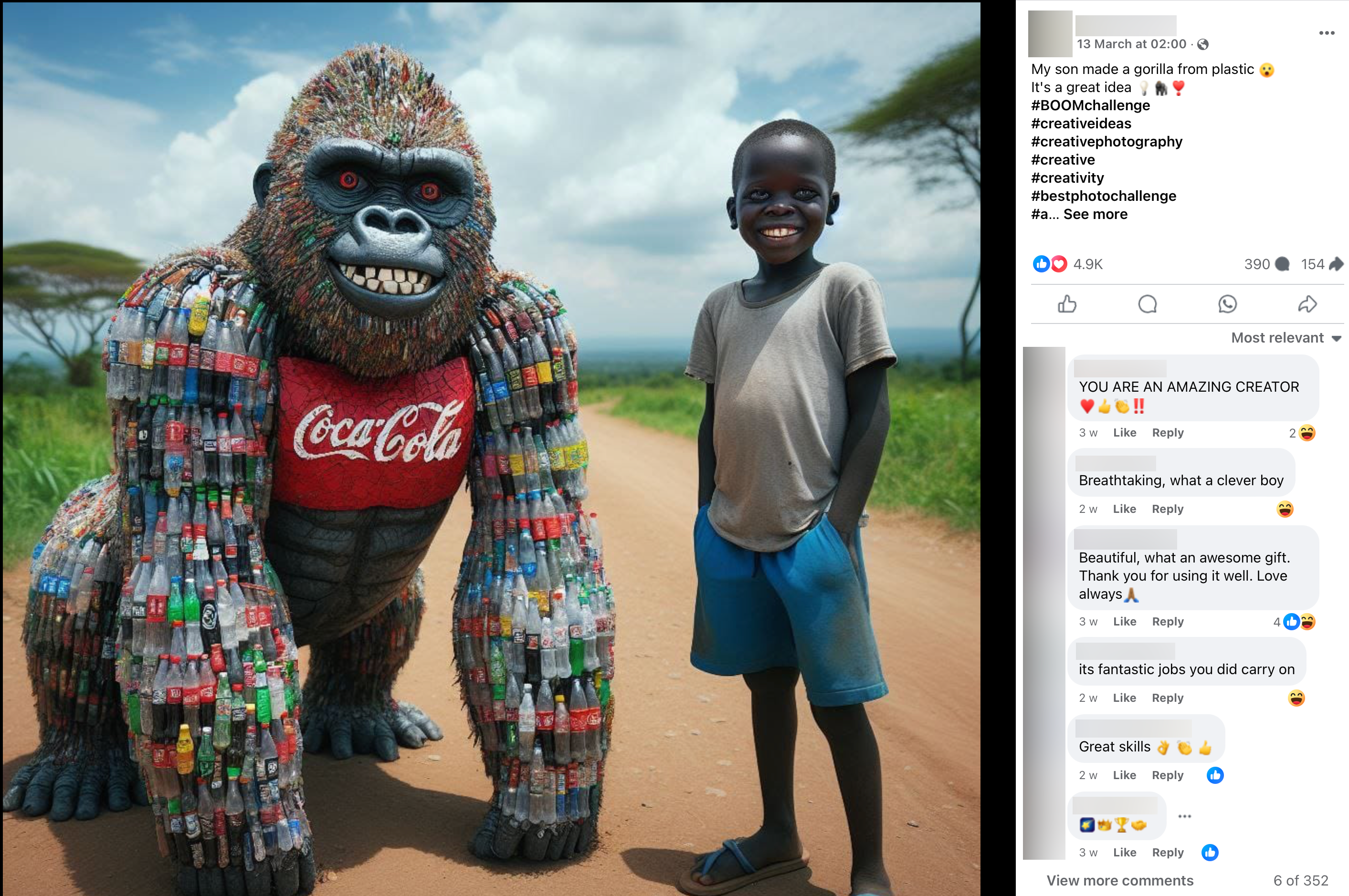

В начале 2024 года в Facebook появилась волна изображений с общей темой: скульптуры и объекты, полностью составленные из пластиковых бутылок. Часто рядом ставили фотографию человека (обычно ребёнка) — предполагаемого автора. Многие изображения имели религиозную или сентиментальную тональность, что повышало вовлечённость.

Мем быстро распространился: одно и то же изображение публиковали на разных страницах с подписью «мой сын сделал это» или похожим текстом. Такие публикации грамотно апеллируют к эмоциям и пользуются эффектом подтверждения в сообществах.

Двигатель распространения — вовлечённость. Комментарии и реакции повышают охват. Боты усиливают эффект. Для админов страниц это шанс получить трафик, для некоторых — источник дохода через спонсорство и партнёрские ссылки. Для других — социальный статус и влияние.

Важно: платформенная экономика поощряет контент, который вызывает реакцию. Эмоционально окрашенные AI‑изображения идеально подходят под эти правила.

Как находить AI‑подделки

Ни один инструмент не даёт 100% гарантии. Тем не менее есть надёжная методология и признаки, которые помогают делать обоснованные выводы.

Краткие признаки — быстрое сканирование:

- Нечёткие мелкие элементы: пальцы, зубы, уши, очки. AI часто ошибается в тонких деталях.

- Странные пересечения материалов: элементы не стыкуются логично (например, бутылки пересекаются под нелепым углом).

- Логотипы и текст выглядят «почти знакомыми», но не читаются.

- Неправильные тени или световые источники: части кадра светятся или отбрасывают тени под разными углами.

- Повторяющиеся элементы с малыми вариациями — признак генерации шаблоном.

Глубокая проверка — пошаговая методика (минимальная проверка для каждого сомнительного поста):

- Оцените контекст: кто публикует, есть ли авторитет, репосты от случайных аккаунтов.

- Обратите внимание на подпись и комментарии: неадекватные формулировки, однотипные ответы от аккаунтов без истории или ботов.

- Сделайте обратный поиск изображения (Google Images, TinEye). Ищите исходники или похожие вариации.

- Проверьте метаданные, если доступно (EXIF) — многие соцсети stripping metadata, но исходные файлы могут иметь следы.

- Проанализируйте мелкие детали в 100–200% масштабе: пальцы, складки, швы, пересечения текстур.

- Используйте несколько AI‑детекторов изображений, но помните об их ограничениях: они могут давать ложноположительные и ложноотрицательные срабатывания.

- По возможности запросите оригинал у автора и попросите «фото процесса» или видео, где видно, как объект создавался.

Инструменты и приёмы:

- Обратный поиск по картинке: Google Images, TinEye, Yandex Images.

- Анализ EXIF: ExifTool (если доступен исходник).

- Детекторы AI‑сгенерированного контента: набор онлайн‑сервисов, которые анализируют следы генерации. Их выводы — подсказка, а не доказательство.

- Просмотр в полноразмерном режиме и кадрирование для проверки мелких участков.

- Сравнение с реальными фотографиями подобных объектов: стоят ли материалы и конструкции логично?

Когда методы терпят неудачу — частые случаи:

- Хорошо подготовленная сцена с реальными фотоснимками и незначительными AI‑исправлениями может выглядеть аутентично.

- Когда AI «достраивает» существующую фотографию (inpainting), многие артефакты исчезают.

- Если изображение обрезано, пересжатие скрывает следы редактирования.

Примеры ложных срабатываний: изображения с художественной обработкой, стилизованные фото (например, мультяшная обработка), архивные снимки с потерей детализации часто помечают как «подозрительные», хотя они подлинные.

Особенный признак плачевных AI‑скульптур: логотипы на бутылках выглядят как полуразборчивые паттерны — «всё похоже на бренд, но не является им». Это часто даёт быстрое интуитивное понимание, что изображение сгенерировано.

Полезные шаблоны проверки (чек‑лист для одного изображения)

- Автор опубликован и обладает историей активности? Да/Нет

- Есть запросить исходники или фото процесса? Запрошено/Не запрошено

- Обратный поиск нашёл совпадения? Да/Нет

- Присутствуют артефакты на пальцах/руках/лицах/текстах? Да/Нет

- Свет и тени логичны по всему кадру? Да/Нет

- Метаданные указывают на камеру или генератор? Камера/Неизвестно

Если «Нет» более двух пунктов — повод для сомнений и осторожной реакции.

Видео — следующий рубеж

CGI и традиционный монтаж вводили людей в заблуждение десятилетиями. AI‑видео — иной вызов: модели учатся на видеорядe и создают клипы по подсказкам. Они не требуют ручной постобработки так, как это делали VFX‑специалисты.

Примеры технологий и проблем:

- Модели, подобные SORA (OpenAI) и другие исследовательские системы, демонстрируют, что генерация коротких видеоклипов становится доступной. Пока качество ограничено, но прогресс быстрый.

- AI‑видео наследует проблемы фото: неправильные руки, странная мимика, «прыгающие» детали между кадрами. Но эти артефакты быстро исчезают с улучшением моделей.

- Голосовые синтезаторы и текст‑в‑речь облегчают создание убедительных фейковых заявлений и «официальных» объявлений.

Как распознавать AI‑видео:

- Ищите нестабильные переходы и «скачки» мелких деталей между кадрами (причём глаза и зубы часто «плывут»).

- Проанализируйте аудиодорожку: синтезированные голоса часто имеют ровную интонацию и нетипичные дыхательные паузы.

- Сравните кадры с известными источниками: реальный фрагмент редко идеально совпадает с AI‑вариацией.

- Попросите исходное видео или несколько кадров в высоком разрешении.

Защита и превентивные меры на уровне платформ:

- Системы provenance (прозрачность происхождения контента) — автоматическое добавление слоёв с информацией о создании/редактировании — может помочь. Но внедрение и стандарты ещё в разработке.

- Watermarking (скрытые метки) и цифровые подписи — технически возможны, но их надо внедрять в коммерческие генераторы и интегрировать с платформами.

Это не только проблема Facebook

Facebook просто наиболее заметен по двум причинам: огромная аудитория и значительное количество закрытых групп, где контент быстро циркулирует без проверки. Но явление касается всех площадок:

- Google Images: AI‑изображения пробиваются в результаты поиска и используются как «реальные» иллюстрации.

- Instagram и TikTok: визуальный формат идеально подходит для AI‑контента; динамичные клипы и стилизованные фото быстро распространяются.

- Маркетплейсы и сайты объявлений: поддельные фото продуктов/проектов вводят покупателей в заблуждение.

Артисты жалуются на потерю надёжных визуальных референсов в результате распространения AI‑генерации. Хобби‑сообщества (вязание, крючок) рассказывают о ложных описаниях и несуществующих выкройках.

Концепция «мертвого интернета» — идея о том, что часть контента управляется не людьми — становится более реалистичной, по мере того как генерация контента автоматизируется. Даже если это преувеличение, тренд очевиден: содержание интернета будет всё более смешанным по происхождению.

Практическое руководство: что делать при обнаружении подозрительного поста

- Не репостите сразу. Дайте себе 5–10 минут для проверки.

- Проверьте профиль автора: возраст аккаунта, история публикаций, фото, друзья/подписчики.

- Сделайте обратный поиск по изображению и по ключевым фразам из подписи.

- Спросите автора публично в комментариях: «Можно увидеть процесс создания?» или «Есть исходник/видео?» Люди, публикующие реальные достижения, часто могут предоставить доказательства.

- Если пост от бренда или медиа — запросите официальное подтверждение или опровержение.

- Сообщите пост платформе, если считаете, что он вводит в заблуждение или нарушает правила сообщества.

- Обратитесь к специалисту (журналисту или эксперту по фото) для углублённой проверки, если предмет ценен или чувствителен.

Чек‑листы по ролям

Чек‑лист для обычного пользователя:

- Не доверяю посту по умолчанию.

- Проверяю автора и обратный поиск.

- Не репощу без подтверждения.

- Оповещаю знакомых, если пост явно обманный.

Чек‑лист для модератора группы:

- Установить правила: пометка «создано AI» обязателен для опубликованных изображений.

- Быстро проверять массово репостящиеся публикации по шаблону.

- Блокировать ботов и фейковые аккаунты, создающие ажиотаж.

- Выпустить информационный пост о признаках AI‑контента для участников.

Чек‑лист для журналиста / редактора:

- Требовать исходники и подтверждение авторства.

- Использовать несколько инструментов проверки (обратный поиск, аналитика EXIF, экспертиза).

- Помнить: детектор AI — подсказка, а не доказательство.

- При сомнении маркировать материал как неподтверждённый.

Чек‑лист для бренда:

- Проводить мониторинг упоминаний и визуального контента.

- Внутренняя политика: проверка UGC (контент от пользователей) перед репостом.

- План реакции на критические случаи (см. Инцидентный план).

Инцидентный план для страниц и брендов

Если под вашим именем или брендом появилось AI‑изображение, которое вводит в заблуждение или вредит репутации:

- Оцените масштаб: сколько публикаций, охват, комментарии.

- Снимите материал с промоушена: приостановите продвижение и рекламу, чтобы ограничить дальнейшее распространение.

- Подготовьте официальное заявление: коротко опишите ситуацию и шаги по проверке.

- Опубликуйте опровержение и исправление в формате, заметном для аудитории.

- Свяжитесь с платформой и запросите удаление/метку «манипулируется четвертой стороной», если доступно.

- Проведите внутренний аудит: как это произошло, кто репостил и почему.

- Обновите политику UGC и инструкции по проверке.

Критерии приёмки (как понять, что инцидент закрыт):

- Негативное содержание удалено или помечено платформой.

- Появилось официальное опровержение/разъяснение.

- Инструменты мониторинга не фиксируют дальнейшего значительного распространения.

- Внутренняя политика обновлена и внедрена.

Когда ошибки случатся: примеры и противодействие

Противоположность успешной проверки — «когда фейк пройдёт». Частые сценарии:

- Подмена небольших сцен: фейковые фото реальных личностей в обычной обстановке.

- Манипуляции видеопостами с контекстной информацией (надписи, аудио), создающие ложное впечатление.

- Массовое дублирование: бот‑ферма репостит одну и ту же фальсификацию на тысячи аккаунтов — в таких случаях распознавание вручную не успевает.

Возможные контрмеры:

- Массовая автоматическая проверка мультимедиа через API обратного поиска и признаки генерации.

- Прозрачность происхождения (provenance) и обязательные метаданные публикации.

- Образовательные кампании для широкой аудитории: как распознавать основное.

Матрица рисков и рекомендации

Риски:

- Репутационный: бренды и люди теряют доверие.

- Финансовый: мошенничество и ложные объявления на торговых площадках.

- Политический: фальшивые заявления и поддельные новости могут повлиять на мнения.

Митигирующие меры:

- Политики проверки контента и обязательная пометка AI‑созданного материала.

- Инструменты мониторинга и быстрые механизмы отчёта на платформах.

- Обучение и чек‑листы для конечных пользователей и модераторов.

Мини‑методология проверки изображения (короткая)

- Контекст — кто и зачем публикует.

- Быстрый визуальный скрининг — пальцы, текст, тени.

- Обратный поиск и проверка источников.

- Запрос исходников или процесса съёмки.

- Пометка и сообщение платформе при высоком риске.

Технические и местные особенности для российской аудитории

- Яндекс Картинки и поиск по изображению иногда даёт дополнительные совпадения по региональным ресурсам — полезно при проверке локального контента.

- Локальная специфика: мемы и религиозные изображения часто циркулируют в нишевых сообществах, что усложняет проверку.

- Правила и реакция платформ могут отличаться в разных юрисдикциях; брендам стоит иметь локальные инструкции.

Глоссарий — определения в одну строку

- Generative AI — модели, создающие изображения, текст или видео по подсказкам.

- Inpainting — дорисовка или исправление частей изображения моделью.

- EXIF — метаданные файла с информацией о камере и съёмке.

- Provenance — метаданные и доказательная база происхождения медиа.

Критерии приёмки инструментов проверки

- Надёжность: инструмент должен иметь прозрачную методику анализа.

- Мультиинструментальность: использовать минимум два независимых сервиса.

- Лёгкость интеграции: API для автоматической проверки большого потока контента.

- Отчётность: наличие объяснений, почему изображение помечено как подозрительное.

Decision flowchart (упрощённая) — быстрый алгоритм действий

flowchart TD

A[Увидел подозрительное изображение] --> B{Автор надёжен?}

B -- Да --> C{Есть подтверждение/процесс?}

B -- Нет --> D[Сделать обратный поиск]

C -- Да --> Z[Можно считать достоверным]

C -- Нет --> D

D --> E{Нашёл совпадения или признаки AI?}

E -- Да --> F[Не репостить, пометить и уведомить]

E -- Нет --> G[Запросить у автора исходники]

G --> H{Предоставлено?}

H -- Да --> I[Анализ и публикация с пометкой]

H -- Нет --> F

Z --> END[Готово]

F --> END

I --> ENDКороткое объявление для соцсетей (100–200 слов)

AI‑инструменты быстро улучшаются, и теперь фейки в виде изображений и видео появляются повсюду, включая Facebook. Прежде чем лайкать или делиться, проверьте источник, сделайте обратный поиск изображения и попросите фото процесса. Это простые шаги, которые снижают распространение дезинформации и защищают вашу репутацию. Если вы ведёте страницу или бренд — внедрите правила пометки AI‑контента и процедуру быстрой проверки.

Итог: что важно помнить

- AI‑сгенерированные изображения уже повсеместны. Их будет больше, и они будут лучше.

- Нету единого инструмента для 100% обнаружения — используйте комбинацию визуальной оценки, обратного поиска и запросов исходников.

- Роли важны: обычный пользователь, модератор, журналист и бренд должны иметь свои чек‑листы и планы реакции.

- Образование и прозрачность происхождения контента — лучшие долгосрочные защитные меры.

Важно: если вы заметили знакомых, которые активно распространяют явно поддельный контент, поговорите с ними спокойно и покажите простые приёмы проверки — это самый быстрый способ снизить распространение фейков.

КОНЕЦ

Похожие материалы

RDP: полный гид по настройке и безопасности

Android как клавиатура и трекпад для Windows

Советы и приёмы для работы с PDF

Calibration в Lightroom Classic: как и когда использовать

Отключить Siri Suggestions на iPhone