Использование GPT-3 с Python: быстрый старт и лучшие практики

Шторм вокруг ИИ продолжается: выпуск ChatGPT от OpenAI привлёк массовое внимание и быстро расширил аудиторию. За первые месяцы многие сервисы и разработчики начали интегрировать модели — от генерации текстов до семантического поиска. В статье показано, как использовать модель GPT‑3 через Python, чтобы запустить собственное AI‑приложение.

Что такое GPT-3?

GPT‑3 — третье поколение генеративной трансформерной языковой модели от OpenAI. Это обученная модель с огромным числом параметров, способная генерировать связные тексты, отвечать на вопросы и решать многие задачи, которые раньше требовали ручной работы.

Определение в одну строку: GPT‑3 — это крупная языковая модель, обученная на текстах из интернета, которая предсказывает следующий фрагмент текста на основе входного промпта.

Важно: модель не «знает» факты в человеческом понимании; она воспроизводит паттерны из обучающих данных и может ошибаться или генерировать правдоподобно звучащие, но неверные ответы.

Быстрые факты

- OpenAI ChatGPT быстро набрал массовую аудиторию и послужил катализатором для множества приложений.

- OpenAI часто выдаёт стартовый кредит (в прошлом это было $18 на первый период) — проверьте текущие условия на сайте.

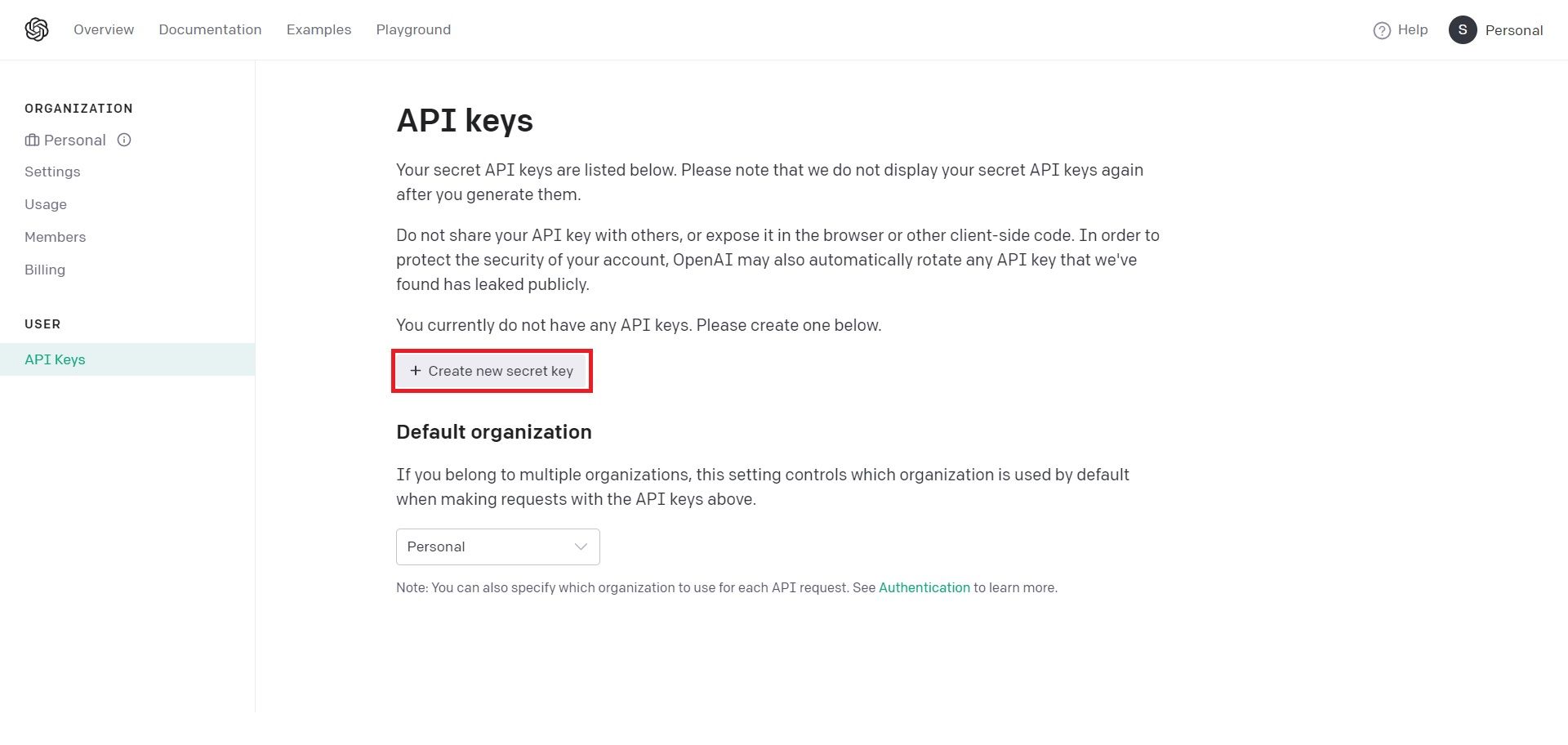

Получение API‑ключа

Чтобы работать с GPT‑3 из Python, нужен API‑ключ от OpenAI. Последовательность действий:

- Зарегистрируйтесь на сайте OpenAI и используйте тип учётной записи «Personal» или подходящий для вас.

- Откройте профиль и выберите «View API Keys».

- Нажмите «Create new secret key» для создания секретного ключа.

- Скопируйте ключ и храните его в безопасном месте — чаще всего ключ показывается только один раз.

Важно: храните ключи в переменных окружения или в защищённых секрет‑хранилищах; не встраивайте их прямо в код, если репозиторий публичный.

Установка Python‑клиента

Официальный Python‑пакет OpenAI можно установить через pip:

pip install openaiЭто добавит модуль openai, с помощью которого формируются запросы к API.

Простой пример программы на Python

Ниже — минимальный пример, собранный из исходных шагов. В примере сохраняется логика запроса, как в стандартных руководствах, — функция askGPT отправляет промпт и выводит текст ответа.

import openai

def askGPT(text):

openai.api_key = "your_api_key"

response = openai.Completion.create(

engine = "text-davinci-003",

prompt = text,

temperature = 0.6,

max_tokens = 150,

)

return print(response.choices[0].text)

def main():

while True:

print('GPT: Ask me a question\n')

myQn = input()

askGPT(myQn)

main()Пояснения к параметрам:

- engine — модель, используемая для генерации. Давинчи (text‑davinci‑003) даёт наиболее «многофункциональные» ответы в серии GPT‑3.

- prompt — входной текст (вопрос или инструкция) для модели.

- temperature — управляет разнообразием/креативностью ответов: меньшие значения — более детерминированные ответы, большие — более творческие. Значение 0.6 — разумный компромисс.

- max_tokens — максимально допустимое количество токенов в ответе. Ограничения зависят от конкретной модели и конфигурации.

Совет: храните ключ в переменной окружения, а в коде читайте его через os.environ, чтобы не сохранять секреты в репозитории.

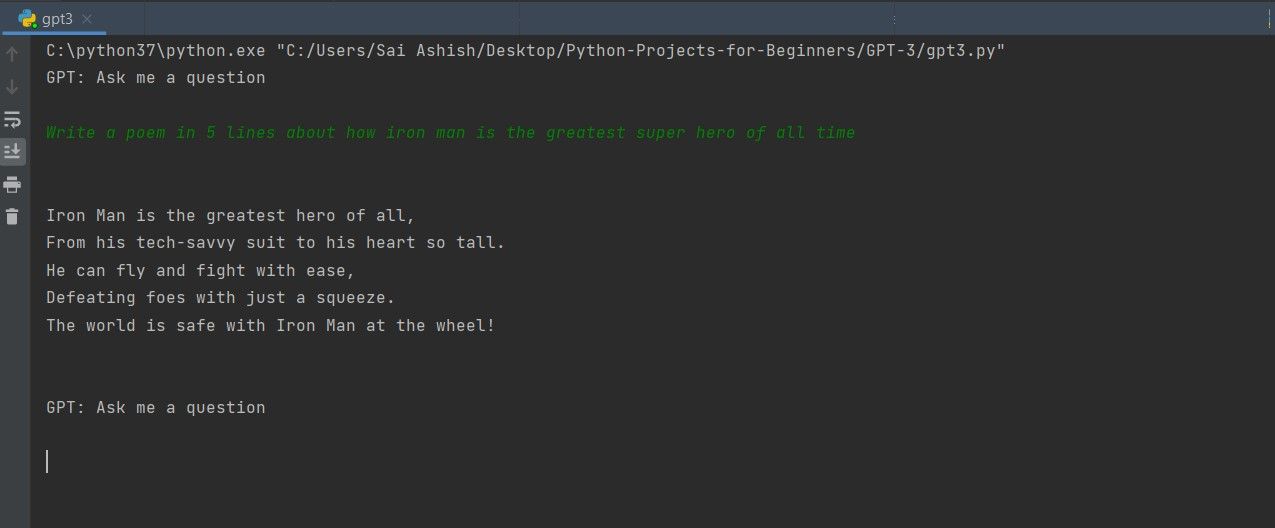

Вывод программы

При запуске программа будет запрашивать вопрос у пользователя и печатать ответ от GPT‑3. Пример вывода можно увидеть на скриншоте:

Применения GPT-3

GPT‑3 используется в широком спектре задач:

- чат‑боты и виртуальные ассистенты;

- генерация маркетинговых текстов, описаний продуктов и постов в соцсетях;

- автоматическое суммирование и анализ текстов;

- генерация кода и помощь разработчикам;

- семантический поиск и классификация текстов.

Каждая задача требует отдельного подхода к формированию промптов и пост‑обработке выходных данных.

Когда GPT-3 не подходит

- Там, где нужны строго проверяемые факты (юриспруденция, медицина) без этапа верификации человеком.

- Для обработки чувствительных персональных данных без согласия и надёжной защиты — риски утечки.

- Если требуется дет determinистичность 100% (модель даёт вероятностный ответ).

Альтернативы и гибридные подходы

- Местные (on‑premise) модели и open‑source трансформеры (например, LLaMA, GPT‑J) — подойдут, когда данные конфиденциальны.

- Комбинация правил + ML: объединять шаблоны и фильтры с генерацией модели для повышения контролируемости.

- Использовать специализированные API (например, для синтаксического анализа или извлечения сущностей), если задача узконаправленная.

Мини‑методология: как проектировать промпт

- Определите задачу и формат ответа (статья, список, JSON).

- Дайте модели контекст: примеры ввода→вывода (несколько shot‑примеров) или чёткую инструкцию.

- Ограничьте длину и стиль ответа: «Напиши формально, не более 100 слов».

- Тестируйте на наборе примеров и фиксируйте поведение при крайних случаях.

- Внедрите пост‑фильтр: проверка фактов, фильтрация токсичности, валидация формата.

Пример шаблона промпта:

“Ты — помощник технического писателя. Напиши краткое (до 100 слов) объяснение, понятное разработчику, с примером кода на Python. Ответ в формате Markdown.”

Чек‑листы по ролям

Разработчик:

- Хранение ключей в безопасном месте (переменные окружения, менеджер секретов).

- Лимит запросов и обработка ошибок API.

- Логирование запросов без секретов.

Технический руководитель / продукт:

- Определить SLO/бюджет на запросы.

- Контролировать случаи неправильной генерации и фидбек‑петлю.

Дата‑сайентист:

- Провести A/B тесты разных промптов и параметров temperature.

- Оценить метрики качества с помощью набора тестовых запросов.

Критерии приёмки

- Функция возвращает корректный ответ в 95% тестовых случаев (по утверждённому набору запросов).

- Наличие механизма обработки ошибок и повторных попыток.

- Секреты не попадают в логи и исходники.

- Ответы проходят автоматическую базовую валидацию (JSON‑валидность, длина, отсутствие запрещённых слов).

Тест‑кейсы и приёмочные проверки

- Контроль форматирования: ответ в Markdown, если требуется.

- Негативные запросы: модель не должна генерировать вредоносный контент.

- Пределы: проверка поведения при пустом промпте и при очень длинном промпте.

Безопасность и конфиденциальность

- Не отправляйте в промпт чувствительные персональные данные без правовой базы и шифрования.

- Для соответствия GDPR/локальным правилам рассмотрите минимизацию данных и хранение аудита доступа.

- Применяйте фильтры на входе/выходе и блокируйте потенциально опасные инструкции.

Примечание: политика конфиденциальности и условия использования OpenAI могут меняться — проверяйте их регулярно.

Когда модель ошибается: типовые случаи и способы смягчения

Типичные ошибки:

- Галлюцинации (достоверно звучащие, но неверные факты).

- Повторение и бессвязность при длинных ответах.

- Чувствительность к стилю и формулировкам промпта.

Как смягчить:

- Явно просите модель ссылаться на источники и, при необходимости, предоставляйте справочный контент в промпте.

- Выполняйте пост‑проверку критичных утверждений через внешние источники.

- Используйте низкий temperature для детерминированных выходов.

Примеры альтернативного использования и конфигураций

- Генерация структурированных ответов: попросите модель вернуть JSON с заранее заданной схемой и валидируйте схему.

- Параллельная генерация с несколькими параметрами temperature и выбор лучшего ответа по критериям.

- Fine‑tuning / кастомизация (если доступна) для специфичных тональностей и доменных задач.

Краткое руководство по стоимости и лимитам

Тарифы и кредиты меняются, но общая модель расходов строится на количестве используемых токенов и частоте запросов. Для прототипирования полезно ограничивать max_tokens и тестировать на небольших объёмах.

Сравнение: GPT‑3 vs локальные модели (качественно)

- GPT‑3 (облако): высокая языковая компетентность, простота интеграции, платно; меньше контроля над данными.

- Локальные модели: больше контроля над данными и затратами на длительном периоде, но потребуют настройки и инфраструктуры.

Словарь терминов (1‑строчная энциклопедия)

- Промпт — входной текст, который вы даёте модели для генерации ответа.

- Токен — единица текста (слово или часть слова), на основе которой модель работает.

- Temperature — параметр, определяющий случайность генерации.

Заключение

GPT‑3 даёт мощный набор возможностей для автоматизации текстовых задач и создания интерактивных сервисов. Начать легко: получить ключ, установить клиент и отправить базовый запрос. Однако для надёжного продакшн‑использования потребуются продуманные промпты, механизмы валидации ответов, управление секретами и оценка рисков.

Важно: проверяйте юридические и этические аспекты использования в вашей юрисдикции, особенно при работе с персональными данными.

Короткий план действий для прототипа:

- Получить API‑ключ (и сохранить его безопасно).

- Установить библиотеку openai и протестировать примеры.

- Построить набор тестовых промптов и метрик качества.

- Добавить пост‑обработку, фильтры и аудит.

Последний совет: начинайте с малого, автоматизируйте рутинные части, но всегда оставляйте контроль человека для критичных решений.

Краткое объявление (100–200 слов):

Запустите AI‑приложение за несколько часов: получите API‑ключ OpenAI, установите официальный Python‑клиент и отправьте первые запросы к GPT‑3. В статье приведены готовый минимальный пример кода, рекомендации по проектированию промптов, чек‑листы для разработчиков и тест‑кейсы для приёмки. Особое внимание уделено безопасному хранению ключей и защите персональных данных. Этот материал поможет быстро перейти от прототипа к надёжной интеграции GPT‑3 в продукт.

Похожие материалы

Градиенты в Canva: добавить и настроить

Ошибка Disabled accounts can't be contacted в Instagram

Генерация случайных чисел в Google Sheets

Прокручиваемые скриншоты в Windows 11

Как установить корпусной вентилятор в ПК