Перенос S3-бакета в Google Cloud Storage

Быстрые ссылки

- Перенос S3-бакета в Cloud Storage

Почему это важно

Если вы переходите с AWS на Google Cloud, данные в S3-бакетах нужно перенести в Cloud Storage. Cloud Storage совместим по концепции с S3 и чаще всего может заменить его с минимумом изменений в клиентских приложениях. GCP предлагает встроенные средства передачи данных, которые позволяют автоматизировать процесс и управлять политиками копирования.

В одном предложении: создайте в AWS пользователя с программным доступом и правами чтения, затем в GCP настройте Transfer Service — он выполнит копирование.

Перед началом: основные термины

- S3-бакет: хранилище объектов в AWS.

- Cloud Storage (GCS): эквивалент S3 в Google Cloud.

- Transfer Service: управляющий сервис GCP для переноса данных.

Требования и подготовка

- Аккаунт AWS с правами администратора для создания пользователя IAM.

- Аккаунт GCP с правом создания бакетов и доступа к Data Transfer.

- Список S3-бакетов и примерный объём данных (ориентировочно для планирования времени и стоимости).

Важно: для безопасного переноса лучше ограничить права IAM только чтением и перечислением (list) конкретных бакетов.

Шаг 1 — Создайте сервисного пользователя в AWS

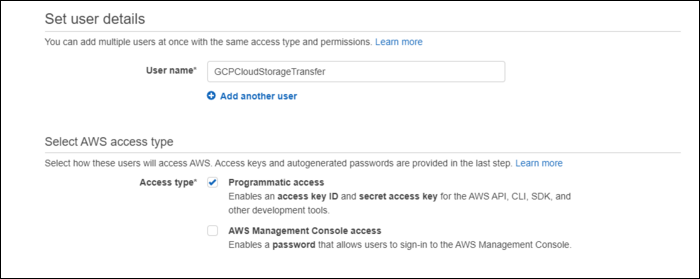

На стороне AWS в консоли IAM создайте нового пользователя и включите программный (programmatic) доступ: это сгенерирует Access Key ID и Secret Access Key. Можно использовать существующего пользователя, но удобнее создать временного.

Подпись: Форма создания нового пользователя IAM с опцией программного доступа.

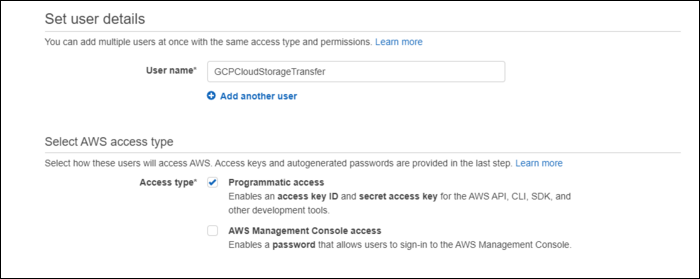

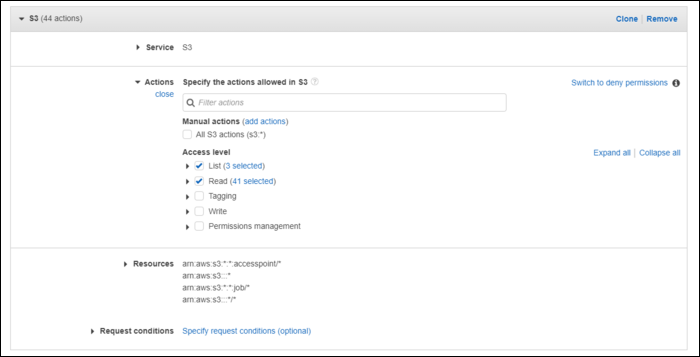

Рекомендуемые права: не давать полный AmazonS3FullAccess, если это не требуется. Лучше создать политику, дающую только чтение и перечисление для необходимых бакетов.

AmazonS3FullAccess

Подпись: Пример разрешений IAM — ограничьте доступ только необходимыми действиями (s3:GetObject, s3:ListBucket).

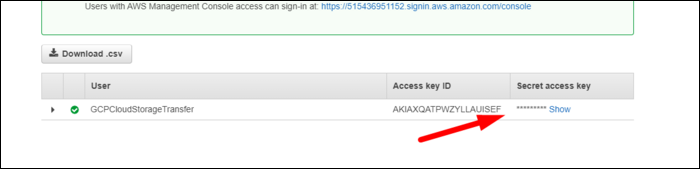

Сохраните Access Key ID и Secret Access Key — они понадобятся при настройке переноса в GCP.

Подпись: Сохраните показанные Access Key и Secret Key в надёжном месте; секрет виден только один раз.

Шаг 2 — Настройте Transfer Service в GCP

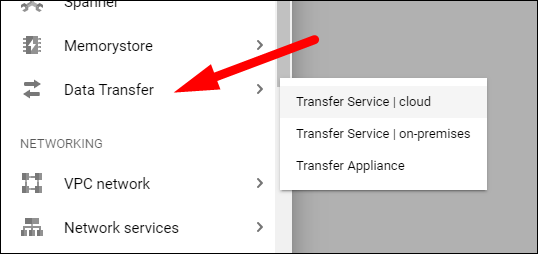

- Войдите в Google Cloud Console.

- Перейдите в Data Transfer > Transfer Service.

Подпись: Раздел Data Transfer в боковой панели GCP.

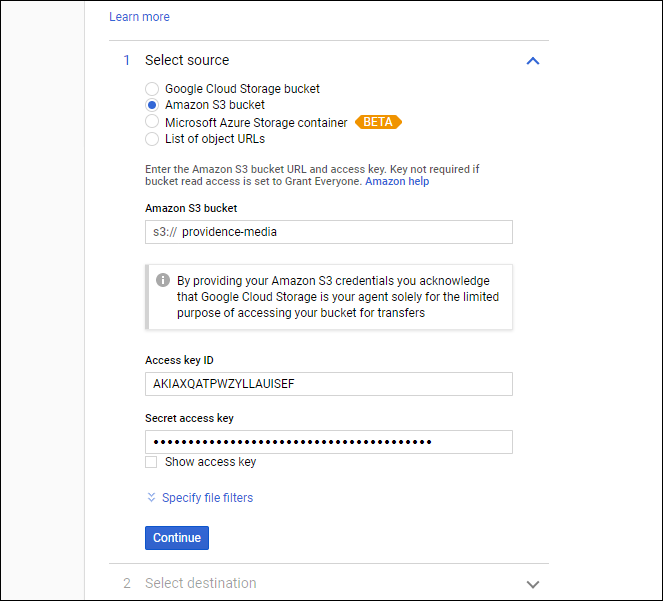

- Нажмите «Create transfer» и выберите источник “Amazon S3 Bucket”. Введите имя S3-бакета и вставьте Access Key ID и Secret Access Key.

Подпись: Поля для имени источника и AWS-ключа.

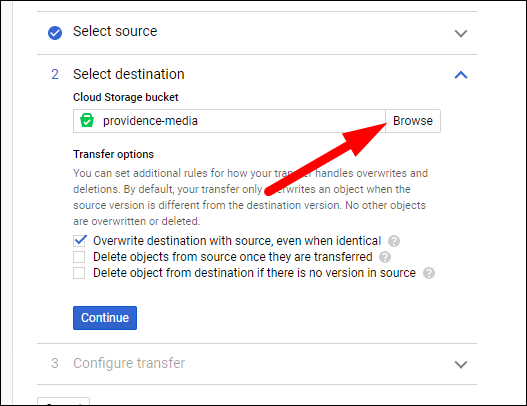

- Укажите целевой бакет в GCP. Если нужно, создайте новый через кнопку “Browse” и настройте права и локацию.

Подпись: Создание нового Cloud Storage-бакета в GCP с выбором локации и класса хранения.

- Настройте параметры переноса:

- Overwrite existing objects — перезаписывать файлы с тем же именем в целевом бакете.

- Delete source objects after transfer — удалить исходные объекты после переноса (обычно отключено до полной валидации).

- Sync options — синхронизировать так, чтобы целевой бакет соответствовал исходному (очищать лишнее).

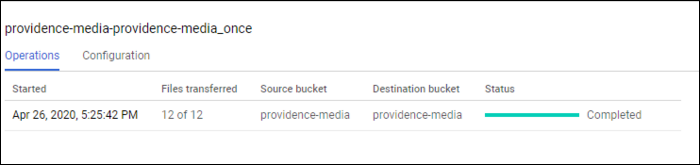

Нажмите “Continue” и затем “Create”. Трансфер запустится автоматически.

Подпись: Статус передачи данных в консоли Data Transfer; здесь видно прогресс, ошибки и статистику.

Проверка и повтор для каждого бакета

Процесс нужно повторить для каждого S3-бакета. Если бакетов много, используйте Storage Transfer API для автоматизации (способ описан ниже).

Мини-методология миграции (5 шагов)

- Оценка: список бакетов, объёмы, метаданные, классы хранения.

- Подготовка: создайте IAM-пользователя, настройте права и экспортируйте ключи.

- Копирование: настройте Transfer Service или Storage Transfer API.

- Валидация: проверьте целостность, список объектов, контрольные суммы при необходимости.

- Переключение: обновите клиентские приложения и, при успехе, удалите исходные объекты по политике.

Чек-листы по ролям

Администратор AWS:

- Создать IAM-пользователя с программным доступом.

- Настроить политику с s3:GetObject и s3:ListBucket для нужных бакетов.

- Передать ключи в безопасном канале.

Администратор GCP:

- Создать/выбрать проект.

- Проверить квоты Cloud Storage и права Data Transfer.

- Создать целевые бакеты и назначить права доступа.

Инженер по миграции:

- Настроить Transfer Service и протестировать на малом наборе данных.

- Провести валидацию и отчёты по ошибкам.

- Автоматизировать через API при множестве бакетов.

Критерии приёмки

- Все объекты из списка бакетов скопированы в целевые бакеты.

- Размер и количество объектов совпадают (или отклонения документированы).

- Критические файлы доступны и читаются клиентскими приложениями.

- Политики доступа настроены и тест пройден на примерном трафике.

Когда ручной Transfer Service не подходит (контрпример)

- Бакетов слишком много для ручного создания задач — используйте Storage Transfer API.

- Требуются тонкие настройки скорости или шифрования на лету — может потребоваться собственный ETL/скрипт.

- Если нужно переносить метаданные, которые не поддерживаются напрямую — потребуется специальная обработка.

Альтернативные подходы

- Storage Transfer API — позволяет автоматизировать перенос для сотен бакетов.

- gsutil rsync/gsutil cp при частичной миграции и если вы можете сперва поставлять данные на промежуточный сервер.

- Поставщики третьих сторон и миграционные сервисы, если нужен полностью управляемый перенос.

Безопасность и соответствие

- Не храните AWS Secret Access Key в открытом виде. Используйте секретные хранилища (Secret Manager) или временные креденшелы.

- Ограничьте IAM-политику по принципу наименьших привилегий.

- Проверьте требования по хранению и шифрованию данных (например, GDPR) и настройте шифрование в Cloud Storage.

Рекомендации по оптимизации и стоимости

- Планируйте перенос вне пиковых периодов, чтобы минимизировать влияние на производительность и стоимость запросов.

- Если большая часть объектов редко используется, рассмотрите класс хранения Nearline/Coldline в GCP для экономии.

- Учитывайте стоимость исходящего трафика в AWS при оценке бюджета.

Решение для множества бакетов — пример потока (Mermaid)

flowchart TD

A[Список S3-бакетов] --> B{Много бакетов?}

B -- Да --> C[Запустить скрипт с Storage Transfer API]

B -- Нет --> D[Использовать Transfer Service через UI]

C --> E[Мониторинг и отчёты]

D --> E

E --> F[Валидация и переключение]Типичные ошибки и как их избежать

- Ошибка: забыли дать право list — Transfer выдаст ошибки доступа. Решение: добавьте s3:ListBucket.

- Ошибка: удалили исходные данные слишком рано. Решение: сначала проверьте целостность и функциональные тесты.

- Ошибка: не проверили квоты в GCP — создайте бакет в нужной локации заранее.

Короткая инструкция для автоматизации (примерная)

- Сформируйте JSON-описание задачи для Storage Transfer API, перечислив источники.

- Запустите через gcloud или curl с авторизацией сервисного аккаунта GCP.

- Мониторьте задания через API и логируйте результаты.

Короткое объявление (100–200 слов)

Мы переносим данные из Amazon S3 в Google Cloud Storage с помощью встроенного Transfer Service. Процесс безопасен: на стороне AWS создаётся временный IAM-пользователь с ограниченными правами, затем в GCP настраивается задача передачи, проверяются результаты и выполняется переключение клиентских приложений. Для больших объёмов или множества бакетов рекомендуется автоматизация через Storage Transfer API. Перед началом выполните оценку объёмов и настройте политики доступа и шифрование.

Итог и короткое резюме

- Перенос возможен как через UI (Transfer Service), так и через API для автоматизации.

- Всегда проверяйте права IAM и храните секреты безопасно.

- Валидация и поэтапное переключение минимизируют риски.

Важно: если у вас десятки или сотни бакетов, сразу планируйте автоматизацию — ручная настройка займёт много времени.

Краткие ключевые действия: подготовить IAM-пользователя → настроить Transfer Service → запустить и проверить → переключить трафик → при успехе удалить старые объекты по политике.

Похожие материалы

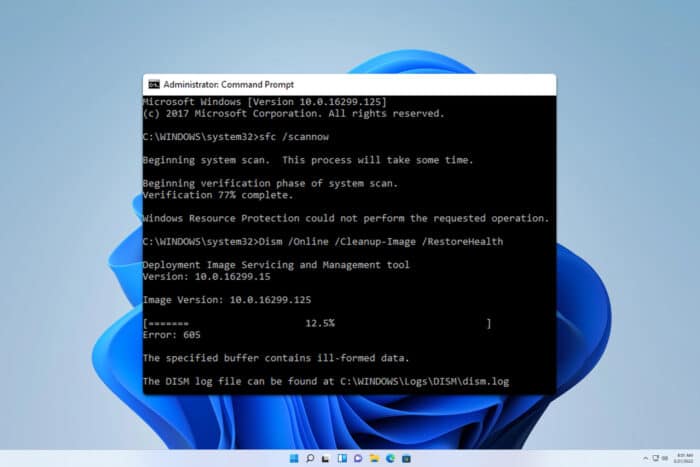

Исправить ERROR_BAD_COMPRESSION_BUFFER в Windows

Как создать и пользоваться Gmail — руководство

Удалить или временно отключить аккаунт Twitch

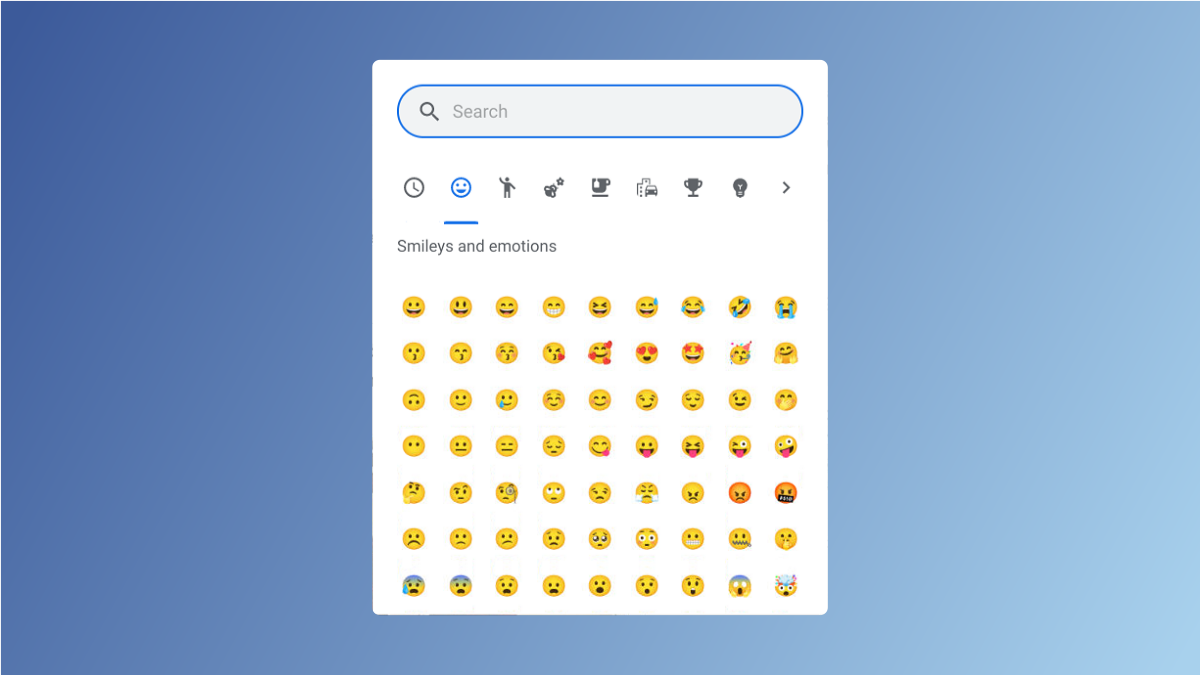

Как использовать emoji в Chrome OS

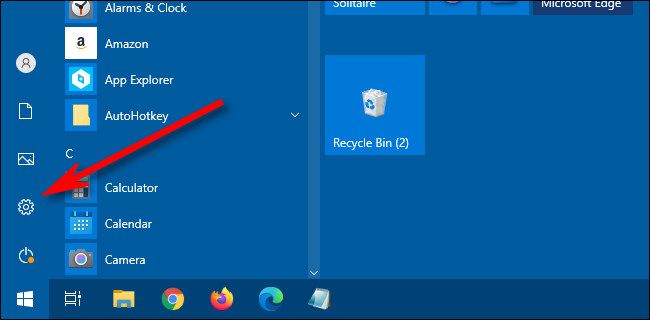

Как выбрать динамики по умолчанию в Windows 10