Как перенести S3‑совместимый бакет с помощью rclone

Кратко: rclone позволяет копировать и синхронизировать объекты между S3‑совместимыми сервисами (AWS S3, DigitalOcean Spaces, Google Cloud и др.). Настройте два “remote” в rclone, выполните первичный sync, а затем поддерживайте синхронизацию до переключения трафика.

Быстрые ссылки

- Как это работает

- Настройка rclone

- Выполнение переноса

Как это работает

Если оба сервиса — источник и приёмник — поддерживают S3‑совместимый API, можно использовать rclone для прямой копии/синхронизации объектов. rclone подключается к каждому remote, сканирует исходный бакет, копирует файлы и при необходимости обновляет уже существующие объекты на приёмной стороне.

Ключевые моменты:

- rclone сканирует содержимое исходного бакета и выполняет пообъектные операции копирования. Это даёт точный контроль, но увеличивает накладные расходы при большом числе объектов.

- При активной записи в исходный бакет можно выполнить крупную первоначальную передачу, затем запустить повторный sync для выравнивания изменений. Для окончательного переключения обычно требуется короткий период синхронизации/даунтайма.

- При миллионах объектов или терабайтах данных ожидайте часы или даже дни на полную передачу — зависит от пропускной способности и числа параллельных потоков.

Когда rclone не подходит:

- Требуется минимальное прерывание в реальном времени с нулевым дедуптаймом: лучше рассмотреть коммерческие решения с репликацией (например, NetApp Cloud Sync) или специализированные миграционные сервисы облачных провайдеров.

- Если у вас сложные политики доступа, шифрование на стороне сервера или нестандартные метаданные, проверьте совместимость перед массовой миграцией.

Важно: не придумывайте ключи/политики — создайте IAM‑пользователя/ключи с минимально необходимыми правами (ListBucket, GetObject, PutObject) и в тестовой среде проверьте доступ.

Настройка rclone

Удобнее всего запускать rclone с сервера или виртуальной машины, которую можно держать подключённой длительное время (через tmux/screen или systemd‑службу).

Установите rclone из менеджера пакетов:

apt install rclone -yКонфигурационный файл находится здесь:

~/.config/rclone/rclone.confДобавьте блок для AWS (или другого S3‑совместимого провайдера). Пример минимальной секции для AWS:

[s3]

type = s3

env_auth = false

acl = private

access_key_id = ACCESS_KEY

secret_access_key = SECRET_KEY

region = REGION

location_constraint = LOCATION_CONSTRAINTЗаполните ACCESS_KEY, SECRET_KEY и REGION. Для списка регионов смотрите документацию вашего провайдера.

Если вы переносите в другой сервис (например, DigitalOcean Spaces), создайте отдельный блок и укажите endpoint:

[spaces]

type = s3

env_auth = false

acl = private

access_key_id = ACCESS_KEY

secret_access_key = SECRET_KEY

endpoint = nyc3.digitaloceanspaces.comКаждому remote дайте уникальное имя в заголовке секции (в примере: s3 и spaces).

Советы по безопасности:

- Храните rclone.conf с правами 600.

- По возможности используйте временные токены или ролевое делегирование (STS) вместо долгоживущих секретов.

- Ограничьте доступ по привилегиям IAM только необходимыми действиями (ListBucket, GetObject, PutObject, DeleteObject, если нужно удалять).

Факт‑бокс

- Что требуется: rclone, доступы (ключи или роль), сеть с достаточной пропускной способностью.

- Время: от минут до дней — зависит от объёма и числа объектов.

- Наглядность: rclone поддерживает опцию -P для прогресса и лог‑файлы для аудита.

Выполнение переноса

Проверьте доступные remotes:

rclone listremotesВывод может выглядеть так:

s3:

spaces:

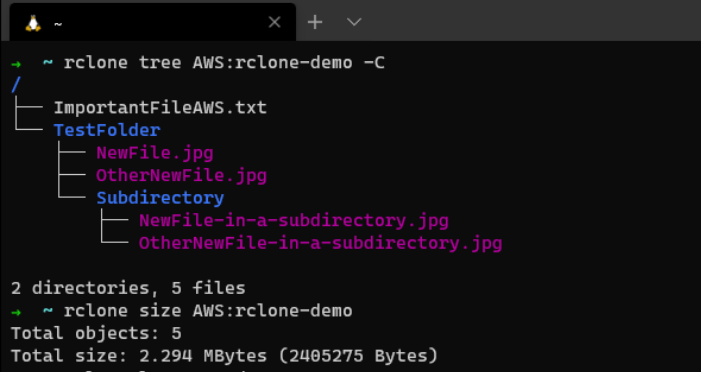

Просмотрите содержимое бакета (пример):

rclone tree s3:source-bucket

Запустите первоначальную синхронизацию. Пример команды с оптимальными флагами:

rclone sync s3:source-bucket spaces:destination-bucket -P -v --log-file /var/log/rclone/rclone-1.log --create-empty-src-dirs --s3-chunk-size 20M --s3-upload-concurrency 64 --checksumРазбор флагов:

- -P показывает прогресс и скорость, позволяет прервать и возобновить.

- -v даёт подробный вывод (можно заменить на –quiet для тишины).

- –log-file записывает логи для последующего анализа.

- –create-empty-src-dirs сохраняет пустые директории.

- –s3-chunk-size управляет размером чанков для multipart‑загрузки (зависит от провайдера).

- –s3-upload-concurrency — количество параллельных загрузок. Подберите по возможности сети и API‑ограничениям провайдера.

- –checksum ускоряет проверку целостности на некоторых провайдерах, но может увеличить чтение метаданных.

После завершения первичного sync запустите повторный rclone sync (тот же команд) для подтягивания изменений с момента первого прохода. Повторяйте до готовности переключить продуктивный трафик.

Критерии приёмки

- Все объекты из исходного бакета присутствуют в целевом (проверка количества и суммарного размера).

- Контент ключевых объектов совпадает (проверка контрольных сумм для выборки файлов).

- Права доступа и политики соответствуют требованиям безопасности.

- Тестовое приложение успешно читает/записывает в новый бакет в режиме «песочницы».

Рекомендации по тестированию

- Перед массовой миграцией протестируйте перенос небольшого набора объектов разного типа: мелкие файлы, большие файлы (>100 МБ), иерархии папок и файлы с особенными символами в именах.

- Проверьте метаданные и заголовки (Content‑Type, Cache‑Control), если приложения на них полагаются.

Альтернативные подходы

- Использовать встроенные сервисы провайдеров (например, Google Cloud Storage Transfer Service) для минимизации ручных настроек.

- Коммерческие решения с репликацией и мониторингом (NetApp Cloud Sync, собственные миграционные команды облачных провайдеров).

- Скрипты на базе AWS CLI + параллелизация (aws s3 sync), если целевая и исходная стороны — AWS.

Когда использовать альтернативы

- Нужна синхронизация в реальном времени или near‑zero downtime.

- Требуется сложная трансформация данных во время переноса.

- Необходимо выполнение политик соответствия/аудита, которые rclone не покрывает напрямую.

Мини‑методология переноса

- Планы и полномочия: составьте список бакетов, владельцев, объёмов, политик доступа. Назначьте ответственных.

- Подготовка: создайте учетные данные и remotes в rclone, настройте логирование и мониторинг.

- Тестовая миграция: перенесите небольшой набор файлов, проверьте целостность и поведение приложений.

- Первичный перенос: выполните rclone sync с оптимальными флагами.

- Ретросинхронизация: периодические повторные sync до переключения трафика.

- Переключение: короткий даунтайм или постепенный cutover, проверка работоспособности.

- Закрытие: удалить доступы старого бакета при завершении и сохранить логи миграции.

Решение: дерево для выбора метода

flowchart TD

A[Начать миграцию S3] --> B{Оба провайдера S3‑совместимы?}

B -- Да --> C[Использовать rclone]

B -- Нет --> D[Рассмотреть провайдерские инструменты]

C --> E{Требуется near‑zero downtime?}

E -- Да --> F[Коммерческая репликация или сервисы провайдера]

E -- Нет --> G[Запустить rclone sync + финальный cutover]

D --> H[Оценить API/конвертацию форматов]

F --> GЧек‑листы по ролям

Для облачного администратора:

- Создать IAM‑пользователей/ролей с минимальными правами.

- Настроить логирование rclone и ротацию логов.

- Мониторить использование сети и лимиты API.

Для DevOps инженера:

- Настроить tmux/systemd для длительных задач.

- Подобрать оптимальные значения –s3-chunk-size и concurrency.

- Провести нагрузочные проверки копирования.

Для инженера безопасности:

- Проверить политики доступа и шифрование (SSE‑S3/SSE‑KMS).

- Убедиться, что секреты хранятся безопасно (secrets manager или KMS).

Для QA:

- Провести выборочные проверки контрольных сумм.

- Прогнать функциональные тесты приложения с новым бакетом.

Советы по производительности

- Увеличьте –s3-upload-concurrency при наличии полосы и при отсутствии throttling со стороны API.

- Подбирайте –s3-chunk-size в зависимости от средней длины объектов; большие файлы выгодно грузить чанками для multipart.

- Используйте несколько параллельных процессов rclone с разными префиксами, если провайдер ограничивает одни соединения.

Замечания по совместимости

- Некоторые провайдеры отличаются в поддержке метаданных или ACL. Тестируйте перенос метаданных отдельно.

- При переходе между провайдерами учтите возможные различия в поддержке версионирования объектов.

Итог

rclone — простой и гибкий инструмент для миграции S3‑совместимых бакетов. Он отлично подходит для большинства сценариев миграции, особенно когда обе стороны поддерживают S3 API. При больших объёмах или жёстких требованиям по дедлайнам рассмотрите специализированные решения и обязательно протестируйте процесс до выполнения миграции в продакшн.

Важно: всегда сохраняйте логи миграций и проверяйте контрольные суммы для критичных файлов.

Похожие материалы

GCP Compute Engine: запуск и подключение

Установить Android на Raspberry Pi

Отключить Snipping Tool в Windows 11

Как установить Ubuntu на Surface Pro

BitLocker Auto Unlock: включение и отключение в Windows 11