GCP Cloud Storage: стоимость, создание бакета и лучшие практики

Быстрые ссылки

Какова стоимость GCP Cloud Storage?

Создание бакета

Какова стоимость GCP Cloud Storage?

Google Cloud Storage по структуре цен очень похож на AWS S3: разные классы хранения для разных сценариев использования. Приведённые ниже цены — ориентир для региона us-east1 (один из крупных и относительно дешёвых регионов). Эти значения могут меняться, поэтому проверяйте актуальные тарифы в консоли.

- Standard Storage — $0.020 за ГБ в месяц, подходит для общего назначения и активно используемых данных.

- Nearline Storage — $0.010 за ГБ в месяц, для редко запрашиваемых данных; минимальное хранение 30 дней и отдельная плата за доступы.

- Coldline Storage — $0.004 за ГБ в месяц, для данных с редким доступом (например, раз в квартал).

- Archive Storage — $0.0012 за ГБ в месяц, для долговременной архивации; минимальный срок хранения — 365 дней и высокая плата за восстановление. В отличие от AWS Glacier Deep Archive, объекты доступны в миллисекундах.

Важно: многорегиональные и региональные развёртывания отличаются стоимостью и задержкой. Хранение данных в широкой мультирегиональной области повышает отказоустойчивость и уменьшает пиковую задержку для глобальных пользователей, но стоит дороже: например, для региона «US (Multi-region)» стандартное хранение может быть около $0.026/ГБ.

Пояснение по вычислению затрат:

- Стоимость хранения = сумма (GB × цена класса × дни/месяц).

- Отдельно оплачиваются исходящий трафик, операции (PUT/GET/Class A/B) и восстановление для архивных классов.

Когда стоит выбирать конкретный класс:

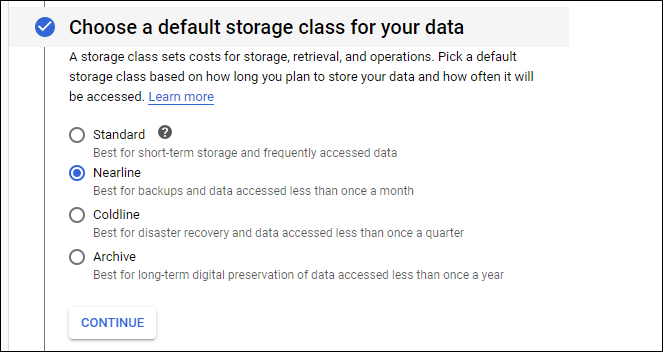

- Standard: частые чтения/записи, CDN-контент, активные приложения.

- Nearline: резервные копии, журналы, редко используемые архивы с возможностью восстановления в пределах дней.

- Coldline: архив с редким доступом, но более низкой ценой за хранение.

- Archive: долгосрочное хранение, минимальная стоимость хранения, высокая задержка и цена доступа при восстановлении.

Противопримеры/когда это может не подойти:

- Для миллисекундных транзакций с тысячами мелких изменений в секунду объектное хранилище не заменит распределённую базу данных.

- Для интенсивных операций с метаданными и произвольными запросами по полям лучше подойдёт специализированная БД.

Факторы, влияющие на TCO (качественно):

- Частота доступа, исходящий трафик, требования к латентности, требования к соответствию и резервированию, и сложность управления версиями и политиками жизненного цикла.

Основные варианты развёртывания и сценарии использования

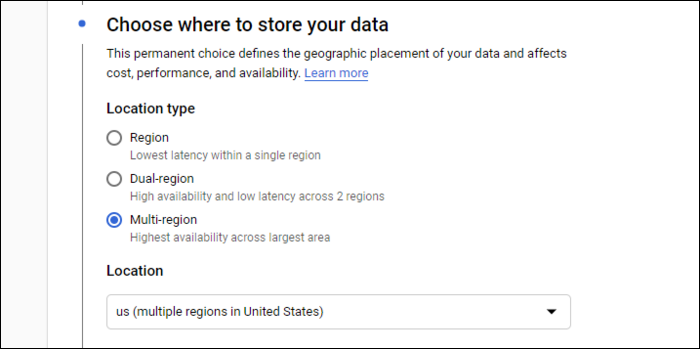

- Single-region — данные хранятся в одном регионе, минимальная цена, низкая внутренняя задержка для локальных пользователей.

- Dual-region — зеркалирование между двумя регионами; полезно для HA и соблюдения доступности в двух географических точках, но дороже.

- Multi-region — высокая доступность по большому географическому покрытию; лучший выбор для глобальных статических ресурсов (изображения, медиаконтент).

Создание бакета через консоль

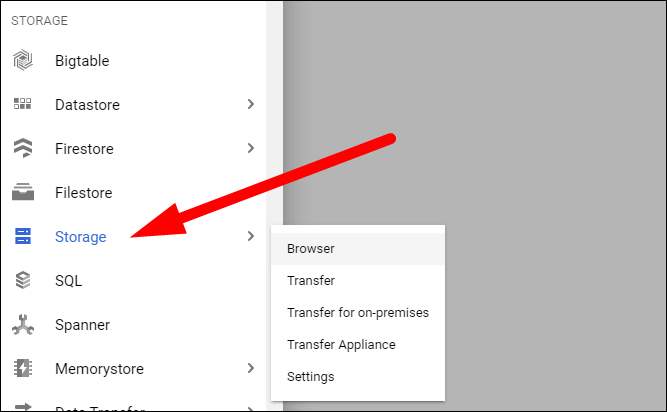

- В консоли GCP откройте раздел “Storage” → “Browser”.

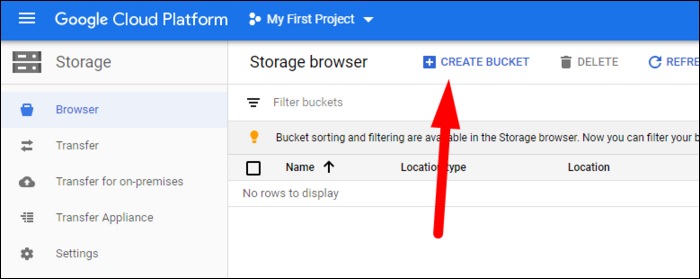

- Нажмите “Create bucket” и заполните форму:

- Имя бакета должно быть глобально уникальным (через весь GCS).

- Выберите тип расположения: Multi-region / Dual-region / Single-region.

- Выберите класс хранения по умолчанию: это будет класс для объектов, загруженных без явного указания класса.

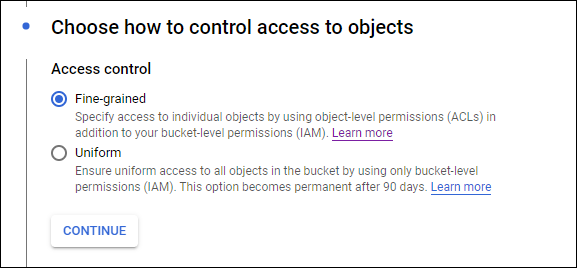

- Уровень доступа: Uniform (простой, применимо к бакету целиком) или Fine-grained (контроль на уровне объекта). Для публичных статических ресурсов часто удобен uniform; для смешанных сценариев — fine-grained.

Нажмите “Create” — бакет появится в списке.

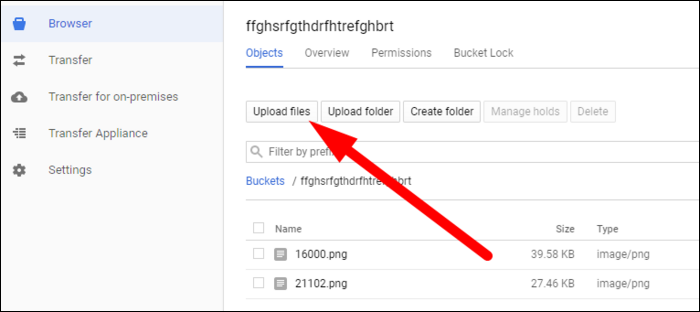

Для тестовой загрузки можно воспользоваться интерфейсом консоли:

Создание и доступ через командную строку (gsutil)

Утилита gsutil — стандартный инструмент для работы с GCS. Она поставляется с Google Cloud SDK.

Установка SDK (пример для Unix-подобных систем):

curl https://sdk.cloud.google.com | bashИнициализация/авторизация:

gcloud initgsutil пример загрузки:

gsutil cp file.txt gs://bucket-nameСоздание бакета через gsutil:

gsutil mb -l us-east1 gs://my-unique-bucket-nameСовет: исполняйте gsutil на CI/CD агенте или машине с привязанной сервисной учётной записью для автоматизации.

Доступ из приложений

- Клиентские библиотеки Cloud Storage доступны для основных языков (Python, Java, Go, Node.js, PHP, Ruby и т. д.).

- Можно использовать REST API напрямую, если нужно тонко управлять запросами.

При доступе из серверного приложения рекомендуется использовать сервисные аккаунты с принципом наименьших привилегий (roles/storage.objectViewer, roles/storage.objectAdmin и т. п.).

Миграция с S3

Google предоставляет инструменты и рекомендации для миграции данных из S3. Подходы:

- Инструменты командной строки/скрипты с параллельной загрузкой (aws s3 cp / gsutil cp), либо специализированные инструменты миграции.

- Использовать временные виртуальные машины для «прокачки» трафика между сервисами.

- Проверять метаданные и политики ACL, т.к. модели прав в S3 и GCS отличаются.

Рекомендации при миграции:

- Сначала протестируйте на небольшом объёме данных и проверьте целостность.

- Пропишите план отката (например, сохранить данные на S3 до завершения).

- Автоматизируйте перевод ссылок и конфигураций (CDN, ссылки в приложениях).

Рекомендации по безопасности и соответствию

- Используйте сервисные аккаунты и роли IAM вместо открытого доступа.

- Включите Object Versioning для резервирования и защиты от неожиданного удаления.

- Настройте политики жизненного цикла (lifecycle) для автоматического перехода объектов в более дешёвые классы или удаления.

- Шифрование: по умолчанию GCS шифрует данные, можно использовать собственные ключи (CMEK) для усиления контроля.

- Логи доступа: включите Storage Access Logs и Audit Logs для соответствия и расследования инцидентов.

Безопасность — чеклист по ролям:

- Для DevOps:

- Настроить сервисные аккаунты с ограниченным набором прав.

- Включить аудит и доступ к логам.

- Автоматизировать lifecycle и резервирование.

- Для разработчиков:

- Избегать встраивания ключей в код.

- Использовать клиентские библиотеки с автообновлением токенов.

- Для специалиста по безопасности:

- Проверить шифрование и хранение ключей.

- Настроить контроль доступа и отзывы прав.

Политики жизненного цикла и оптимизация затрат

- Настройте автоматический переход объектов в Nearline/Coldline/Archive через политики lifecycle в зависимости от возраста и шаблонов доступа.

- Очистка временных и устаревших объектов снижает стоимость хранения и упрощает соответствие.

Мини-методология для оптимизации расходов (3 шага):

- Категоризируйте данные по частоте доступа (горячие/тёплые/холодные).

- Настройте lifecycle для автоматического перемещения/удаления.

- Мониторьте счёт и операции, корректируйте пороги.

Тесты и критерии приёмки

- Успешная загрузка/загрузка файла через gsutil и клиентскую библиотеку.

- Объект доступен с ожидаемыми правами (public/private).

- Политики lifecycle применены и работают (проверка на тестовом объекте).

- Журналы доступа включены и содержат ожидаемые записи.

Частые ошибки и когда это не работает

- Неправильные права на уровне бакета или объектa (проблемы с доступом).

- Неправильно выбранный класс хранения — неожиданно высокие счета при частых доступах.

- Забытая минимальная длительность хранения (Nearline/Coldline/Archive) приводит к неожиданным штрафам при удалении.

Контрольный список для деплоя в прод

- Назначены сервисные аккаунты и роли IAM.

- Настроено шифрование и управление ключами (при необходимости CMEK).

- Включены логи доступа и аудит.

- Настроены lifecycle и версии объектов.

- Выполнены тестовые загрузки/восстановления.

Короткая инструкция по откату (runbook)

- При ошибке миграции — остановить процесс и зафиксировать состояние данных.

- Восстановить данные из исходного S3-репозитория (если сохранены) или из snapshot’ов.

- Вернуть DNS/URL на прежний CDN/источник, если применимо.

- Провести анализ причин и скорректировать скрипты/параметры.

Ментальные модели и эвристики

- “Холодные данные стоят дешёво, но дороже извлечь” — выбирайте class на основе частоты доступа и стоимости извлечения.

- “Много копий ≠ лучшее покрытие” — мульти-регион повышает доступность, но не нужно дублировать данные во всех AZ вручную.

Краткий глоссарий

- Бакет — контейнер для объектов в GCS.

- Объект — единица хранения (файл и метаданные).

- Lifecycle — политика автоматического управления классом или удалением объектов.

Итог

GCP Cloud Storage — гибкое и масштабируемое объектное хранилище, подходящее для разных сценариев: от CDN-ресурсов до долговременных архивов. Сравнивая стоимость с AWS, учитывайте тип данных, частоту доступа и требования к доступности. Перед миграцией проводите тестовые прогоны и автоматизируйте процессы управления жизненным циклом и правами доступа.

Важное: перед массовой миграцией всегда проверяйте текущие тарифы и условия минимального хранения для выбранного класса.

Похожие материалы

RDP: полный гид по настройке и безопасности

Android как клавиатура и трекпад для Windows

Советы и приёмы для работы с PDF

Calibration в Lightroom Classic: как и когда использовать

Отключить Siri Suggestions на iPhone