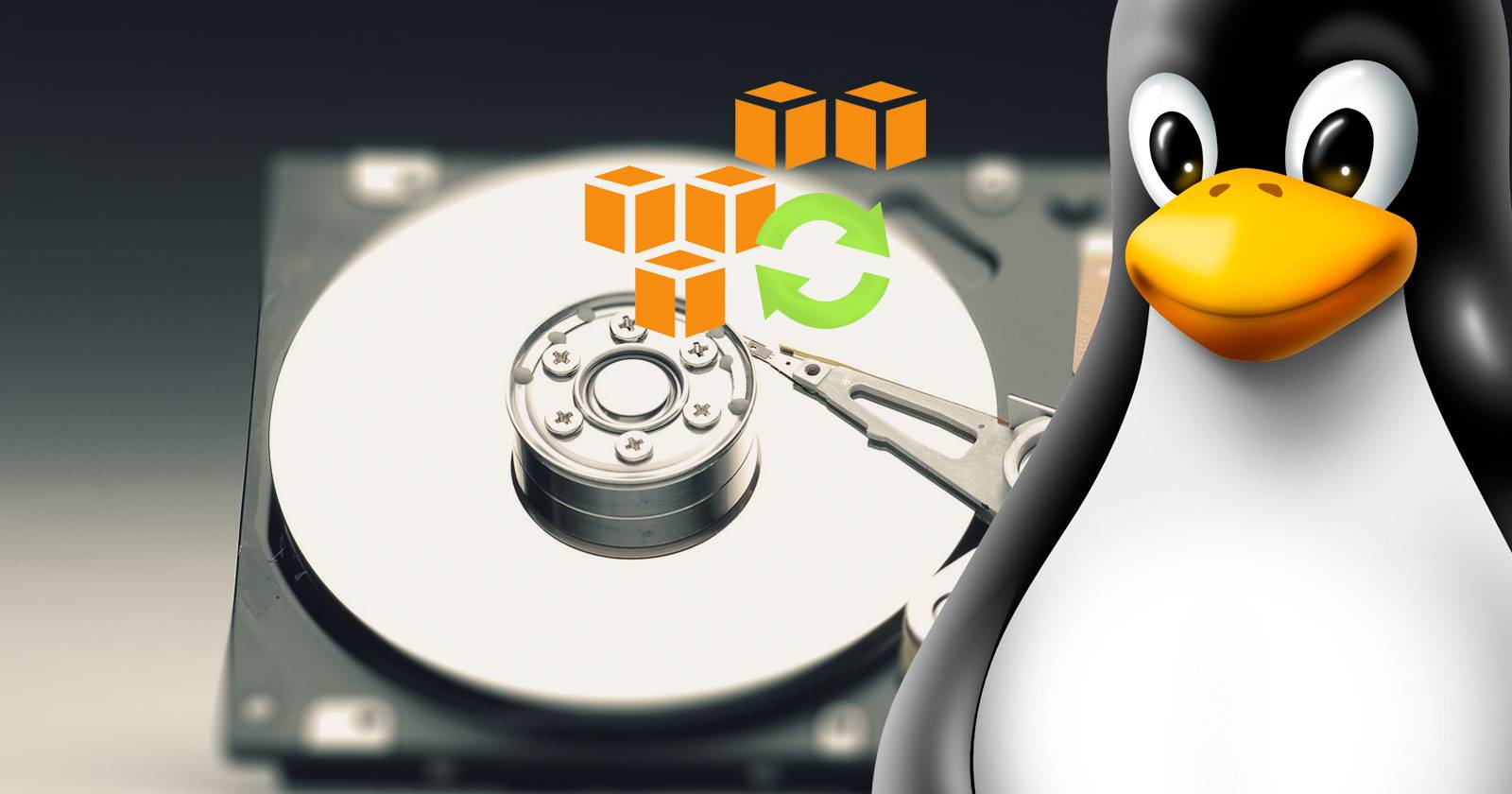

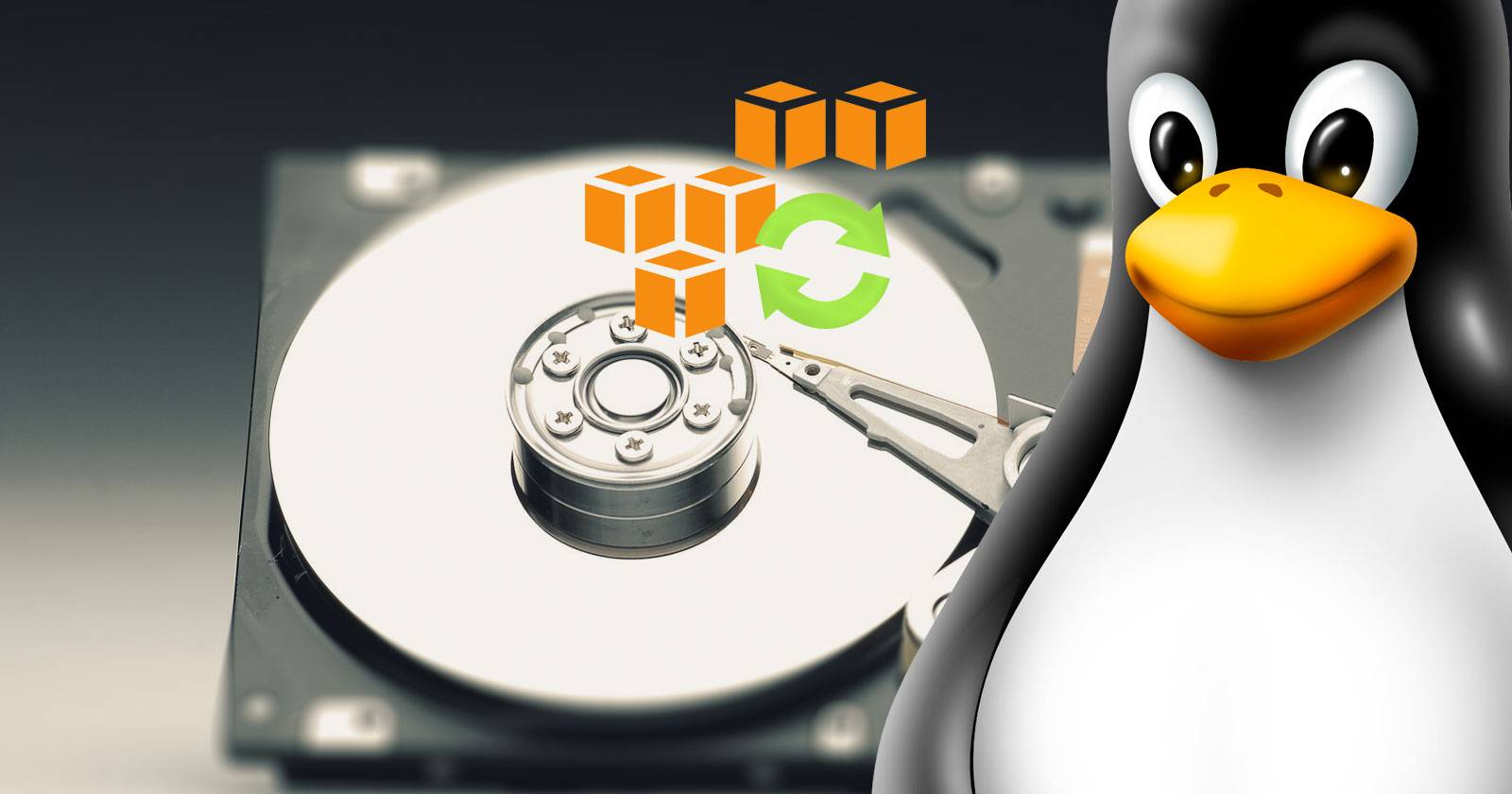

Как использовать Amazon S3 для резервного копирования личных данных

- Amazon S3 — Object Storage от AWS, подходит для резервного копирования больших объёмов данных благодаря высокой надёжности и гибким классам хранения.

- Для домашнего пользователя оптимальна комбинация S3 Standard для активных данных и Glacier/Deep Archive для долгосрочного архива.

- Настройте IAM-пользователя с минимальными правами, включите MFA, используйте CLI (s3cmd или aws-cli) или GUI (Cloud Explorer, rclone, Cyberduck) для синхронизации и автоматизации.

- В статье — пошаговые инструкции, чек-листы, примеры команд, сценарии резервного копирования, матрица сравнения и руководство по оптимизации затрат.

В 2015 году Code 42 (разработчики CrashPlan) отказались от поддержки домашних пользователей, и многие искали замену для своих больших архивов фотографий, документов и мемов. На рынке облачных провайдеров мировым лидером по масштабам и функциональности остаётся Amazon Web Services (AWS). Кривая обучения может показаться крутой, но в основе работа с S3 вполне понятна: создаём аккаунт, настраиваем безопасность, подбираем классы хранения и настраиваем синхронизацию.

В этой статье вы найдёте подробную инструкцию для домашнего пользователя: от регистрации и безопасности до автоматизации резервного копирования, оптимизации затрат и сценариев восстановления. Материал ориентирован на Linux, но общие принципы применимы и к macOS/Windows.

Что такое S3 и для чего он годится

Amazon Simple Storage Service (S3) — это объектное хранилище, оптимизированное под хранение файлов (объектов) и метаданных. Объектное хранилище не предназначено для запуска операционных систем или работы с блочными устройствами; его задача — хранение и выдача объектов по API.

Коротко:

- Объект = данные + метаданные + ключ (имя объекта).

- Высокая долговечность: AWS указывает гарантию долговечности для стандартного слоя (много девяток в процентной форме).

- Максимальный размер одиночного объекта до 5 ТБ.

- Подходит для резервных копий, архивов, медиатеки, дампов баз данных и дистрибутивов.

Важно: S3 — это не сетевой диск. Если нужна файловая система с POSIX, рассматривайте другие сервисы (например, Amazon EFS для Linux или локальные решения).

Классы хранения и их применение

S3 предлагает несколько классов хранения, каждый из которых оптимизирован под определённые сценарии использования:

- Standard — для часто запрашиваемых данных; высокая доступность и долговечность; хорош для активных резервных копий.

- Infrequent Access (IA) — дешевле для хранения, дороже при доступе; подходит для данных, к которым обращаются нечасто, но быстро требуется восстановление.

- Reduced Redundancy Storage (RRS) — предназначен для воспроизводимых данных (например, маленькие превью изображений); снижает избыточность для экономии, но несёт риск потерь при катастрофе.

- Glacier и Glacier Deep Archive — самые дешёвые для хранения архива; извлечение занимает от нескольких минут до нескольких часов (для Glacier обычно несколько часов, для Deep Archive — до 12 часов и более).

Когда выбирать класс хранения:

- Активные файлы, ежедневно изменяемые — Standard.

- Долгосрочные, редкие обращения, но требование к скорости восстановления — IA или Glacier Instant Retrieval.

- Долгосрочный архив, редкие обращения — Glacier или Deep Archive.

Совет: комбинируйте классы и используйте lifecycle-политики для автоматического перевода объектов в более дешёвые классы по прошествии заданного времени.

Пример расчёта стоимости для домашнего использования

Ценообразование S3 зависит от региона и конкретных операций. В примере ниже используются ориентиры в долларах США для региона us-east-1 (Северная Виргиния). Точные тарифы лучше проверять в консоли AWS, калькуляторе и на странице цен S3.

Пример сценария:

- Храним 1 ГБ данных в S3 Standard.

- Загружено 10 отдельных файлов.

- Стоимость хранения (примерно) около $0.039 за 1 ГБ в месяц.

- Стоимость операции PUT (загрузка объектов) — около $0.005 за n-операций (в примере автор указывал стоимость запросов отдельно).

Для домашнего пользователя итоговая месячная стоимость может быть в пределах центов за гигабайт при небольших объёмах. Но помните про транзакционные платежи и стоимость извлечения для холодных классов.

Важный вывод: S3 — модель “плати за использование”. Вы не платите за резервируемые ресурсы, только за то, что храните и используете.

Бесплатный уровень и пробный период

AWS предоставляет бесплатный уровень (Free Tier) для новых аккаунтов: среди прочего в S3 это 5 ГБ хранения, 20 000 GET-запросов и 2 000 PUT-запросов в месяц в течение первых 12 месяцев. Это достаточно для тестирования и первой миграции небольших архивов.

Регистрация и интерфейс консоли

После регистрации AWS попросит привязать кредитную/дебетовую карту и подтвердить номер телефона. Консоль управления (AWS Management Console) — графический интерфейс, где вы будете создавать бакеты, настраивать IAM, запускать отдельные сервисы и просматривать биллинги.

Ключевые элементы консоли:

- Services — список всех сервисов AWS.

- Search — быстрый поиск сервисов и ресурсов.

- Account — профиль и настройки биллинга.

- Region — регион, в котором вы работаете; это важно для задержек и соответствия требованиям локального законодательства.

Совет: выбирайте ближайший к вам регион для снижения латентности. S3 доступен во всех основных регионах.

Безопасность аккаунта и IAM

Безопасность — приоритет №1. Прежде чем создавать бакеты, настройте безопасность аккаунта:

- Включите MFA для root-аккаунта (многофакторная аутентификация).

- Создайте отдельный IAM-пользователь и группу для автоматизированных задач резервного копирования.

- Применяйте принцип наименьших привилегий: выдавайте только те права, которые действительно нужны.

Шаги

- Откройте Services > Security, Identity & Compliance > IAM.

- Включите MFA для root-учётной записи: Security > Activate MFA on your root account > Manage MFA.

- Создайте группу: Groups > Create New Group. Назовите её, затем в фильтре найдите политику S3 и присвойте, например, AmazonS3FullAccess или более точечную политику для чтения/записи конкретного бакета.

- Создайте пользователя: Users > Add User. Для автоматизированных операций выберите Programmatic Access. Добавьте пользователя в созданную группу.

- Сохраните Access key ID и Secret access key в надёжном хранилище (например, менеджер паролей). Secret access key показывается единожды.

Важно: если ключи утекут — удалите их и создайте новые. Не храните ключи в текстовых файлах в публичных репозиториях.

Практическая настройка виртуального MFA

- Выберите Activate MFA on your root account > Manage MFA.

- Выберите Virtual MFA device.

- Откройте Google Authenticator (или другой TOTP-клиент) и отсканируйте QR-код.

- Введите два последовательных кода из приложения в поля Authorization code 1 и Authorization code 2.

- Нажмите Activate Virtual MFA.

После этого при входе в консоль вам будет требоваться код из приложения вместе с паролем.

Группы, политики и минимальные привилегии

Для домашнего компьютера создайте отдельную группу с ограничением доступа только к S3 и добавьте в неё пользователя, чьи ключи будете использовать на компьютере. Таким образом, даже в случае компрометации ключей злоумышленник не получит доступ к остальным сервисам.

Рекомендация по политике минимальных прав (пример):

- Разрешить s3:ListBucket на конкретный бакет для просмотра списка объектов.

- Разрешить s3:GetObject и s3:PutObject только в префиксах / папках, которые вы используете.

- Запретить s3:DeleteObject, если вы хотите предотвратить удаление с удалённой стороны; либо разрешить с условием aws:MultiFactorAuthPresent для защищённых операций.

Создание бакета и правила нейминга

Каждый бакет S3 имеет глобально уникальное имя (в рамках всей AWS). При выборе имени помните:

- Используйте только строчные буквы, цифры, дефисы и точки.

- Избегайте личной информации в имени.

- Имя должно быть уникальным глобально — если кто-то уже занял имя, придётся выбрать другое.

Включите дополнительные опции при создании бакета:

- Versioning — хранение версий объектов, полезно при случайных изменениях или удалении.

- Server-side encryption — шифрование на стороне сервера (SSE-S3, SSE-KMS).

- Block Public Access — блокировать публичный доступ, если бакет не предназначен для общего доступа.

- Lifecycle rules — автоматический перевод объектов в другие классы хранения или удаление по истечении времени.

Работа с командной строкой — s3cmd и aws-cli

Командная строка удобна для автоматизации. В статье автор использует s3cmd, но также часто используют aws-cli и rclone.

Установка s3cmd на Debian/Ubuntu (пример):

sudo apt update

sudo apt install -y python3-setuptools python3-pip unzip

wget https://github.com/s3tools/s3cmd/releases/download/v2.0.0/s3cmd-2.0.0.zip

unzip s3cmd-2.0.0.zip

cd s3cmd-2.0.0

sudo python3 setup.py install(Если пакет в репозиториях актуален — можно установить через apt напрямую.)

Альтернатива — aws-cli (официальный инструмент):

curl "https://awscli.amazonaws.com/awscli-exe-linux-x86_64.zip" -o "awscliv2.zip"

unzip awscliv2.zip

sudo ./aws/installНастройка s3cmd:

s3cmd --configure

# Введите Access Key и Secret Key и укажите настройки по умолчанию

# Опционально включите шифрование пароля (Encryption)Настройка aws-cli:

aws configure

# Введите Access Key, Secret Key, регион и формат выводаПосле конфигурации протестируйте подключение:

s3cmd ls

# или

aws s3 lsОсновные команды для резервного копирования и синхронизации

Примеры команд s3cmd:

- Просмотр бакетов:

s3cmd ls- Загрузка каталога в бакет (sync):

s3cmd sync /home/user/Backup s3://my-unique-bucket-name- Синхронизация с удалением удалённых локально файлов:

s3cmd sync /home/user/Backup s3://my-unique-bucket-name --delete-removed- Удаление объекта:

s3cmd del s3://my-unique-bucket-name/path/to/file.txtЭквиваленты в aws-cli:

aws s3 sync /home/user/Backup s3://my-unique-bucket-name

aws s3 cp file.txt s3://my-unique-bucket-name/path/ --acl privateПример автоматизации в cron (ежедневно в 3:00):

0 3 * * * /usr/bin/aws s3 sync /home/user/Backup s3://my-unique-bucket-name --delete > /var/log/s3sync.log 2>&1Важно: перенаправляйте вывод в лог и периодически проверяйте логи на ошибки.

Практические сценарии и советы

- Тестовая отправка: сначала попробуйте Free Tier с 5 ГБ, чтобы убедиться, что всё работает.

- Разделяйте большие тарифы: при больших файлах используйте multipart upload для устойчивости при нестабильном интернете.

- Версионирование защищает от случайной перезаписи/удаления. Сверху добавьте lifecycle, чтобы старые версии автоматически удалялись через заданный срок.

- Для полного восстановления убедитесь, что у вас есть списки объектов и метаданные; периодически проводите проверку восстановления (disaster recovery test).

GUI-варианты для работы с S3

Если командная строка вам не по душе, есть GUI-программы:

- Cloud Explorer (как в исходной статье) — лёгкий Java-приложение.

- Cyberduck — кроссплатформенный, поддерживает S3 и другие протоколы.

- S3 Browser — популярный на Windows.

- rclone — CLI-инструмент с возможностью работы через конфигурацию и интеграции с системными задачами; также имеет графические оболочки.

Установка Cloud Explorer (пример):

sudo apt -y install openjdk-8-jre-headless ant git

git clone https://github.com/rusher81572/cloudExplorer.git

cd cloudExplorer

ant

cd dist

java -jar CloudExplorer.jarПосле запуска добавьте профиль, введя Access Key и Secret Key. Cloud Explorer поддерживает синхронизацию, но в исходной реализации не удаляет объекты в бакете при удалении локальных файлов — это нужно учитывать.

Сравнение CLI и GUI

- CLI удобен для автоматизации и интеграции в сценарии.

- GUI проще для разовых операций и визуального управления.

- Для регулярного резервного копирования лучше использовать CLI + cron/systemd timer.

Когда S3 не лучшее решение

S3 не идеален, если:

- Нужен полноценный сетевой диск с доступом через SMB/NFS.

- Требуется низкая латентность и POSIX-совместимость для базы данных в реальном времени.

- Важна нулевая стоимость запросов при частых мелких операциях — транзакционные расходы могут съесть экономию.

Альтернативы:

- Для файлового доступа: NAS или Amazon EFS.

- Для дешёвого блочного хранения: S3 для архива + локальное резервирование.

- Для приватных требований по хранению в вашей стране — локальные облачные провайдеры или интеграторы.

Оптимизация затрат

- Включите lifecycle rules: перемещайте объекты в Glacier/Deep Archive через 30/60/90 дней в зависимости от сценария.

- Объединяйте мелкие файлы в архивы (.tar/.zip) перед загрузкой — это снижает количество транзакций.

- Используйте анализатор затрат AWS Cost Explorer для мониторинга и выявления неожиданных расходов.

- Сравнивайте частоту доступа: если обращений мало — переводите в IA или Glacier.

Резервное копирование: стратегии

- Полные резервные копии: единоразовая копия всех данных. Удобно для начального бэкапа.

- Инкрементные резервные копии: сохраняют только изменения с момента предыдущего бэкапа — экономят трафик и место.

- Дифференциальные резервные копии: хранят изменения с момента последнего полного бэкапа.

Хитрости:

- Для инкрементов используйте контрольные суммы (md5, sha256) или встроенные механизмы sync-инструментов.

- Регулярно проверяйте контрольные суммы на объекте в S3.

Матрица сравнения популярных инструментов для работы с S3

| Инструмент | CLI/GUI | Поддержка multipart | Синхронизация | Автоматизация | Бесплатно |

|---|---|---|---|---|---|

| s3cmd | CLI | Да | Да | Да (cron) | Да |

| aws-cli | CLI | Да | Да | Да (cron) | Да |

| rclone | CLI/GUI | Да | Да | Да | Да |

| Cloud Explorer | GUI | Частично | Да (но не удаляет) | Ограниченно | Да |

| Cyberduck | GUI | Да | Нет | Через сценарии | Есть платная версия |

(Матрица качественная; функциональность меняется с версиями продуктов.)

Чек-лист для домашнего пользователя

Перед первой синхронизацией:

- Создать AWS аккаунт и пройти валидацию.

- Включить MFA для root-аккаунта.

- Создать IAM-группу с ограниченными правами для S3.

- Создать IAM-пользователя для автоматизации и сохранить ключи.

- Создать бакет с уникальным именем.

- Включить блокировку публичного доступа, если бакет приватный.

- Настроить versioning и lifecycle для архивации.

- Протестировать загрузку и восстановление одного файла.

- Настроить автоматизацию (cron/systemd timer).

SOP для настройки бэкапа в Linux (шаг за шагом)

- Установите aws-cli или s3cmd.

- Настройте профиль: aws configure или s3cmd –configure.

- Создайте локальную папку для бэкапов, например /home/user/Backup.

- Составьте скрипт backup-to-s3.sh:

#!/bin/bash

LOGFILE=/var/log/s3sync-$(date +%Y%m%d).log

/usr/bin/aws s3 sync /home/user/Backup s3://my-unique-bucket-name --delete >> ${LOGFILE} 2>&1- Сделайте скрипт исполняемым: chmod +x backup-to-s3.sh.

- Добавьте cron-задание: crontab -e и вставьте строку для расписания.

- Проверяйте логи каждую неделю и выполняйте тестовое восстановление раз в квартал.

Критерии приёмки резервного решения

- Файлы успешно загружаются в бакет (проверка списка и контрольных сумм).

- Восстановление 3 случайных файлов проходит без ошибок.

- Автоматизация запускается по расписанию и в логах нет ошибок.

- Старые версии и архивы перемещаются согласно lifecycle.

Тестовые сценарии приёмки

- Загрузка 10 файлов разных размеров, проверка наличия в бакете.

- Изменение одного файла локально, повторная синхронизация и проверка версии.

- Удаление локального файла и синхронизация с опцией –delete-removed; проверка удаления в бакете.

- Восстановление файла из Glacier (если использовался Glacier) — проверка времени и стоимости восстановления.

Риски и mitigations

- Утечка ключей IAM — ограничьте права, используйте ротацию ключей, храните в менеджере паролей.

- Ошибки удаления при синхронизации с параметром –delete — протестируйте на тестовом бакете.

- Скрытые расходы (вызовы API, извлечения из Glacier) — мониторьте Cost Explorer и ставьте оповещения.

Конфиденциальность и локальные требования

Если ваши данные подпадают под локальные законы о хранении персональных данных, проверьте:

- Требования по географическому расположению данных.

- Нужно ли шифрование по определённым стандартам.

- Поддерживает ли выбранный регион требования регуляторов.

S3 поддерживает шифрование серверной стороны (SSE) и интеграцию с AWS KMS для управления ключами.

Альтернативные подходы к резервному копированию

- Локальные NAS + удалённое реплицирование для быстрого восстановления.

- Гибридный подход: частые инкременты в S3 + еженедельное зеркальное копирование на локальный диск.

- Использование специализированных сервисов резервного копирования (Backblaze B2, Wasabi, Google Cloud Storage) — у каждого свои тарифы и SLA.

Ментальные модели при выборе стратегии

- “Холодный против горячего” — насколько часто вы будете обращаться к данным.

- “Стоимость хранения против стоимости восстановления” — экономия на хранении может привести к высоким затратам при извлечении.

- “Надёжность против гибкости” — более дешёвые уровни иногда уменьшают доступность и скорость восстановления.

Быстрая шпаргалка команд

s3cmd:

- s3cmd ls — показать бакеты.

- s3cmd put file s3://bucket/ — загрузить файл.

- s3cmd get s3://bucket/file ./ — скачать файл.

- s3cmd sync /local/ s3://bucket/ — синхронизировать каталог.

aws-cli:

- aws s3 ls

- aws s3 cp file s3://bucket/

- aws s3 sync /local/ s3://bucket/

rclone:

- rclone config

- rclone sync /local/ remote:bucket

Краткая матрица зрелости резервного хранения для домашнего пользователя

- Уровень 1 — ручное копирование на внешний диск.

- Уровень 2 — автоматизация локального бэкапа (cron + rsync).

- Уровень 3 — удалённые копии в облако (S3) с периодическим тестированием восстановления.

- Уровень 4 — многоуровневый подход: локальные копии + репликация между регионами + шифрование и аудит.

Маленькая таблица ключевых терминов

- Бакет — контейнер для объектов в S3.

- Объект — файл и его метаданные в S3.

- Versioning — хранение нескольких версий одного объекта.

- Lifecycle — правила автоматического управления объектами.

- IAM — Identity and Access Management, система управления доступом.

Простая диаграмма выбора класса хранения

flowchart TD

A[Нужен быстрый доступ сейчас?] -->|Да| B[Standard]

A -->|Нет| C[Нужен редкий доступ?]

C -->|Да| D[Infrequent Access или Glacier Instant Retrieval]

C -->|Нет| E[Glacier Deep Archive]

B --> F[Используйте Versioning и Lifecycle]

D --> F

E --> FШаблон политики IAM для доступа к одному бакету

Ниже — примерная структура политики (JSON) для ограничения доступа одного пользователя к конкретному бакету. Замените my-unique-bucket-name на своё имя.

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"s3:ListBucket"

],

"Resource": [

"arn:aws:s3:::my-unique-bucket-name"

]

},

{

"Effect": "Allow",

"Action": [

"s3:GetObject",

"s3:PutObject",

"s3:DeleteObject"

],

"Resource": [

"arn:aws:s3:::my-unique-bucket-name/*"

]

}

]

}Часто задаваемые вопросы и гайд по миграции

Как перенести старые бэкапы из CrashPlan?

Экспортируйте данные локально и выполните пакетную загрузку в S3 через aws-cli или s3cmd. При больших объёмах используйте multipart upload.Какие риски при использовании Glacier?

Увеличенное время и стоимость извлечения. Планируйте восстановление заранее.Как защитить данные в S3 от несанкционированного доступа?

Включите Block Public Access, используйте IAM с принципом наименьших привилегий, включите шифрование и логирование доступа (S3 Access Logs или CloudTrail).

Заключение

Amazon S3 — мощный инструмент для резервного копирования личных данных. При правильной настройке безопасности, управлении ключами и подборе классов хранения он может стать надёжной и экономичной основой вашей стратегии бэкапа. Используйте CLI для автоматизации, GUI для одноразовых операций и не забывайте про тесты восстановления — это единственный способ удостовериться, что резервная копия действительно работает.

Важно: начните с малого — используйте бесплатный уровень, протестируйте весь процесс и только потом переносите критичные данные.

Вопросы к читателям

Вы уже используете AWS для хранения? Какой инструмент предпочитаете для резервного копирования и почему? Поделитесь опытом в комментариях.

Примечание: в статье описаны качественные рекомендации и примеры конфигураций. Проверяйте актуальные цены и возможности в консоли AWS и официальной документации.

Похожие материалы

Как делиться точным местоположением с близкими

Ваше подключение не является приватным — как исправить

Как обнаружить и защититься от шпионского ПО

Центр безопасности Windows не запускается — исправить быстро

Как сканировать QR‑коды на Pixel