Kubernetes Dashboard — веб‑интерфейс для управления кластером

Kubernetes Dashboard — это официальное веб‑приложение для визуального просмотра и базового редактирования ресурсов k8s. В статье подробно описаны установка, способы доступа (локальный proxy и публичный NodePort), основные сценарии использования, советы по безопасности и чеклисты для ролей.

Быстрые ссылки

Установка панели

Исследование интерфейса

Выбор пространства имён

Создание ресурсов

Мониторинг использования ресурсов узлов

Просмотр логов Pod

Настройки панели

Рекомендации по безопасности и список задач

Kubernetes Dashboard — официальное приложение, которое позволяет просматривать и редактировать ресурсы через веб‑интерфейс. Развёртывание экземпляра Dashboard в кластере даёт возможность визуализировать активность без серии сложных команд в терминале. В статье описаны шаги установки, типичные рабочие сценарии и дополнительные рекомендации по безопасной эксплуатации и интеграции в процессы команды.

Установка панели

По умолчанию в самостоятельных инсталляциях Kubernetes панель не устанавливается. Чтобы развернуть Dashboard в кластере, примените манифест, размещённый в публичном репозитории проекта:

kubectl apply -f https://raw.githubusercontent.com/kubernetes/dashboard/v2.3.1/aio/deploy/recommended.yamlЭта команда создаст ресурсы Dashboard с рекомендованными настройками по умолчанию. Рекомендации:

- Явно фиксируйте версию манифеста (как в примере), чтобы обеспечить воспроизводимость. При необходимости обновляйте версию вручную и тестируйте изменения в стейдж‑окружении.

- Проверяйте созданные ресурсы командами kubectl get и kubectl describe, чтобы убедиться, что все компоненты запустились корректно.

Важно: Dashboard работает как обычное приложение в кластере и наследует права доступа, заданные в RBAC. Контролируйте, кому и какие права выдаёте.

Доступ к панели

Базовая установка не выставляет Dashboard публично, чтобы уменьшить поверхность атаки. Самый безопасный и рекомендуемый способ доступа при локальной работе — использовать прокси kubectl, который пробрасывает локальный порт на API‑сервер кластера:

kubectl proxyПосле запуска прокси откройте в браузере URL:

http://localhost:8001/api/v1/namespaces/kubernetes-dashboard/services/https:kubernetes-dashboard:/proxy/Запрос к localhost:8001 будет обработан kubectl proxy и перенаправлен в кластер. Это простая и безопасная опция для админов и разработчиков, у которых есть kubectl и доступ к kubeconfig.

Важно: kubectl proxy даёт доступ к API‑серверам от имени текущих креденшалов. Не оставляйте прокси работающим без надобности.

Публичный доступ

Если нужен прямой HTTP‑доступ с устройств, где kubectl недоступен, можно изменить тип сервиса Dashboard на NodePort или LoadBalancer (в зависимости от провайдера).

Откройте редактирование сервиса:

kubectl --namespace kubernetes-dashboard edit service kubernetes-dashboardНайдите строку с type: ClusterIP и измените на type: NodePort или type: LoadBalancer (если ваш провайдер поддерживает внешние балансировщики). Сохраните файл: изменения применятся автоматически.

Затем узнайте назначенный порт:

kubectl --namespace kubernetes-dashboard get service kubernetes-dashboardПример вывода:

NAME TYPE CLUSTER-IP PORT(S) AGE

kubernetes-dashboard NodePort 10.100.110.101 443:31730/TCP 1mВ примере Dashboard получил порт 31730. Теперь вы можете обратиться к панели по IP‑адресу узла кластера и этому порту.

Примечания по безопасности при публичном доступе:

- Отключайте публичный доступ, когда он не нужен.

- Оборачивайте трафик через аутентифицированный обратный прокси (например, nginx с TLS и базовой аутентификацией, oauth2_proxy или OIDC), чтобы не допускать неавторизованный доступ.

- В Kubernetes применяйте строгие правила NetworkPolicy, ограничивающие входящий трафик к сервису Dashboard.

Использование в управляемых кластерах

Многие провайдеры управляeмого Kubernetes либо включают Dashboard по умолчанию, либо предлагают установку в один клик. Если такая опция доступна, пользуйтесь ей — провайдеры обычно интегрируют дополнительные механизмы аутентификации и контроля доступа.

Пользователи MicroK8s могут активировать встроенный плагин dashboard одной командой, после чего панель будет доступна внутри кластера и привязана к ClusterIP по умолчанию.

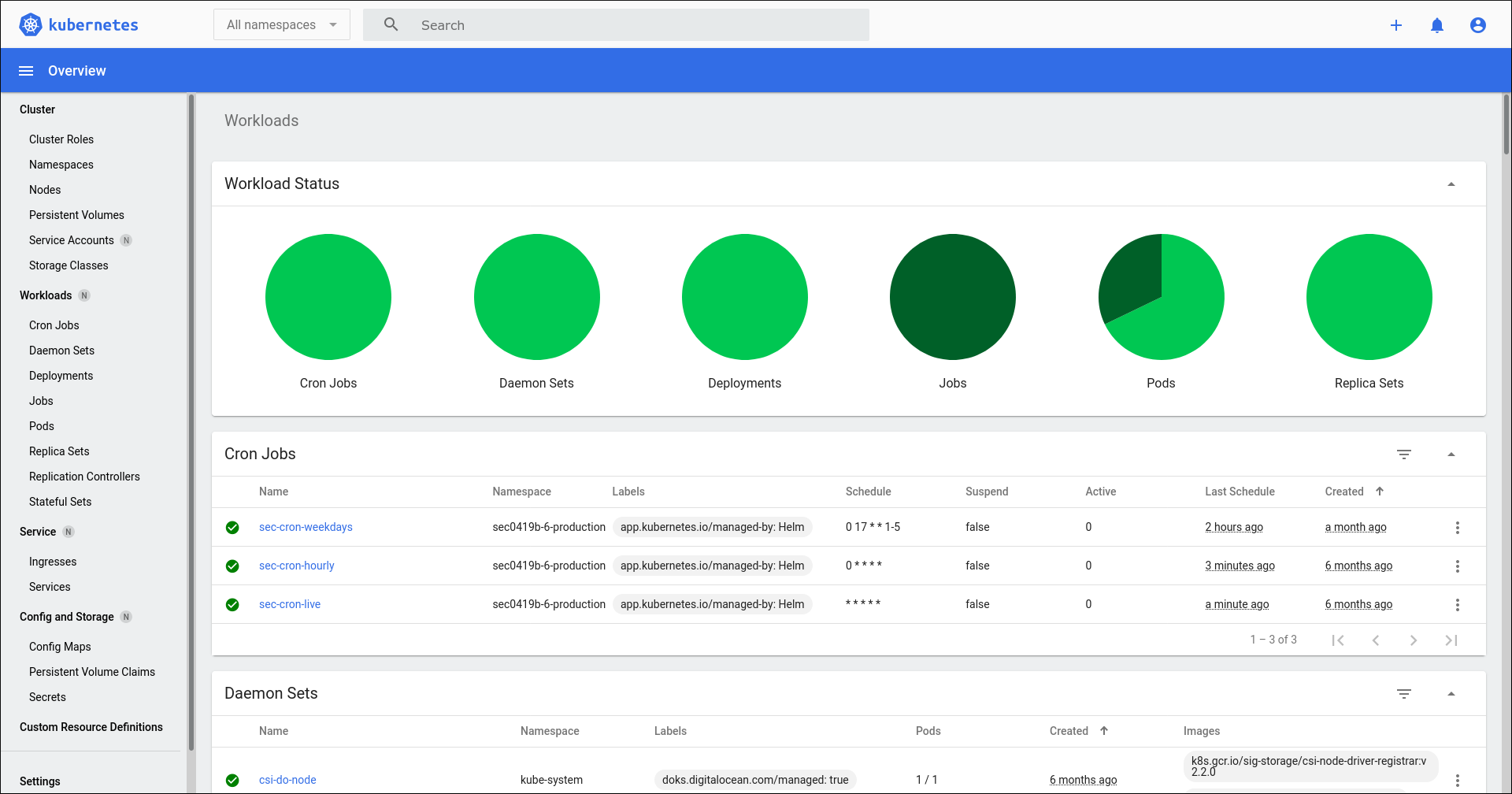

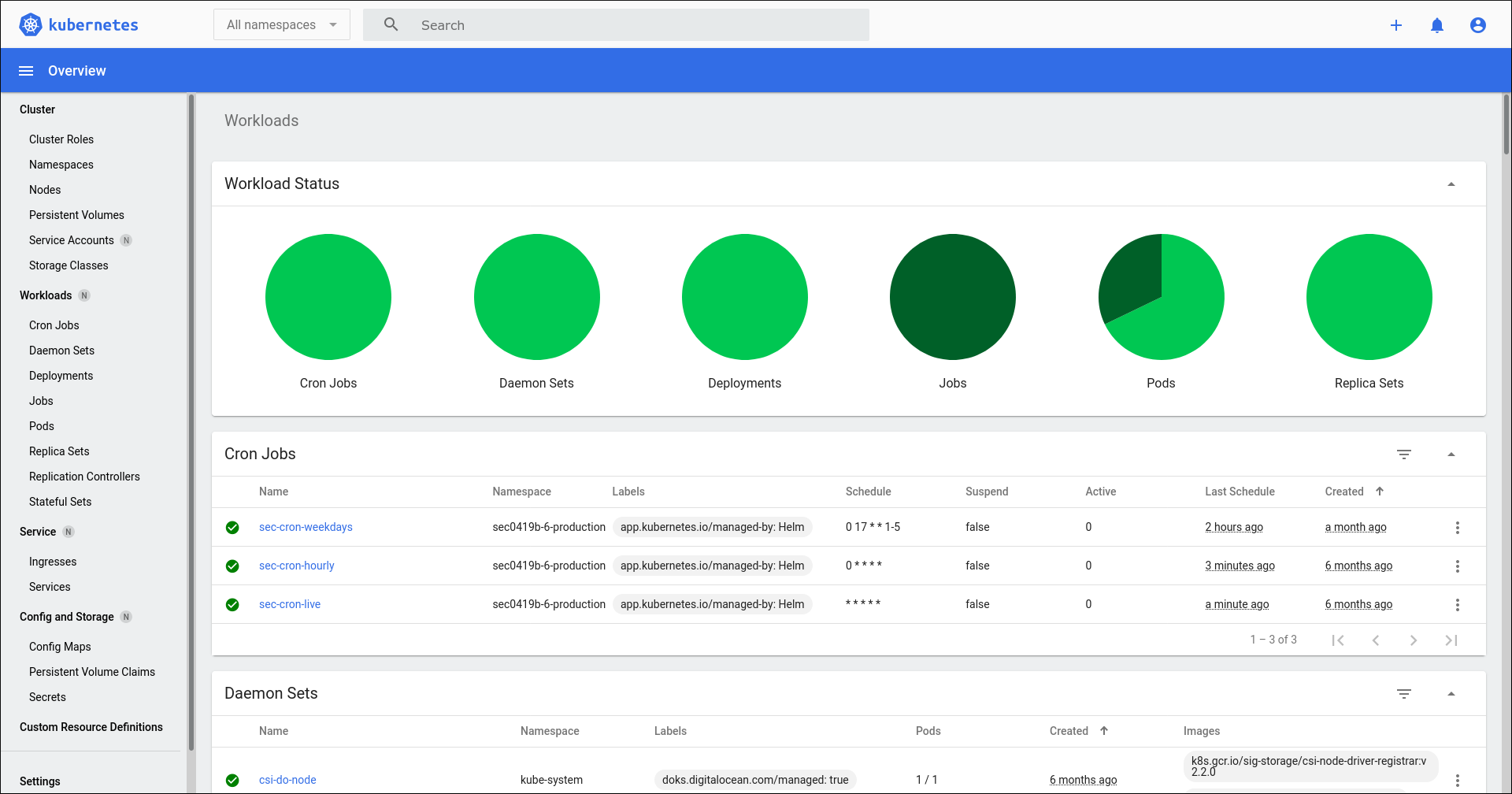

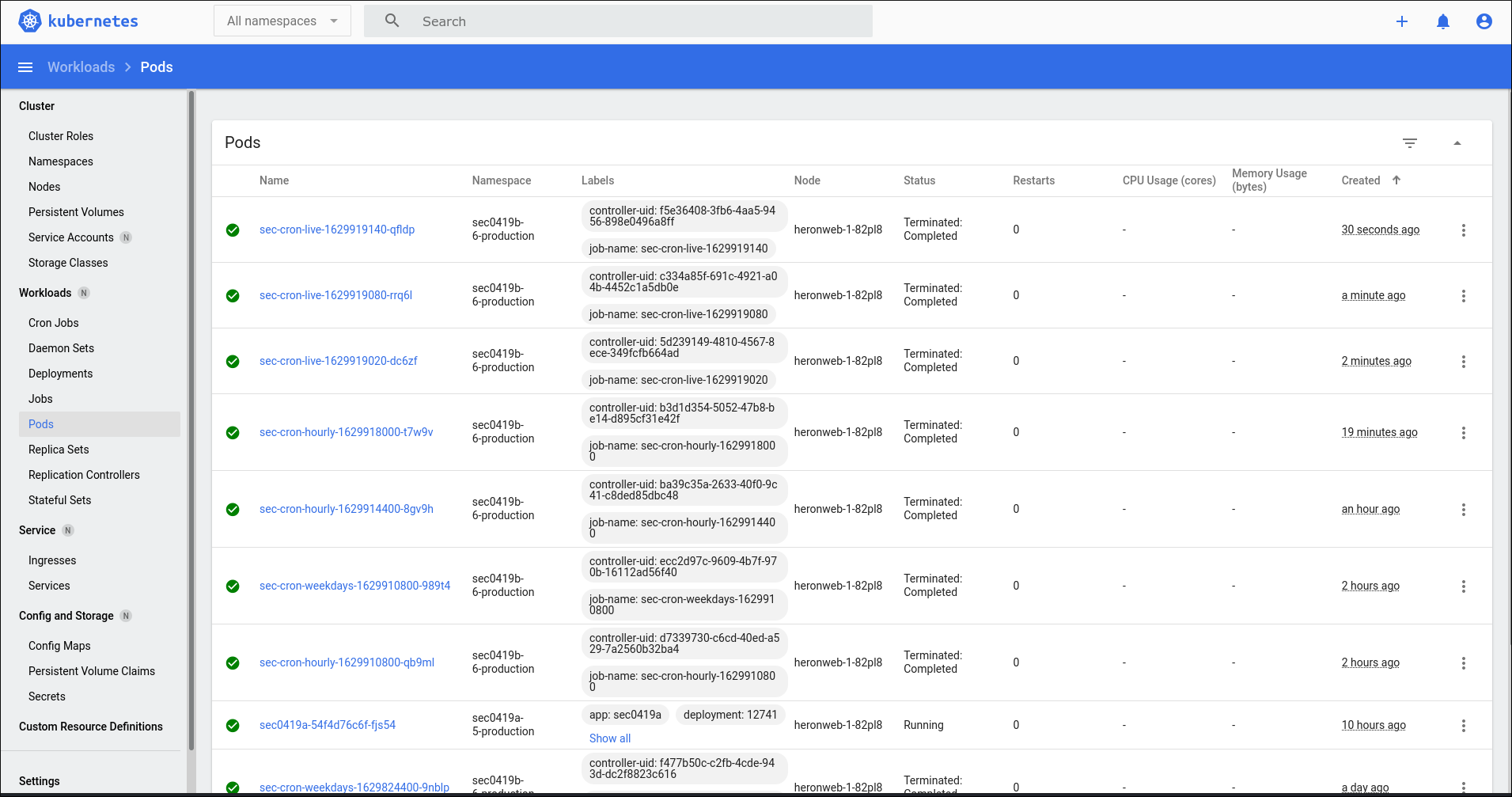

Исследование интерфейса

Главный экран Dashboard показывает обзор активности кластера. В верхней части находятся цветные круговые диаграммы, которые дают быстрый визуальный индикатор состояния ресурсов. Это упрощает оценку, требуется ли вмешательство:

- Ярко‑зелёный — ресурсы в рабочем состоянии (например, запущенные Pod’ы).

- Тёмно‑зелёный — здоровые, но остановленные ресурсы (например, завершившиеся CronJob’ы).

- Жёлтый — ресурсы в переходном состоянии (например, Pod, ожидающий загрузки образа).

- Красный — ресурс завершился с ошибкой.

Ниже диаграмм располагаются таблицы с детализацией по типам ресурсов: CronJob’ы, Deployment’ы, Pod’ы, ReplicaSet’ы, Service’ы, Volume’ы и другие. Прокрутите страницу для просмотра всех встроенных типов.

Слевая боковая панель позволяет быстро перейти к нужному типу ресурса. Нажатие на тип ресурса откроет отдельную страницу с таблицей и детальным представлением выбранного ресурса.

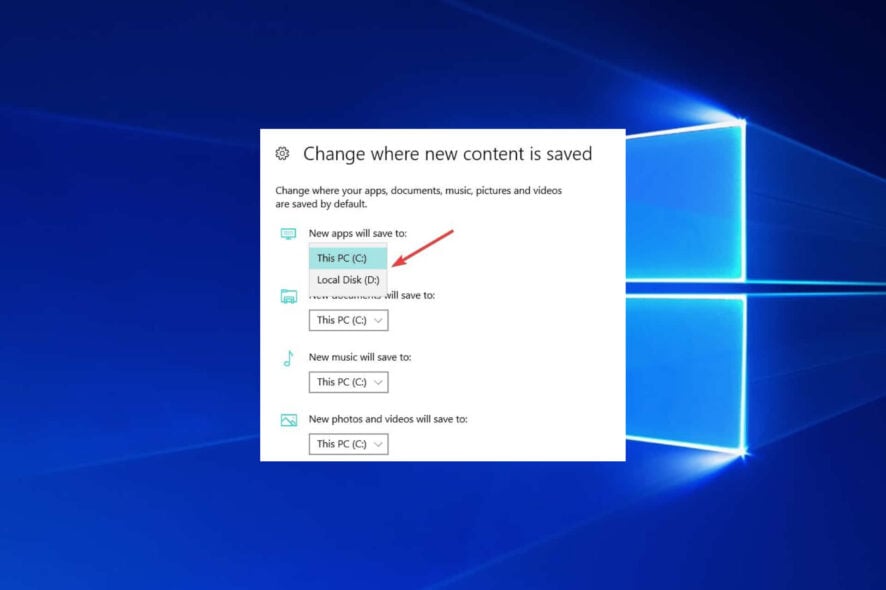

Выбор пространства имён

По умолчанию панель показывает ресурсы по всему кластеру (All namespaces). Используйте выпадающее меню в левом верхнем углу, чтобы ограничить отображение определённым пространством имён — это удобно, чтобы исключить служебные компоненты и сосредоточиться на целях вашей команды. Фильтр сохраняется для всех экранов пока вы его не измените.

Также можно воспользоваться строкой поиска вверху для поиска по именам ресурсов и меткам, что полезно при большом количестве элементов.

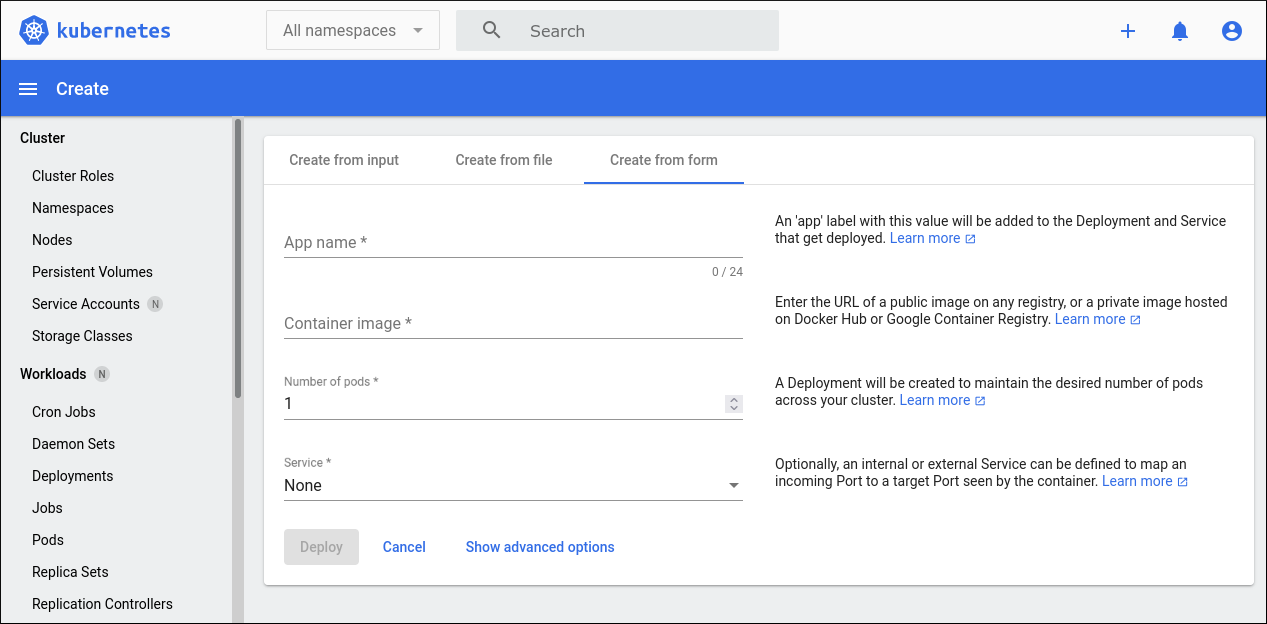

Создание ресурсов

Нажмите кнопку “+” в правом верхнем углу, чтобы создать новый ресурс. Интерфейс позволяет загрузить или вставить манифест Kubernetes, совместимый с kubectl — действие эквивалентно запуску kubectl apply.

Кроме этого есть упрощённая форма для быстрого развёртывания. Выберите вкладку «Create from form», заполните поля и запустите Pod’ы.

Поля формы:

- Название приложения — имя нового деплоймента.

- Образ контейнера — Docker образ, доступный для кластера.

- Количество Pod’ов — число реплик, которое нужно запустить.

- Service — настройка внутреннего или внешнего сервиса. Внутренний сервис будет доступен только в кластере.

Нажатие «Show advanced options» откроет дополнительные поля: метки, переменные окружения, ограничения CPU и памяти, а также опциональный image pull secret — JSON‑файл с креденшалами для приватного реестра.

Кнопка «Deploy» начнёт развёртывание. Позже вы можете вручную редактировать созданные ресурсы.

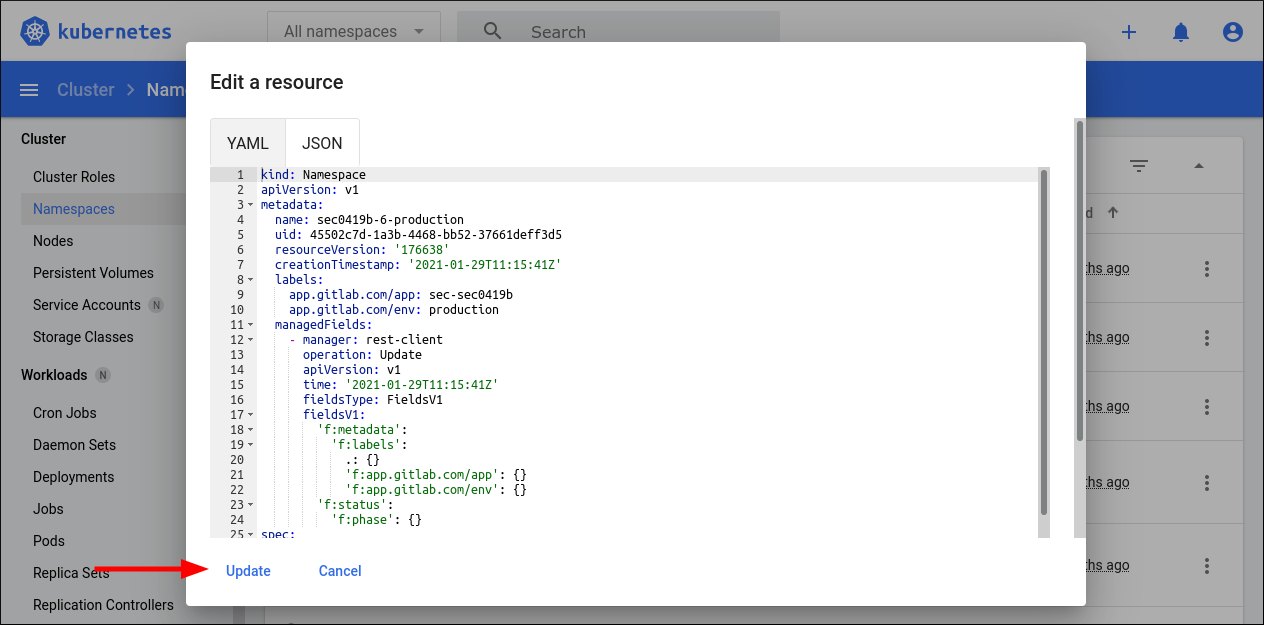

Редактирование происходит через меню три точки справа от строки ресурса. Выберите “Edit” — откроется всплывающее окно с YAML текущего манифеста. После правок нажмите “Update” — это эквивалентно kubectl apply.

Пример минимального Deployment манифеста, который можно вставить в редактор:

apiVersion: apps/v1

kind: Deployment

metadata:

name: example-deployment

labels:

app: example

spec:

replicas: 2

selector:

matchLabels:

app: example

template:

metadata:

labels:

app: example

spec:

containers:

- name: example-container

image: nginx:stable

ports:

- containerPort: 80Ограничения формы создания

Форма подходит для простых случаев и быстрого прототипирования. Она не покрывает всех возможностей Kubernetes (например, сложные init‑контейнеры, множество томов, или CRD). Для продакшена рекомендуется применять готовые манифесты через CI/CD или kubectl.

Мониторинг использования ресурсов узлов

В Dashboard есть экран Nodes с подробной информацией об узлах: ОС, версия kubelet, внутренний IP и метрики использования.

Прокрутите страницу вниз, чтобы увидеть графики CPU и памяти. График Pods показывает потенциальную вместимость узла в зависимости от текущих выделений. Ниже находится таблица Pods, располагавшихся на данном узле.

Полезные приёмы:

- Используйте этот экран для быстрой диагностики узлов с высоким потреблением CPU/памяти.

- Сверяйте версии kubelet и используемые OS‑патчи при расследовании проблем с совместимостью.

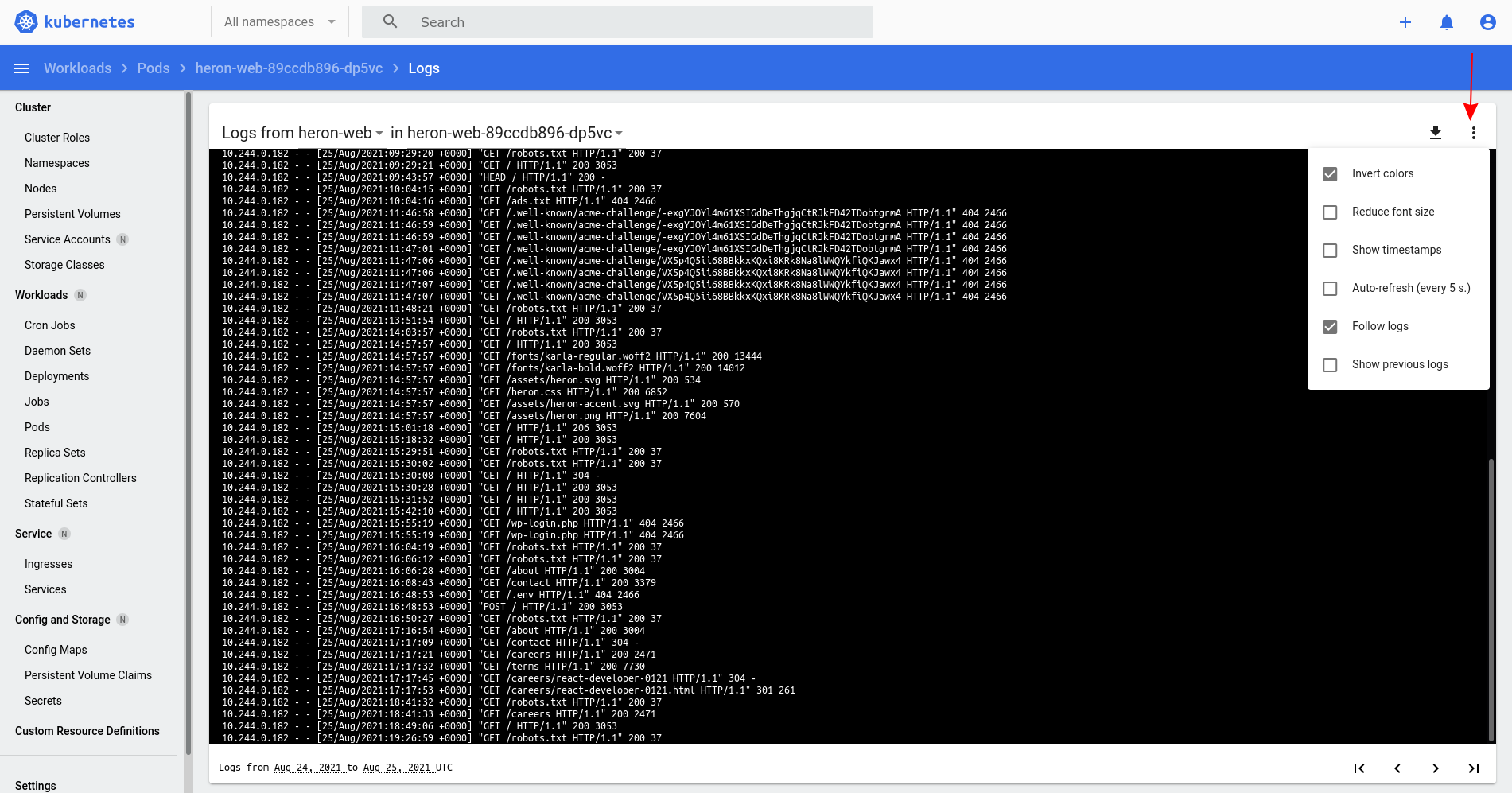

Просмотр логов Pod

Один из частых сценариев — просмотр живых логов Pod’ов и Job’ов. Найдите нужный Pod в таблице, нажмите меню три точки справа и выберите “Logs”.

Вверху окна логов есть меню, с помощью которого можно включить автообновление. Опция “auto-refresh (every 5s)” позволяет стримить логи в реальном времени. Также можно настроить интервал обновления, уменьшить размер шрифта, выбрать цветовую схему и включить показ меток времени — полезно, когда контейнеры не выводят собственные timestamp’ы.

Советы:

- Для длительной отладки используйте агрегаторы логов (ELK, Loki, Stackdriver), а Dashboard — для быстрых проверок.

- Если логи не отображаются, проверьте права RBAC и наличие соответствующих разрешений на чтение Pod’ов и логов.

Настройки панели

Настройки доступны внизу левой боковой панели через ссылку “Settings”. Здесь можно задать интервалы автообновления для логов и таблиц, а также количество элементов на страницу.

Уменьшение интервалов даёт более «живую» картину, но может ухудшить производительность при медленном соединении или при версии Dashboard, плохо оптимизированной для большого числа объектов.

Когда Dashboard не подходит

- Безопасность: если ваш рабочий процесс требует строгого контроля прав и минимизации открытых точек входа, CLI с RBAC и аудитом может быть предпочтительнее.

- Сложные манифесты: форма создания и встроенный редактор не заменят CI/CD, Helm или Kustomize для сложных развёртываний.

- Масштаб: при очень больших кластерах Dashboard может отставать по производительности; для мониторинга в масштабе используйте специализированные инструменты и метрики.

Альтернативные подходы

Если Dashboard не отвечает требованиям, рассмотрите:

- kubectl — полнофункциональный CLI для управления кластером.

- Lens — графический клиент с поддержкой нескольких кластеров и расширенных функций наблюдения.

- Octant — локальный инструмент для визуализации объектов кластера и плагинов.

- Собственные дашборды на основе Grafana и Prometheus для метрик и мониторинга.

Каждый инструмент имеет свои сильные стороны: Dashboard проще и интегрирован в экосистему kube, Lens удобен для работы с несколькими кластерами, а Grafana даёт гибкие визуализации и алертинг.

Практические рекомендации по безопасности

- Ограничьте доступ к Dashboard через RBAC — создавайте отдельные ServiceAccount с минимально необходимыми правами.

- Не включайте публичный доступ без внешней аутентификации и TLS.

- Применяйте NetworkPolicy, чтобы ограничить доступ к сервису Dashboard по сети.

- Регулярно обновляйте версию Dashboard и контролируйте уязвимости.

- Логи доступа к Dashboard и аудиты Kubernetes включайте и храните в централизованном месте.

Модель принятия решений и чеклисты по ролям

Ниже — краткие чеклисты для распространённых ролей в команде.

Чеклист для администратора кластера:

- Установить Dashboard в тестовом кластере и проверить функциональность.

- Настроить RBAC: выделить ServiceAccount для действий, необходимых админам.

- Ограничить доступ через NetworkPolicy и / или Ingress с аутентификацией.

- Настроить аудит и централизованные логи.

Чеклист для разработчика:

- Использовать kubectl proxy для локального доступа.

- Создавать и тестировать простые манифесты через Dashboard для локальной отладки.

- Проверять логи контейнеров через встроенный просмотрщик перед отправкой баг‑репорта.

Чеклист для SRE/DevOps:

- Интегрировать развертывание Dashboard в CI с утверждёнными манифестами.

- Мониторить производительность Dashboard и нагрузку на API‑сервер.

- Обеспечить резервные интерфейсы (Lens, Octant) для диагностики при недоступности Dashboard.

Мини‑методология развёртывания в организации

- Разверните Dashboard в отдельном namespace тестового кластера и прогоните smoke‑тесты.

- Определите набор ServiceAccount’ов и RBAC‑политик для команд.

- Настройте доступ (proxy/ingress) и требования к аутентификации.

- Подготовьте инструкцию для разработчиков с рекомендациями по использованию и списком запрещённых действий.

- Включите аудит и создание тикетов при изменении критичных ресурсов.

Краткая шпаргалка по совместимости и миграции

- Версия манифеста Dashboard должна соответствовать версии Kubernetes или быть протестирована рядом с текущей. При крупных апдейтах kube стоит проверять совместимость API.

- В кластерах с включёнными строгими Admission Controller’ами (например, PodSecurityPolicy, OPA/Gatekeeper) проверяйте, что манифест Dashboard проходит проверки.

Факты и полезные номера

- Локальный прокси kubectl по умолчанию слушает порт 8001.

- Пример NodePort из статьи: 31730 — назначен автоматически при смене типа сервиса на NodePort.

- Dashboard — приложение, работающее внутри кластера, и подчиняющееся тем же правилам RBAC и NetworkPolicy.

Краткий глоссарий

- Namespace — логическое окружение в кластере для разделения ресурсов.

- Pod — минимальная единица развёртывания в Kubernetes, содержащая один или несколько контейнеров.

- NodePort — тип сервиса, позволяющий обращаться к сервису на порту узла.

- kubectl proxy — локальный инструмент для проброса запросов к API‑серверу.

Резюме

Kubernetes Dashboard — полезный инструмент для быстрой визуальной диагностики кластера и выполнения простых операций: просмотр статусов, чтение логов, базовое редактирование манифестов и развёртывание простых приложений. Тем не менее, Dashboard не заменяет CI/CD, Helm, инструменты логирования и мониторинга в масштабе. При включении панели учитывайте риски безопасности, применяйте RBAC и сетевые ограничения, а для публичного доступа используйте TLS и внешнюю аутентификацию.

Короткий список действий на старте:

- Разверните Dashboard в тестовом окружении и проверьте набор функций.

- Настройте RBAC и NetworkPolicy для продакшена.

- Документируйте порядок использования для команд: когда пользоваться Dashboard, а когда CLI или CI.

Дополнительные ресурсы и альтернативы: kubectl, Lens, Octant, Grafana/Prometheus для метрик и централизованных логов.

Важно: панель удобна для визуального контроля и обучения, но в продакшене её включение и публичный доступ требуют продуманного подхода к безопасности и процессам управления.