Глубокое обучение: зачем учиться и как начать

Что такое глубокое обучение

Глубокое обучение — это подход в искусственном интеллекте, основанный на обучении глубоких нейронных сетей. Коротко: нейронная сеть — это модель, состоящая из узлов (нейронов), которые передают и преобразуют сигналы между слоями. «Глубоким» называют такой набор слоёв, где имеется несколько промежуточных уровней обработки — это позволяет модели автоматически строить иерархию признаков: от простого к сложному.

Определение в одной строке: глубокое обучение — набор методов обучения многослойных нейронных сетей для решения задач классификации, регрессии, генерации и др.

Ключевые понятия

- Нейрон: простая вычислительная единица, которая получает входы, суммирует их и пропускает через функцию активации.

- Слой: совокупность нейронов, выполняющая один этап преобразования.

- Глубина: количество слоёв между входом и выходом.

- Параметры: веса и смещения, которые оптимизируются во время обучения.

Как работает глубокое обучение

В основе лежит итеративное обучение: сеть получает данные, делает предсказание, сравнивает его с правильным ответом (функция потерь) и корректирует параметры с помощью градиентного спуска и обратного распространения ошибки.

Пошагово — мини-методология

- Сбор данных: собрать репрезентативный набор с метками или без них.

- Подготовка данных: очистка, нормализация, аугментация (для изображений) и разбиение на обучающую, валидационную и тестовую выборки.

- Выбор архитектуры: CNN для изображений, RNN/Transformer для последовательностей, MLP для табличных данных.

- Инициализация и обучение: выбрать оптимизатор, lr-политику, регуляризацию.

- Оценка: метрики на валидации и тесте, проверка обобщения.

- Деплой: подготовка модели к использованию в продакшн-среде.

Почему глубина важна: в многослойных сетях верхние слои комбинируют признаки нижних слоёв, что даёт возможность выделять абстрактные закономерности без явной ручной инженерии признаков.

Глубокое обучение и машинное обучение

Короткая разница: глубокое обучение — подмножество машинного обучения, где признаки извлекаются автоматически внутри модели. Традиционное машинное обучение чаще полагается на ручную инженерную работу по выделению признаков.

Пример-провокация

Представьте сервис онлайн-платежей, в котором произошёл подозрительный перевод. Классический ML может опираться на заранее заданные признаки: сумма транзакции, прошлые мошеннические метки, контрагенты. Глубокая модель способна учитывать дополнительные многомерные сигналы: последовательности действий пользователя, геопозиции, поведение в интерфейсе, и комбинировать их в нелинейной модели.

Как это работает на практике

- Входной слой принимает сырые или предобработанные признаки.

- Каждый последующий слой комбинирует входные данные и передаёт результат дальше.

- На выходе сеть выдаёт вероятность мошенничества или класс транзакции.

Контрпример когда глубокие сети не подходят

- Мало данных: глубокие сети требуют большого объёма обучающих примеров; при малых выборках более эффективны простые модели.

- Требуется объяснимость: для высоконагруженных регуляторных задач интерпретируемые модели (логистическая регрессия, решающие деревья) могут быть предпочтительнее.

Когда применять глубокое обучение и альтернативы

Подходит, если:

- Есть большой объём высокоразмерных данных (изображения, аудио, текст).

- Задача сложна для ручного выделения признаков.

- Нужна высокая автономность модели в извлечении признаков.

Альтернативы и гибриды

- Классические алгоритмы ML (SVM, случайный лес) при ограниченных данных.

- Инженерия признаков + простая модель для интерпретируемости.

- Transfer learning: использовать предобученные глубокие модели и дообучать их на небольшой выборке.

Зачем изучать глубокое обучение

Причины для обучения:

- Широкий спектр применений: компьютерное зрение, обработка естественного языка, звуковой анализ, генерация контента, медицинская диагностика.

- Больше возможностей на рынке труда, особенно для специалистов с практическим портфолио.

- Возможность создавать собственные проекты и прототипы, применимые в стартапах и R&D.

Что даёт курс по глубокому обучению

- Практические навыки работы с фреймворками: TensorFlow, Keras, PyTorch.

- Понимание архитектур: CNN, RNN, Transformer, Autoencoder.

- Навыки развёртывания моделей и мониторинга в продакшне.

Важно: сертификат сам по себе не гарантирует работу; ценят реальные проекты и умение объяснить решения.

Требования и подготовка

Рекомендованные навыки перед курсом

- Уверенный Python и работа с библиотеками numpy/pandas.

- Знание основ машинного обучения: регрессия, классификация, переобучение, кросс‑валидация.

- Базовые представления о линейной алгебре, статистике и вероятностях.

Технические требования

- Рекомендуемая конфигурация для локальной работы: многоядерный процессор (4+ ядер), 16–32 ГБ оперативной памяти; при работе с большими моделями — GPU с минимум 4–8 ГБ видеопамяти. Эти требования рекомендованы для комфортного обучения и отладки, но не являются строгой необходимостью.

Советы по подготовке

- Пройдите курс по Python и по введению в машинное обучение.

- Соберите мини-портфолио из 2–3 проектов: классификация изображений, анализ тональности текста, простая система рекомендаций.

Практическое руководство: шаг за шагом

- Выбор задачи: формализуйте бизнес-потребность и метрику успеха.

- Сбор и оценка данных: качество важнее объёма на начальном этапе.

- Прототип на небольшом наборе данных: простая модель для базовой оценки гипотезы.

- Миграция к глубокой архитектуре при необходимости: начать с предобученной модели.

- Валидация и стресс-тесты: проверить на разных подвыборках и edge-case сценариях.

- Деплой и мониторинг: настроить A/B-тест, слежение за деградацией качества.

Критерии приёмки

- Модель показывает улучшение ключевой метрики по сравнению с базовой линией.

- Производительность (латентность и пропускная способность) удовлетворяет требованиям продакшна.

- Модель проходит тесты на устойчивость к шуму и изменению распределения данных.

Типичные ошибки и как их избежать

- Переобучение: применять регуляризацию, dropout, раннюю остановку и кросс‑валидацию.

- Непроверяемые метрики: заранее продумать бизнес-метрики и мониторинг.

- Игнорирование смещения в данных: проверять распределение по времени, географии и другим факторам.

Модель зрелости проектов глубокого обучения

- Экспериментальная стадия: прототип и проверка идеи.

- Пилот: модель работает на ограниченном наборе пользователей, собираются метрики.

- Продакшн: масштабирование, мониторинг, CI/CD для моделей.

- Автоматизация: MLOps, автоматический мониторинг дрейфа и перетренировки.

Роль‑ориентированные чеклисты

Чеклист для студента

- Разобрался с Python и базовыми библиотеками.

- Сделал 2 небольших проекта с открытыми датасетами.

- Понимает, когда применять DL и когда нет.

Чеклист для инженера

- Настроил среду разработки с GPU.

- Реализовал пайплайн обучения и валидации.

- Настроил сбор метрик и логирование.

Чеклист для менеджера проекта

- Определил KPI и метрики успеха.

- Обеспечил доступ к данным и ресурсам.

- Планирует A/B тесты и стратегию развёртывания.

План курса и дорожная карта

Месяц 1: основы Python и математики. Месяц 2: основы ML и простые нейронные сети. Месяц 3: CNN для изображений. Месяц 4: NLP и трансформеры. Месяц 5: проект, деплой и мониторинг. Этот план — ориентир; длительность может варьироваться.

Безопасность и приватность данных

- Минимизируйте хранение персональных данных в обучающих датасетах.

- Псевдонимизируйте и агрегируйте чувствительную информацию.

- При работе с пользовательскими данными соблюдайте применимые нормы защиты персональных данных и требования GDPR при работе с европейскими пользователями.

Когда глубокие модели не решат задачу

- Если задача требует объяснимости в виде простых правил.

- Если объём данных недостаточен и нельзя использовать transfer learning.

- Если инфраструктура не позволяет обеспечить надёжный inference в продуктиве.

Decision flowchart для выбора между классическим ML и глубоким обучением

flowchart TD

A[Начать: есть задача] --> B{Данные: достаточно

объёма и разнообразия?}

B -- Да --> C{Тип данных: изображения,

текст, аудио или сложные сырые признаки?}

B -- Нет --> D[Использовать классические ML

или сбор дополнительных данных]

C -- Да --> E[Рассмотреть глубокое обучение]

C -- Нет --> F[Классические ML c инженерией признаков]

E --> G[Попробовать transfer learning]

G --> H[Прототип и валидация]

H --> I[Деплой и мониторинг]Пример плейбука для курсового проекта

- Форма задания: чётко опишите задачу и метрики.

- Сроки: этапы — прототип (2 недели), улучшения (2–4 недели), подготовка к деплою (1–2 недели).

- Критерии приёмки: метрики на тестовой выборке, наличие репозитория с инструкциями по запуску.

- Контроль качества: code review, автоматические тесты на предсказания в критичных кейсах.

Кейс: защита от мошенничества в платёжной системе

Архитектура решения:

- Инжиниринг данных: агрегация транзакций по пользовательским сессиям.

- Модель: гибридная система — градиентный бустинг для табличных сводных признаков + нейронная сеть для последовательностей действий.

- Деплой: модель работает в режиме асинхронной оценки, критичные для задержки решения отправляются в отдельный быстрый маршрут.

Почему гибрид: табличные признаки дают быстрый грубый отбор, глубокая модель уточняет сложные паттерны.

Тесты и критерии приёмки

- Покрытие тестов: функциональные тесты пайплайна и интеграционные тесты модели.

- Метрики: ROC-AUC, precision/recall в зависимости от бизнес-целей.

- Устойчивость: проверка на дрейф распределения и ухудшение метрик со временем.

Частые вопросы

Что учить в первую очередь?

Изучите Python, основы статистики и основы машинного обучения. Затем переходите к фреймворкам: TensorFlow или PyTorch.

Нужен ли GPU для начала?

Для базового обучения небольших моделей GPU не обязателен, но ускоряет экспериментирование и позволяет работать с большими сетями.

Сколько времени займёт путь от новичка до уровня готового инженера?

Зависит от интенсивности обучения и практики. При плотном графике с проектами — несколько месяцев; для глубокого проживания темы и опыта в продакшне — год и более.

Резюме

- Глубокое обучение мощно при больших данных и сложных признаках.

- Перед обучением важно понять бизнес-метрики и критерии приёмки.

- Комбинируйте классические методы и глубокие модели для лучшего результата.

Важно

Глубокое обучение — это инструмент, а не панацея. Правильный выбор подхода и прозрачный процесс разработки обеспечат практическую пользу и устойчивость решений.

FAQ

Q: Можно ли перейти в глубокое обучение из чисто прикладной области без математического образования?

A: Да. Базовые знания математики и стремление к практике достаточно для начала. Продвигаться дальше придётся углублять теоретические знания по мере решения сложных задач.

Q: Какие компании нанимают специалистов по глубокому обучению?

A: Компании в сферах технологических сервисов, финансов, здравоохранения и e‑commerce активно используют глубокое обучение. В объявлении о вакансии ценят проекты и практические умения.

Q: Какие инструменты стоит знать в 1‑ю очередь?

A: Python, numpy, pandas, scikit‑learn, PyTorch или TensorFlow/Keras, а также инструменты для работы с данными и деплоя (Docker, REST API, MLflow).

Похожие материалы

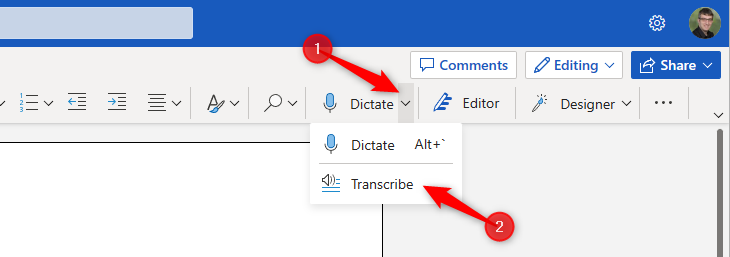

Транскрибирование в Word Online — инструкция

Восстановление и удаление программ в Windows

Как подогнать лист Excel под экран и печать

Сделать файл финальным в Google Drive

Как копировать правки в iPhone — пакетное редактирование