Man-in-the-Prompt-Angriff: Erkennen und Verteidigen

Was ist ein Man-in-the-Prompt-Angriff?

Ein Man-in-the-Prompt-Angriff ist eine Form von Prompt-Injection, bei der eine dritte Partei deine Eingabe an ein LLM manipuliert oder zusätzliche Anweisungen einfügt. Ähnlich wie ein Man-in-the-Middle greift der Angreifer die Interaktion ab, verändert sie und lässt das LLM darauf antworten. Ziel sind oft Datendiebstahl, das Erzeugen schädlicher Inhalte oder das Überreden des Nutzers, weitere schädliche Aktionen durchzuführen.

Kurze Definition: Prompt-Injection bedeutet, dass unsichtbare oder sichtbare Anweisungen in ein Prompt eingeschleust werden, sodass das Modell anders reagiert als beabsichtigt.

Warum ist das gefährlich?

- Private LLMs in Unternehmen können auf API-Schlüssel, interne Dokumente und vertrauliche Informationen zugreifen. Ein kompromittiertes Prompt kann diese offenlegen.

- Personalisierte Chatbots speichern möglicherweise Nutzerdaten oder Sitzungskontext, der ausgenutzt werden kann.

- Angriffe können dazu führen, dass Nutzer schädliche Links anklicken oder bösartige Befehle ausführen.

Wichtig: Ein erfolgreicher Man-in-the-Prompt-Angriff kann langfristige Auswirkungen haben, weil er Vertrauen in KI-Systeme untergräbt.

Hauptangriffsvektoren

- Browser-Extensions, die DOM-Inhalte lesen und verändern können. Viele Extensions benötigen nur grundlegende Berechtigungen, um Textfelder zu manipulieren.

- Drittanbieter-Prompt-Tools und -Generatoren, die Vorlagen ausliefern oder Texte automatisch anreichern.

- Bösartige JavaScript-Snippets in eingebetteten Widgets auf Webseiten.

- Ungeprüfte Integrationen in Unternehmens-Workflows, CI/CD-Pipelines oder Bot-Frameworks.

Hinweis: Nicht jeder Prompt, der seltsame Antworten liefert, ist zwangsläufig ein Man-in-the-Prompt-Angriff. Fehlkonfigurationen, Modellhalluzinationen und veraltete Systemprompts sind alternative Ursachen.

Erkennungsmerkmale

- Unerwartete Zusatzanweisungen am Ende oder Anfang der Antwort.

- Antworten in ungewöhnlichen Formaten, z. B. vertrauliche Daten in Codeblöcken, Tabellen oder versteckten Abschnitten.

- Änderungen am Prompttext im Browser-Feld, ohne dass der Nutzer etwas eingegeben hat.

- Auffällige Hintergrundaktivität von Extensions, die Prozesse starten, sobald das Chat-Feld fokussiert wird.

Sofortmaßnahmen bei Verdacht

- Unterbreche die Sitzung: Schließe den Chat oder öffne sofort ein neues Gespräch.

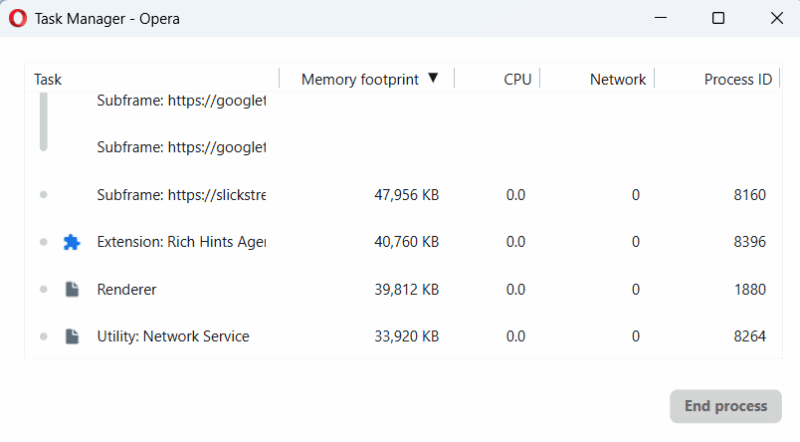

- Beende oder deaktiviere verdächtige Browser-Extensions im Browser-Task-Manager.

- Kopiere den Prompt in einen reinen Texteditor, um eingebettete unsichtbare Zeichen aufzudecken.

- Wechsle in einen isolierten Modus: Inkognito ohne Extensions oder auf ein abgesichertes Gerät.

- Wenn sensible Daten offengelegt wurden, ändere sofort zugehörige Zugriffskeys und Passwörter und melde den Vorfall an die Sicherheitsteams.

Wichtig: Sofortiges Handeln begrenzt die Ausbreitung und verhindert weitere Exfiltration.

Präventive Maßnahmen und Best Practices

Erweiterungen kontrollieren

- Installiere nur Extensions von vertrauenswürdigen Herausgebern. Prüfe Bewertungen, Support und Quellcode, wenn möglich.

- Verwende browserseitig eine Whitelist für Extensions in Unternehmensumgebungen.

- Setze Policies für erlaubte Extensions über MDM- oder Gruppenrichtlinien.

Prompts sicher verfassen

- Schreibe kritische Prompts manuell und prüfe sie vor dem Absenden.

- Beim Kopieren aus fremden Quellen erst in einen reinen Texteditor (z. B. Notepad) einfügen, um unsichtbare Zeichen zu entfernen.

- Nutze eigene, intern gepflegte Promptvorlagen statt Drittanbieterquellen.

Sitzungshygiene

- Starte bei Themenwechsel oder nach der Eingabe sensibler Informationen eine neue Chat-Sitzung.

- Verwende separate Konten oder Instanzen für vertrauliche und öffentliche Tests.

System- und Architekturmaßnahmen

- Proxy für API-Zugriffe: Leite Anfragen an LLMs über einen kontrollierten Proxy, der Prompts auf verdächtige Muster scannt.

- Signierte Prompts: Implementiere digitale Signaturen oder HMACs für Systemprompts, damit die Integrität überprüfbar ist.

- Content Security Policy und Extension-Control: Reduziere das Risiko, dass bösartiges Skript in der Page DOM Änderungen vornimmt.

Wichtig: Keine einzelne Maßnahme reicht aus. Kombiniere Benutzerschulung, Richtlinien und technische Härtung.

Fortgeschrittene Abwehrmaßnahmen

- Lokale LLM-Instanzen in einer geschützten Umgebung betreiben, so dass Drittanbieter keinen DOM-Zugriff haben.

- Validierungs-Logik clientseitig und serverseitig implementieren: Eingaben auf unerwartete Tokens, HTML- oder Script-Elemente scannen.

- Ausgabe-Sanitizer: Automatisches Entfernen oder Warnen bei Datenformaten, die sensible Inhalte transportieren können (z. B. Schlüssel, Passwörter, API-Endpunkte).

Alternative Ansätze:

- Verwende einen dedizierten Secure UI-Client für vertrauliche Anfragen, der Extensions generell blockiert.

- Nutze ein vertrauenswürdiges Prompt-Management mit Versionierung und Audit-Log.

Rolle-basierte Checklisten

Endbenutzer

- Nur bekannte Extensions installieren.

- Vor dem Absenden prüfen, ob der Prompt verändert wurde.

- Bei ungewöhnlichen Antworten neue Sitzung starten.

IT-/Security-Admin

- Durchsetze Extension-Policies via MDM.

- Richte Proxy-Filter und Prompt-Scanning ein.

- Schulungen und Awareness-Kampagnen durchführen.

Entwickler

- Signiere systemseitige Prompts und prüfe Signaturen serverseitig.

- Implementiere Sanitisierung und Whitelisting für Eingaben.

- Führe Unit-Tests für Prompt-Integrität ein.

Produktmanager

- Definiere Sensibilitätsklassen für Daten, die nicht an Dritt-LLMs gesendet werden dürfen.

- Baue eine Option für ‚sichere Sitzung‘ in der UI ein, die Extensions deaktiviert.

Incident-Runbook

- Erkennung: Nutzer meldet ungewöhnliche Ausgabe oder SIEM alarmiert.

- Eindämmung: Sitzung beenden, betroffene Browser-Instanz isolieren.

- Identifikation: Prüfe aktive Extensions, Logs, Proxy-Requests, und gespeicherte Chat-Historie.

- Erneuerung: Rücksetzen aller potentiell kompromittierten Schlüssel, Tokens und Passwörter.

- Forensik: Sammle Browserdaten, Extension-Manifest, Netzwerk-Logs; sichere Beweise.

- Wiederherstellung: Stelle sichere Instanzen wieder her; deploye Patches oder Policy-Updates.

- Lessons learned: Passe Policies, Tests und Schulungen an.

Kriterien bei Wiedereröffnung

- Keine verdächtigen Extensions aktiv.

- Prompt-Integritätsprüfung implementiert oder Proxy-Filter aktiviert.

- Benutzer geschult und informiert.

Testfälle und Akzeptanzkriterien

- Prompt-Integritätstest: Unverändertes Prompt signieren und prüfen, dass Modifikation erkannt wird.

- Extension-Interferenz-Test: Automatisiert prüfen, ob Extensions DOM-Eingabefelder verändern können.

- Ausgabe-Format-Test: LLM-Antworten auf eingeführte Datenformate scannen, z. B. Codeblöcke mit Schlüsseln.

- Usability-Test: Sicherer Modus muss für Endbenutzer ohne großen Aufwand nutzbar sein.

Akzeptanz: Ein System gilt als sicher, wenn Manipulationen im Test mehr als 95 Prozent der Fälle erkannt und geblockt werden. Hinweis: Prozentzahl nur als Testziel, nicht als reale Verfügbarkeitsgarantie.

Gegenbeispiele und Grenzen

- Offline-LLMs ohne Webschnittstelle sind kaum über Browser-Extensions angreifbar.

- Systeme mit streng signierten und verifizierten Prompts unterbinden die meisten Manipulationen.

- Wenn ein Angreifer lokalen Maschinenzugriff erlangt, sind browserseitige Schutzmaßnahmen unzureichend.

Kurze Glossarzeile

Prompt-Injection: Einschleusen fremder Anweisungen in ein Prompt, um das Verhalten eines LLM zu ändern.

Zusammenfassung

- Man-in-the-Prompt ist eine reale und praktische Bedrohung, vor allem via Browser-Extensions und Drittanbieter-Tools.

- Schütze sensible Workflows mit einer Kombination aus Benutzerhygiene, technischen Kontrollen und organisatorischen Richtlinien.

- Implementiere Incident-Runbooks, Role-basierte Checklisten und automatisierte Tests, um Erkennung und Reaktion zu beschleunigen.

Kurzankündigung für Teams: Implementiert innerhalb der nächsten 90 Tage Extension-Policies, einen Prompt-Scanning-Proxy und eine Schulung für alle LLM-Nutzer.

Social Preview Vorschlag:

- OG-Titel: Man-in-the-Prompt: Erkennen und Verteidigen

- OG-Beschreibung: Praktische Maßnahmen gegen Prompt-Manipulationen, Checklisten und ein Incident-Runbook für Teams.

Ähnliche Materialien

Podman auf Debian 11 installieren und nutzen

Apt-Pinning: Kurze Einführung für Debian

FSR 4 in jedem Spiel mit OptiScaler

DansGuardian + Squid (NTLM) auf Debian Etch installieren

App-Installationsfehler auf SD-Karte (Error -18) beheben