Wie soziale Medien die Wahrnehmung von Wahrheit verändern

Wichtig: Geschwindigkeit in sozialen Netzen ist kein Qualitätsmerkmal. Prüfen Sie Quellen, bevor Sie etwas teilen.

Warum sich die „Wahrheit“ verändert

Die Verbreitung von Informationen über soziale Netzwerke hat enorme Geschwindigkeit und Reichweite. Memes, Meinungen und Nachrichten erreichen in Minuten tausende bis Millionen Nutzer. Das allein ist nicht das Problem: problematisch wird es, wenn Inhalte unvollständig, verzerrt oder falsch sind und trotzdem viral gehen.

Diese Dynamik verändert nicht unbedingt die objektive Wahrheit von Fakten, aber sie verändert, was Menschen als Wahrheit akzeptieren. Wahrnehmung, Vertrauen und Handlungen basieren zunehmend auf dem, was im Netzwerk sichtbar und beliebt ist, nicht nur auf überprüfbaren Informationen.

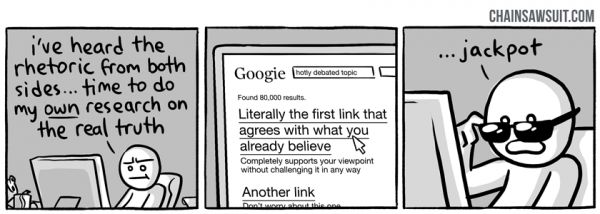

Bestätigungsvoreingenommenheit

Bestätigungsvoreingenommenheit bedeutet: Menschen bevorzugen Informationen, die ihre bestehenden Überzeugungen bestätigen. Auf Social-Media-Plattformen zeigt sich das so, dass Nutzer eher Inhalte liken, kommentieren und teilen, die in ihr ideologisches oder emotionales Raster passen. Algorithmen, die Engagement belohnen, verstärken diesen Effekt, weil sie Nutzern ähnliche Inhalte immer wieder anzeigen.

Beispiele:

- Harmlos: Jemand teilt eine absurde Filmkritik, weil sie die eigene Ansicht zu einem Film bestätigt.

- Gefährlich: Jemand teilt unbelegte Verleumdungen über eine politische Person, weil sie der eigenen Sichtweise entsprechen.

Wenn sich Bestätigungsvoreingenommenheit mit schneller Verbreitung verbindet, kann sich eine halbe Wahrheit binnen Minuten als vermeintliche Gewissheit etablieren.

Der Mitläufereffekt

Der Mitläufereffekt beschreibt das Verhalten, das entsteht, wenn viele Menschen etwas glauben oder tun, und andere deshalb folgen. In sozialen Netzwerken ist Sichtbarkeit und Anzahl der Interaktionen oft das einzige Signal für Glaubwürdigkeit: viele Likes = glaubwürdig. Diese Heuristik ist praktisch, aber auch leicht manipulierbar.

Kombiniert entstehen drei Treiber, die Wahrnehmung formen:

- Algorithmische Verstärkung: Inhalte mit hohem Engagement werden bevorzugt angezeigt.

- Psychologie: Bestätigungsfehler steigern die Wahrscheinlichkeit, dass Inhalte geteilt werden.

- Soziale Bestätigung: Viele Reaktionen erzeugen Vertrauen, unabhängig von Fakten.

Wann dieses System versagt

- Wenn virale Inhalte aus nicht überprüften Quellen stammen.

- Wenn manipulierte Medien (Deepfakes, aus dem Kontext gerissene Zitate) verwendet werden.

- Wenn koordinierte Desinformationskampagnen existieren, die gezielt Vertrauen oder Misstrauen schaffen.

Hinweis: Nicht jede virale Nachricht ist falsch — aber virale Verbreitung allein ist kein Beleg für Wahrheit.

Werkzeuge und Best Practices für informierte Nutzer

Basisregeln:

- Prüfen Sie die Quelle: Wer berichtet? Gibt es Primärquellen?

- Cross-Check: Suchen Sie nach mehreren glaubwürdigen Quellen.

- Hinterfragen Sie Emotionen: Erregende Inhalte sind besonders manipulierbar.

- Vorsicht bei Screenshots: Oft fehlen Metadaten.

Nützliche Dienste für Fakt-Checks:

- Politifact — US-Schwerpunkt, erklärt politische Behauptungen mit Quellendokumentation.

- Snopes — untersucht urbane Mythen, Memes und virale Behauptungen.

Beide Seiten geben oft die verwendeten Quellen an; prüfen Sie diese Originalquellen selbst, wenn Sie Zweifel haben.

Schritt-für-Schritt-SOP zur schnellen Faktenprüfung (für Nutzer und Redaktionen)

- Quelle identifizieren: Autor, Organisation, Datum. Fehlende Angaben sind ein Warnsignal.

- Primärquelle suchen: Gibt es ein Originaldokument, ein Video in voller Länge oder eine offizielle Stellungnahme? Wenn ja, lesen/sehen Sie diese.

- Bild-/Video-Check: Reverse-Image-Search (z. B. TinEye, Google Bilder) nutzen, um Ursprung und frühere Verwendungen zu ermitteln.

- Cross-Check: Mindestens zwei unabhängige, glaubwürdige Quellen suchen.

- Kontext prüfen: Wurde ein Zitat oder ein Ausschnitt aus dem Zusammenhang gerissen?

- Metadaten prüfen: Datum, Zeitpunkt, Ort stimmen mit der Behauptung überein?

- Entscheiden und kennzeichnen: Wenn unsicher, transparent „unbestätigt“ markieren. Bei Fehlern Korrektur veröffentlichen.

Mini-Methodik: 5W-Check

- Wer? (Quelle)

- Was? (Inhalt)

- Wann? (Zeitpunkt)

- Wo? (Ort/Medium)

- Warum? (Motivation/Intention)

Entscheidungshilfe: kurzer Entscheidungsbaum

flowchart TD

A[Neue virale Behauptung] --> B{Ist die Quelle bekannt und glaubwürdig?}

B -- Ja --> C{Gibt es Primärquellen?}

B -- Nein --> G[Markieren: Unbestätigt + Prüfen]

C -- Ja --> D{Bestätigen mehrere unabhängige Quellen?}

C -- Nein --> G

D -- Ja --> E[Teilen mit Quellenangabe]

D -- Nein --> F[Nicht teilen; weitere Recherche]Rollenspezifische Checklisten

Für Leser:

- Nicht sofort teilen.

- Prüfen, ob die Nachricht Emotionen auslöst.

- Führen Sie eine schnelle Reverse-Image-Search aus.

- Teilen Sie nur mit Quellenangabe.

Für Journalisten/Redaktionen:

- Primärquellen anfordern.

- Interne Review bei brisanten Behauptungen.

- Transparenz über Unsicherheiten.

- Schnelle Korrekturen bei Fehlern veröffentlichen.

Für Plattform-Moderatorinnen und -Moderatoren:

- Muster für koordinierte Desinfo erkennen.

- Interaktionsanomalien melden.

- Labels für unbestätigte Inhalte einsetzen.

Datenschutz und rechtliche Hinweise (GDPR-relevant)

Wenn Sie Informationen über Personen verbreiten, beachten Sie Datenschutzrisiken:

- Persönliche Daten nicht weiterverbreiten, wenn sie nicht relevant und öffentlich sind.

- Bei sensiblen Informationen ist eine Einwilligung erforderlich oder eine rechtliche Grundlage.

- Plattformbetreiber sollten transparent machen, welche Daten sie verarbeiten und wie Inhalte priorisiert werden.

Wichtig: Datenschutz schützt nicht nur die Privatsphäre, sondern verhindert auch, dass falsche Informationen Einzelpersonen dauerhaft schaden.

Gegenvorschläge und alternative Ansätze

- Medienkompetenz in Schulen stärken: Kritisches Denken systematisch lehren.

- Algorithmische Transparenz: Plattformen sollten erklären, warum Inhalte empfohlen werden.

- Crowdsourced-Faktenprüfung: Communities moderiert von Experten können irreführende Inhalte schneller entlarven.

- Designänderungen: Sichtbarkeit von Quellen und Kontext direkt in der Timeline erhöhen.

Risikobetrachtung und Gegenmaßnahmen

Risiken:

- Schnell verbreitete Falschinfos schädigen öffentliche Debatten.

- Vertrauensverlust in Medieninstitutionen.

- Polarisierung der Gesellschaft.

Gegenmaßnahmen:

- Proaktive Faktenchecks.

- Korrekturmechanismen und eindeutige Kennzeichnungen.

- Förderung von Medienkompetenz und Transparenz bei Plattformen.

Akzeptanzkriterien für eine glaubwürdige Meldung

- Primärquelle vorhanden und zugänglich.

- Mehrere unabhängige Bestätigungen.

- Kontext vollständig dokumentiert.

- Keine widersprüchlichen Metadaten.

Beispiele, wann die Methode nicht reicht

- Deepfakes, die visuelle Beweise simulieren, erfordern forensische Tools.

- Koordinierte Desinformationskampagnen, die echte Konten nutzen, brauchen Analyse auf Netzwerkebene.

Kurzer Praxis-Cheat-Sheet

- Zwei-Minuten-Check: Quelle → Bild-Check → Datum → Zwei unabhängige Quellen.

- Beim Zweifel: nicht teilen und mit „unbestätigt“ kennzeichnen.

Zusammenfassung

- Soziale Medien verändern nicht die objektive Wahrheit, aber sie verändern, was Menschen als wahr annehmen.

- Psychologische Effekte (Bestätigungsvoreingenommenheit, Mitläufereffekt) plus algorithmische Verstärkung fördern die Verbreitung von Unwahrheiten.

- Durch einfache Routinen, Tools und Transparenz lassen sich die Risiken deutlich reduzieren.

Hinweis: Die beste Verteidigung gegen Fehlinformation ist eine Kombination aus persönlicher Skepsis, methodischer Faktenprüfung und systemischer Verbesserung von Plattformen und Bildung.

- Wichtige Ressourcen: Politifact, Snopes, Reverse-Image-Search.

Schluss: Geschwindigkeit ist nützlich – aber Wahrheit braucht Sorgfalt.

Ähnliche Materialien

Podman auf Debian 11 installieren und nutzen

Apt-Pinning: Kurze Einführung für Debian

FSR 4 in jedem Spiel mit OptiScaler

DansGuardian + Squid (NTLM) auf Debian Etch installieren

App-Installationsfehler auf SD-Karte (Error -18) beheben