Régressions en Python : guide pratique pour analyser des relations

Sommaire rapide

- Qu’est-ce que la régression et pourquoi l’utiliser

- Régression linéaire simple : détecter une tendance entre deux variables

- Régression linéaire multiple : ajouter des prédicteurs

- Régression non linéaire : adapter des courbes (polynômes)

- Régression logistique : prédire des catégories binaires

- Méthodologie, critères et tests pour valider vos modèles

- Checklist par rôle et playbook d’exécution

Introduction — pourquoi la régression

La régression est une famille de techniques statistiques destinée à modéliser la relation entre une variable dépendante et une ou plusieurs variables indépendantes. En pratique, on l’utilise pour :

- quantifier un effet (par exemple, l’impact du montant d’une addition sur le pourboire),

- prédire une valeur future à partir de variables observées,

- tester des hypothèses (est-ce que tel facteur influence le résultat ?).

Définition rapide : une régression estime une fonction f telle que y ≈ f(x). Pour la régression linéaire simple, f est une droite ; pour la régression logistique, f est une sigmoïde qui donne une probabilité.

Important : la qualité d’un modèle dépend autant des données et du prétraitement que de l’algorithme choisi.

Outils utilisés

- Seaborn : visualisation statistique en Python.

- Pandas : structure tabulaire DataFrame.

- NumPy : calcul numérique.

- Pingouin : petite bibliothèque statistique utile pour les tests et la régression.

- Jupyter Notebook / JupyterLab ou équivalent pour l’exploration interactive.

Note : je recommande d’isoler l’environnement avec conda/mamba pour reproduire les versions de paquets.

1. Régression linéaire simple : trouver une tendance

But : vérifier s’il existe une relation linéaire entre deux variables continues.

Exemple de jeu de données : pourboires dans des restaurants de New York. On cherche à savoir si « total_bill » prédit « tip ».

Code d’exploration et visualisation :

import seaborn as snsCharger le jeu de données intégré :

tips = sns.load_dataset('tips')Si vous êtes dans un notebook Jupyter :

%matplotlib inlineTracer un nuage de points :

sns.relplot(x='total_bill',y='tip',data=tips)

Le nuage semble suivre une tendance positive. Pour visualiser la droite de régression :

sns.regplot(x='total_bill',y='tip',data=tips)

Pour obtenir des coefficients et des mesures formelles, Pingouin offre une fonction simple :

import pingouin as pg

pg.linear_regression(tips['total_bill'],tips['tip']).round(2)

Interprétation : le R² (r2) informe sur la proportion de variance expliquée. Ici r2 ≈ 0,46 ; racine carrée ≈ 0,68 indique une corrélation positive modérée à forte selon le contexte. Le modèle simple trouvé peut être écrit comme :

tip = 0.92 + 0.11 * total_billFonction de prédiction en Python (indentation de 4 espaces requise) :

def tip(total_bill):

return 0.92 + 0.11 * total_billTest sur une addition de 100 unités monétaires (exprimées ici en dollars dans le jeu d’exemple) :

print(tip(100)) # ≈ 12Note : localisez la devise selon votre contexte si nécessaire.

2. Régression linéaire multiple : plusieurs prédicteurs

But : expliquer ou prédire une variable cible à partir de plusieurs variables indépendantes.

Exemple : ajouter la taille de la table (nombre de convives) comme second prédicteur du pourboire.

pg.linear_regression(tips[['total_bill','size']],tips['tip']).round(2)Remarquez les doubles crochets pour sélectionner plusieurs colonnes. Le R² identique à l’exemple simple signale que le modèle reste explicatif et que les deux variables contribuent.

On peut écrire la fonction prédictive multiple comme :

def tip(total_bill, size):

return 0.67 + 0.09 * total_bill + 0.19 * sizeConseil : vérifiez la colinéarité entre prédicteurs (variance inflation factor, VIF) avant de conserver toutes les variables.

3. Régression non linéaire : ajuster des courbes (polynômes)

But : modéliser des relations qui ne sont pas approximables par une droite.

Exemple pédagogique : construire un polynôme quadratique y = 4x^2 + 2x + 3.

Génération des données :

import numpy as np

x = np.linspace(-100,100,1000)

y = 4*x**2 + 2*x + 3Construire un DataFrame :

import pandas as pd

df = pd.DataFrame({'x': x, 'y': y})Visualisation :

sns.relplot(x='x', y='y', data=df)

Ajustement polynomial avec Seaborn (ordre = degré) :

sns.regplot(x='x', y='y', order=2, data=df)

Technique alternative : ajouter manuellement une colonne x^2 et utiliser une régression linéaire multiple sur [x, x2] :

df['x2'] = df['x']**2

pg.linear_regression(df[['x','x2']], df['y']).round(2)

Ici, comme les données ont été construites artificiellement, R² = 1. Dans le monde réel, attendez-vous à un R² moindre.

Fonction prédictive quadratique :

def quad(x):

return 3 + 2*x + 4*x2On peut généraliser à des polynômes d’ordre supérieur, mais attention au surapprentissage (overfitting).

4. Régression logistique : prédire une catégorie binaire

But : estimer la probabilité d’appartenance à une classe binaire (0/1) en fonction d’une ou plusieurs variables.

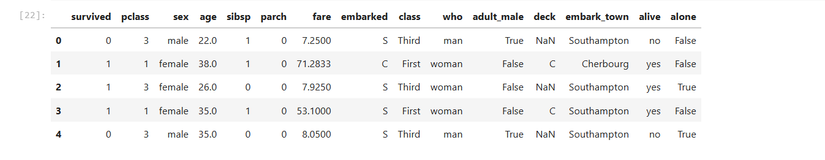

Exemple : jeu de données Titanic pour tester si le tarif du billet prédit la survie.

titanic = sns.load_dataset('titanic')Exploration rapide :

titanic.head()

Tracer une courbe logistique avec Seaborn :

sns.lmplot(x='fare', y='survived', logistic=True, data=titanic)

Test formel avec Pingouin :

pg.logistic_regression(titanic['fare'], titanic['survived']).round(2)

Interprétation rapide : regardez la p-valeur pour juger de la significativité d’un facteur. Ici la p-valeur est essentiellement nulle, ce qui indique que le tarif est un prédicteur statistiquement significatif de la survie dans ce jeu de données.

Important : la significativité statistique ne garantit pas la pertinence pratique. Vérifiez les effets et leur sens.

Méthodologie pratique : pipeline répété

- Définir la question métier ou l’hypothèse.

- Rassembler et inspecter les données (types, valeurs manquantes, outliers).

- Nettoyer et transformer (normalisation, encodage, création de variables d’interaction).

- Explorer visuellement (nuages, densités, boxplots).

- Sélectionner un modèle de base (linéaire, polynôme, logistique).

- Entraîner et valider (cross-validation si possible).

- Évaluer : métriques adaptées (R², RMSE pour régression ; AUC, précision, rappel pour classification).

- Interpréter les coefficients et tester les hypothèses (p-valeurs, intervalles de confiance).

- Déployer en production avec tests automatisés et surveillance.

Mini-checklist rapide :

- Les variables manquantes sont traitées ?

- Les variables catégorielles encodées ?

- Pas de fuite de données entre entraînement et test ?

- Validité des hypothèses de modèle vérifiée ?

Quand la régression linéaire échoue (contre-exemples)

- Relation non linéaire forte sans transformation : une droite ne suffit pas.

- Hétéroscédasticité importante (variance des résidus non constante).

- Colinéarité élevée entre prédicteurs (coef instables).

- Outliers influents qui biaisent la droite.

- Données temporelles non stationnaires nécessitant des modèles dédiés.

Solutions alternatives :

- Transformer les variables (log, racine, polynômes).

- Utiliser des modèles robustes (régression ridge/lasso, régression robuste Huber).

- Essayer des modèles non linéaires (arbres, forêts, gradient boosting, réseaux de neurones).

- Modéliser la variance explicitement ou utiliser des méthodes hétéroscédastiques.

Heuristiques et modèles mentaux

- Commencez simple : une droite de régression fournit souvent une bonne base d’interprétation.

- R² élevé n’est pas synonyme de causalité.

- Les coefficients standardisés permettent de comparer l’importance relative des prédicteurs.

- Si l’intervalle de confiance d’un coefficient inclut zéro, son effet n’est pas robuste.

Playbook : exécution reproductible pas à pas

- Versionner votre code et vos environnements (requirements.txt ou environment.yml).

- Enregistrer le jeu de données brut et le jeu nettoyé séparément.

- Notebooks : séparer exploration et pipeline de production.

- Tests unitaires pour fonctions de prétraitement et prédiction.

- Validation automatisée : cross-validation et test sur holdout.

- Packager le modèle (pickling, ONNX) et prévoir la surveillance en production (drift, performance).

Checklist par rôle

Data Scientist

- Vérifier qualité des données et corrélations.

- Tester plusieurs modèles et documenter les choix.

- Fournir métriques et interprétations.

Analyste métier

- Valider la pertinence des variables.

- Vérifier la cohérence métier des résultats.

- Tester les scénarios what-if.

Ingénieur ML / DevOps

- Intégrer le pipeline dans CI/CD.

- Déployer le modèle avec tests et monitoring.

- Automatiser la réentraînement si nécessaire.

Critères d’acceptation

- Le pipeline produit un modèle reproductible à partir des mêmes données d’entrée.

- Les métriques ciblées sont atteintes sur le jeu de test (ex : RMSE < seuil, R² > seuil, AUC > seuil). Les seuils dépendent du contexte métier.

- Les tests unitaires de prétraitement passent.

- Un notebook d’exploration et un script de production partagent les mêmes étapes de transformation.

Cas de test et critères d’acceptation (exemples)

Cas 1 : régression linéaire simple

- Entrée : jeu de données avec colonnes total_bill et tip

- Attendu : R² > 0.3 sur le holdout, coefficients signifiants p < 0.05

Cas 2 : régression logistique

- Entrée : jeu Titanic avec fare et survived

- Attendu : AUC > 0.6 et p-valeur du coefficient fare < 0.05

Cas 3 : robustesse

- Entrée : ajout de 1% d’outliers extrêmes

- Attendu : RMSE n’augmente pas de plus de 20% si on utilise une méthode robuste

Sécurité, confidentialité et conformité

- Anonymisez les données personnelles avant toute analyse partagée.

- Respectez la minimisation des données : n’extrayez que les colonnes nécessaires.

- Pour des données sensibles, appliquez des contrôles d’accès et chiffrez-les au repos et en transit.

Note GDPR : au besoin, vérifiez le fondement légal pour le traitement et conservez un registre des activités de traitement.

Comparaison synthétique des approches

- Régression linéaire : simple, interprétable, sensible aux outliers.

- Régression polynomiale : capte la non-linéarité mais peut surajuster.

- Régression logistique : adaptée aux classes binaires, fournit des probabilités.

- Modèles non paramétriques (arbres, forêts) : captent interactions complexes, moins interprétables.

Glossaire (1 ligne chacun)

- R² : proportion de variance expliquée par le modèle.

- RMSE : erreur quadratique moyenne, mesure d’écart moyen.

- p-valeur : probabilité d’observer un effet au moins aussi extrême sous H0.

- Overfitting : modelisation qui capture le bruit et pas la structure réelle.

Exemples pratiques et snippets (rappel)

Régression linéaire simple :

import seaborn as sns

import pingouin as pg

tips = sns.load_dataset('tips')

pg.linear_regression(tips['total_bill'], tips['tip']).round(2)Régression multiple :

pg.linear_regression(tips[['total_bill','size']], tips['tip']).round(2)Régression polynomiale via feature engineering :

df['x2'] = df['x']2 pg.linear_regression(df[['x','x2']], df['y']).round(2)

Régression logistique :

pg.logistic_regression(titanic['fare'], titanic['survived']).round(2)Surveillance et maintenance

- Surveiller la dérive des caractéristiques (feature drift) et de la performance.

- Mettre en place des alertes sur les métriques clés.

- Programmer des réentraînements périodiques si la distribution change.

Limites éthiques

- Éviter d’utiliser des variables protégées (genre, origine, etc.) sans justification et contrôles appropriés.

- Vérifier les biais potentiels : un modèle statistiquement performant peut produire des décisions injustes.

Foire aux questions

Q : Dois-je toujours standardiser mes variables pour la régression linéaire ?

R : Standardiser aide lorsque les unités diffèrent fortement entre variables ou quand vous comparez l’importance relative des coefficients. Pour la simple droite avec une seule variable, ce n’est pas nécessaire.

Q : Quand utiliser la régression polynomiale plutôt qu’un arbre ?

R : Si la relation est lisse et globalement polynomiale, la régression polynomiale est plus simple et interprétable. Pour des interactions complexes ou des ruptures locales, un arbre peut mieux convenir.

Q : Comment détecter les outliers influents ?

R : Examinez les résidus, la distance de Cook et les graphiques de leverage; testez l’impact d’une suppression ciblée.

Résumé et prochaines étapes

- La régression en Python est accessible et puissante grâce à Seaborn, Pandas, NumPy et Pingouin.

- Commencez par l’exploration visuelle, puis formalisez via des tests statistiques.

- Documentez et automatisez votre pipeline pour la reproductibilité.

Actions concrètes recommandées :

- Reproduire les exemples fournis sur vos données locales.

- Construire un mini-pipeline d’entraînement et de test.

- Ajouter des validations automatiques et une surveillance en production.

Si vous voulez, je peux générer un notebook Jupyter prêt à l’emploi avec ces exemples, ou fournir des scripts d’intégration CI/CD pour le déploiement du modèle.

Matériaux similaires

Installer et utiliser Podman sur Debian 11

Guide pratique : apt-pinning sur Debian

OptiScaler : activer FSR 4 dans n'importe quel jeu

Dansguardian + Squid NTLM sur Debian Etch

Corriger l'erreur d'installation Android sur SD