한 줄 정의: LLM(대형 언어 모델)은 대규모 텍스트 패턴을 학습해 언어를 생성하는 모델입니다.

왜 수동 감별이 여전히 중요할까

자동 검출 도구가 빠르게 발전하지만 완벽하지 않습니다. 도구는 오탐(false positive)과 미탐(false negative)을 모두 만들 수 있습니다. 반면 편집자와 검토자는 문맥, 저자 의도, 문화적 단서 등 기계가 포착하기 어려운 신호를 읽어낼 수 있습니다. 수동 감별은 다음 상황에서 특히 중요합니다:

- 저작권·표절 의심이 있는 경우

- 학술·법률 같은 문맥 민감한 글 검토

- 브랜드 톤과 일치 여부 확인

- 윤리적 책임을 수반하는 퍼블리싱 결정

중요: 수동 감별은 단일 지표로 확정판단을 내리기보다 여러 신호를 종합해 ‘가능성’을 판단하는 일입니다.

수동 감별을 위한 핵심 신호(간단 요약)

- 공식적이고 지나치게 균형 잡힌 문단 길이

- 공감이나 독특한 시각이 부족한 ‘평균화된‘ 어조

- 특정 도메인에서 부자연스러운 용어 사용(예: 창작에 수학 용어)

- 과도한 전이구문(또는 그 반대로 문단 간 비약)

- 반복되는 패턴(어휘·문장 구조)

다음 섹션에서 각 신호를 어떻게 찾아내고 검사할지 구체적으로 다룹니다.

공식적 문장(공식-포뮬러) 패턴 탐지법

LLM은 통계적 평균을 따르는 경향이 있습니다. 이로 인해 다음과 같은 특성이 나타납니다:

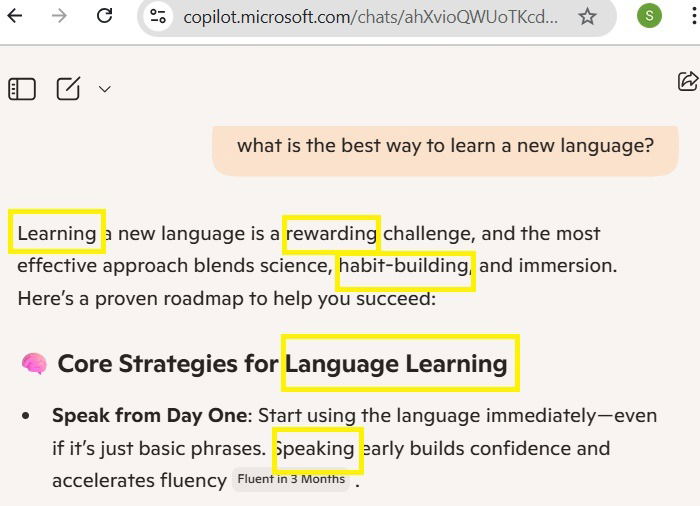

- 전문 용어와 관용구의 과도한 사용

- 평범하고 균형 잡힌 문단 구조(도입→전개→결론이 기계적으로 반복)

- 감정이나 의견이 중립적·긍정적으로 평준화됨

검사법:

- 문장별로 핵심어를 뽑아보세요. 같은 의미를 표현하려는 다양한 변주가 부족하면 포뮬러 가능성이 높습니다.

- 전문 용어가 맥락에 맞는지 실제 사례로 대입해 보세요. 어색하면 기계적 생성일 수 있습니다.

- 문단 길이 분포를 확인하세요. 지나치게 균일하면 AI가 개입했을 확률이 있습니다.

중요: 포뮬러형 문장만으로 AI 생성이라고 확정하진 마세요. 전문 기사나 가이드가 의도적으로 중립·정형화될 수 있습니다.

인간의 목소리(Voice) 부재 감별

정의: 인간 목소리란 개인적인 판단, 감정, 편견, 지역적 표현, 독특한 비유 등이 반영된 표현입니다.

AI 텍스트의 전형적 특징:

- 편향이 약화된 평준화된 어조

- 경험에 기반한 구체적 사례 부재

- 반복되는 구조(예: 항상 “첫째, 둘째, 마지막으로” 식의 배열)

검사법:

- 저자 고유의 관용구나 문체적 흔적이 있는지 비교하세요(같은 저자의 다른 글과 대조).

- 개인적 경험·구체적 수치·사소한 일화가 자연스럽게 섞여 있는지 확인하세요.

- 감정의 뉘앙스(짜증·흥분·공감 등)가 문장 전반에 자연스럽게 섞여 있는지 보세요.

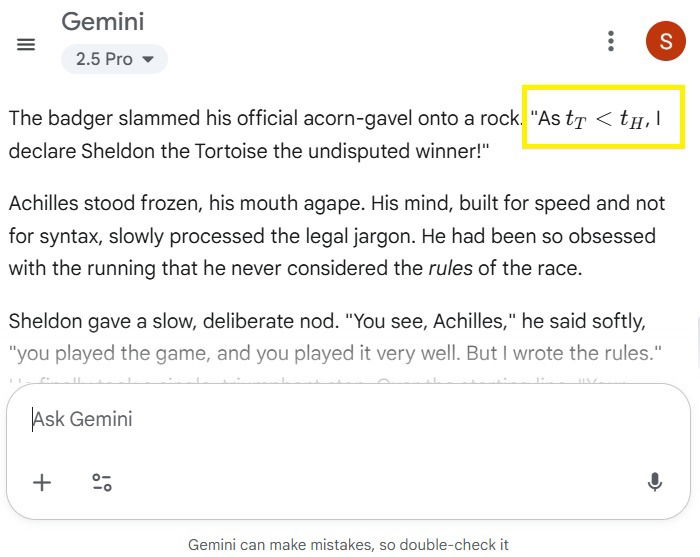

예시: 창작 과제에서 AI가 수학적 용어를 도입해 이야기를 설명하려 한다면, 인간 저자는 보통 그렇게 하지 않습니다.

문법·구조적 결함 점검 항목

일부 AI는 문법적으로 완벽해 보이지만 인간과 다른 패턴을 보입니다. 점검 항목:

- -ing형 명사(동명사)의 과다 사용

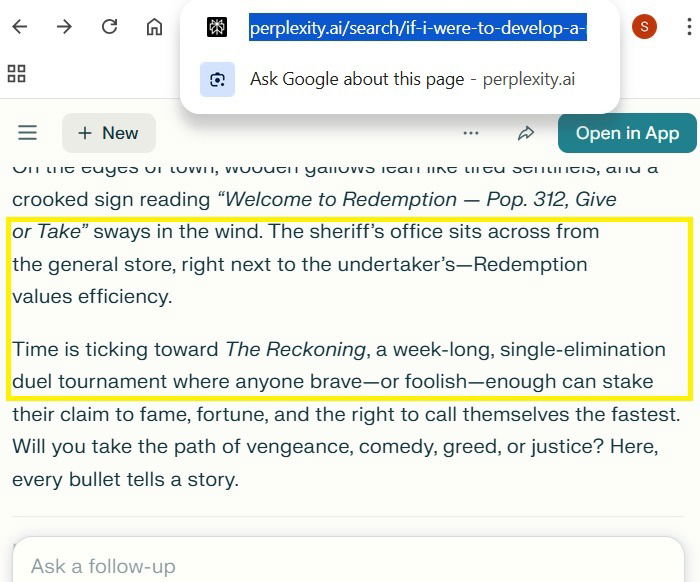

- 불필요한 긴 대시(—) 사용 또는 대시 남용

- 문단 간 논리적 연결(전환)이 갑자기 끊김

- 과도한 전이 표현(또는 역으로 전이가 전혀 없음)

- 문장 길이와 강세의 지나친 균형성

실전 팁:

- 텍스트를 소리 내어 읽어 보세요. 기계적 리듬이 들리면 의심해볼 만합니다.

- 특정 단어(예: furthermore, moreover)의 빈도를 세어 과다 사용 여부를 판단하세요.

단계별 수동 감별 방법(미니 SOP)

- 초벌 스캔: 제목·도입·결론을 읽고 즉각적으로 ‘평범함’ 또는 ‘특이함’을 느끼는지 메모합니다.

- 문체 비교: 같은 저자의 다른 글(가능하면)과 대조합니다.

- 체크리스트 적용: 포뮬러 패턴, 목소리 부재, 문법·구조 결함 항목을 하나씩 체크합니다.

- 샘플링 검사: 전체 대신 임의의 3~5개 문단을 상세 검토합니다.

- 외부 신호 확인: 메타데이터(작성 일시, 작성자), 인용 출처, 특이한 구문을 조사합니다.

- 최종 판정: 증거 기반으로 ‘높음/중간/낮음’ 확률로 결론을 내립니다. 확신이 필요하면 도구를 병행합니다.

중요: 최종 결론은 항상 문맥(학교 규정, 회사 정책 등)에 맞춰 결정하세요.

역할별 체크리스트

편집자용 체크리스트:

- 문장에 저자 고유의 일관된 톤이 있는가?

- 사실·인용·수치의 출처가 명확한가?

- 문단 연결과 로직 플로우가 자연스러운가?

- 정체성(저자 성향)을 드러내는 작은 표현이 있는가?

교수·채점자용 체크리스트:

- 학생의 기존 글과 스타일이 크게 다른가?

- 급격한 품질 향상이 있거나 갑자기 전문 용어를 남발하는가?

- 개인적 경험·과정 설명이 자연스러운가?

콘텐츠 마케터/브랜드 담당자용 체크리스트:

- 브랜드 톤과 일치하는가?

- 지나치게 중립적·사전적이지 않은가?

- 고객 사례·구체적 수치가 자연스럽게 포함되어 있는가?

대안적 접근법과 도구 병행법

수동 점검만으로 한계가 보일 때 사용할 수 있는 병행 전략:

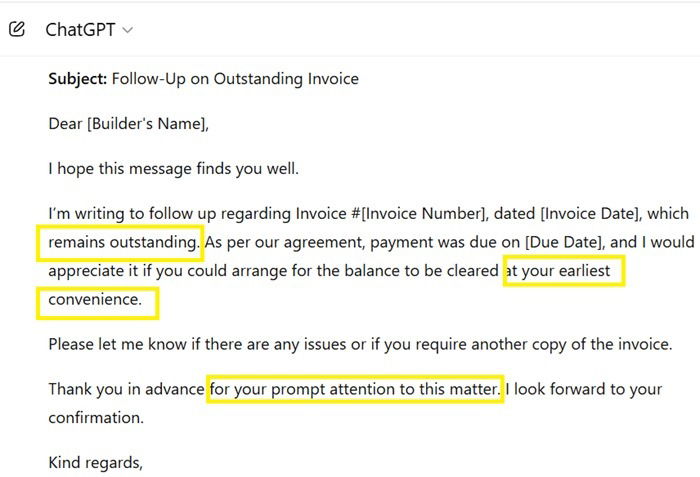

- 자동 감지 도구를 1차 걸러내기로 사용하되, 오탐 가능성을 수동으로 검토합니다.

- 텍스트 유사도 검사(플래그가 뜨면 원본과 비교)로 표절 여부를 확인합니다.

- 프롬프트 히스토리나 편집 로그를 요청할 수 있는 환경이면 기록을 확인합니다.

대체 방법(사례):

- 소규모 A/B 테스트: 같은 주제로 인간 작성본과 AI-수정본을 블라인드로 비교하여 차이를 정성적으로 평가합니다.

- 인터뷰 검증: 저자에게 짧은 인터뷰를 해 글에 나온 사례·판단 근거를 즉흥으로 설명해 달라고 요청합니다. 인간이라면 상세한 맥락을 제공할 가능성이 큽니다.

언제 수동 감별이 실패하는가(반례)

- 고도로 편집된 인간 글은 AI 텍스트처럼 균형 잡힌 구조를 가질 수 있습니다.

- 숙련된 프롬프트 엔지니어가 만든 AI 출력은 인간 고유의 오류와 유사한 흔적을 남길 수 있습니다.

- 공동 작업(사람+AI)으로 작성된 텍스트는 혼합 신호를 보입니다.

따라서 수동 감별도 확률적 판단입니다. 특히 법적·학계적 결정은 기록 증빙이 필요합니다.

빠른 의사결정 흐름도

flowchart TD

A[텍스트 수신] --> B{저자 확인 가능?}

B -- 예 --> C[저자 기존 글과 비교]

B -- 아니오 --> D[문체·구조 검사]

C --> E{유사성 높음?}

E -- 예 --> F[인간 작성 가능성 높음]

E -- 아니오 --> D

D --> G{포뮬러·무감정 신호 다수?}

G -- 예 --> H[AI 개입 가능성 높음]

G -- 아니오 --> I[추가 검토: 인터뷰/로그 요청]

H --> J[증거기반 레이블: 높음/중간/낮음]

I --> J편집 관점의 수용 기준(Критерии приёмки)의 예

- 높은 확률로 AI: 포뮬러 문장 4개 이상, 인간적 사례·경험 부재, 문단 논리파괴 2곳 이상

- 중간 확률: 일부 전이 표현 과다, 어조가 지나치게 중립적이나 근거·인용이 존재함

- 낮은 확률: 저자 확인 가능, 특이한 개인적 표현·사건이 포함됨

(위 기준은 조직의 검토 정책에 따라 맞춤화해야 합니다.)

인시던트 대응과 롤백(간단 가이드)

- 의심되는 콘텐츠 발견 → 비공개로 표시(임시 제거)

- 저자에게 해명·내역 요청(편집 로그·프롬프트·초고)

- 증거가 불충분하면 전문가 2인의 추가 검토

- AI 개입이 확인되면 정책에 따라 라벨링·수정·삭제 결정

중요: 학술 규정이나 계약 조건 위반이 의심되는 경우 법무·학사팀과 협의하세요.

실용적 검사 템플릿(편집자용)

- 문서명:

- 수신일:

- 초벌 판정(높음/중간/낮음):

- 포뮬러형 문장 수:

- 인간적 사례·일화 존재 여부(예/아니오):

- 문단 연결 문제 수:

- 권장 조치(라벨/수정/인터뷰):

사용법: 빠르게 메모해 의사결정을 표준화합니다.

짧은 프롬프트 가이드(AI가 의심되는 텍스트를 ‘인간화‘하려는 경우 주의)

- 불필요한 동명사(-ing)와 전이구문을 줄이기

- 특정 경험·사건을 하나 추가해 저자 고유성을 높이기

- 지역적 어휘나 개인적 코멘트를 섞어 자연스러움 부여

주의: 윤리적·정책적 문제로 타인의 글을 무단으로 ‘인간화‘해 제출하는 행위는 권장되지 않습니다.

결론 및 요약

요약:

- 자동 도구는 보조 수단일 뿐입니다. 수동 검토는 문맥과 개인적 단서를 읽어내는 데 강점이 있습니다.

- 핵심 검사 포인트는 포뮬러 문장, 인간 목소리 부재, 문법·구조적 결함입니다.

- 역할별 체크리스트, 단계별 SOP, 의사결정 흐름도를 활용하면 판별 품질을 높일 수 있습니다.

최종 권장 사항:

- 조직 차원의 기준을 마련해 판정 근거를 표준화하세요.

- 의심 사례는 기록으로 남기고, 필요한 경우 저자 확인 절차를 운영하세요.

1줄 용어집

- LLM: 대규모 텍스트 패턴을 학습해 문장을 생성하는 인공지능 모델.