Attacchi Man-in-the-Prompt: come funzionano e come difendersi

TL;DR

Un attacco man-in-the-prompt inserisce istruzioni malevole nel prompt di un chatbot o di un LLM per ottenere risposte fuorvianti o dati sensibili. Le estensioni del browser e gli strumenti di generazione dei prompt sono vettori comuni. Difenditi usando sessioni nuove, evitando estensioni non affidabili, ispezionando sempre il testo prima dell’invio e adottando procedure operative per rilevare e rispondere agli incidenti.

Un attacco man-in-the-prompt sfrutta la fiducia che riponi in un modello linguistico. L’attaccante inserisce istruzioni visibili o nascoste che alterano il comportamento del modello. In pratica, il risultato può essere la fuga di segreti, la diffusione di informazioni false o l’esecuzione di azioni dannose suggerite all’utente.

Cos’è un attacco man-in-the-prompt

Definizione in una riga: un attacco che modifica il prompt di un LLM per influenzare le risposte senza che l’utente se ne accorga.

La tecnica è analoga al man-in-the-middle, ma lavora sul livello delle istruzioni testuali inviate al modello. Un input maligno può essere inserito in vari modi:

- Estensioni del browser che alterano il DOM della pagina del chatbot.

- Strumenti di generazione o modifica automatica dei prompt che aggiungono istruzioni nascoste.

- Script locali o bookmarklet che manipolano il contenuto della casella di input.

Gli ambienti più a rischio sono i LLM privati aziendali e i chatbot personalizzati che hanno accesso a documenti, chiavi API o informazioni riservate. Un prompt malevolo può convincere il modello a stampare segreti, suggerire di cliccare link dannosi o persino generare codice esfiltrante come esempi di attacchi FileFix o Eddiestealer.

Perché le estensioni del browser sono un vettore primario

Le estensioni possono leggere e modificare il DOM della pagina. La casella del prompt e l’area di output sono elementi DOM che un’estensione può intercettare con permessi minimi. Questo rende le estensioni un vettore potente e difficile da rilevare.

Buone pratiche di prevenzione:

- Installare solo estensioni di sviluppatori affidabili.

- Limitare i permessi delle estensioni. Se richiesto, rimuovere l’estensione.

- Controllare i processi o le attività in background dell’estensione quando si usa un LLM.

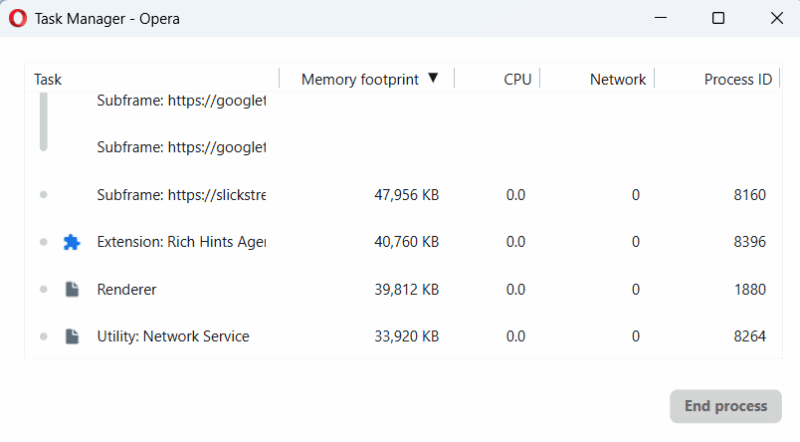

Per individuare attività sospette, apri il Task Manager del browser (ad esempio con Shift + Esc in molti browser) e osserva processi attivi mentre scrivi nella casella del chatbot. Se un’estensione esegue codice soltanto quando stai scrivendo, potrebbe manipolare il prompt.

Avvertenza importante: anche estensioni che funzionano correttamente all’inizio possono essere aggiornate successivamente e iniziare ad eseguire modifiche malevole.

Inserire manualmente i prompt e ispezionare prima dell’invio

Molti strumenti online offrono template e ottimizzazioni per i prompt. Sono utili, ma possono anche inserire istruzioni nascoste. Per ridurre il rischio:

- Scrivi i prompt direttamente nella finestra del chatbot quando possibile.

- Se copi da una fonte esterna, incolla prima in un editor di testo semplice (ad es. Blocco note) per rimuovere formattazioni e istruzioni nascoste.

- Rimuovi spazi vuoti o caratteri invisibili usando Backspace o un editor che visualizza i caratteri di controllo.

- Crea e conserva i tuoi template in un’app di note affidabile, non in servizi di terze parti non verificati.

Questa semplice abitudine elimina molte tecniche di injection basate su caratteri speciali o formattazioni nascoste.

Avviare nuove sessioni di chat quando cambia l’argomento

Le informazioni inserite in una sessione possono essere riutilizzate dal modello nella stessa conversazione. Se hai inserito dati sensibili, apri una nuova sessione quando cambi argomento o quando sospetti che il contesto sia stato compromesso. Questo riduce il rischio che istruzioni malevole estraggano dati dalle conversazioni precedenti.

Nota: molti LLM aziendali offrono metodi per resettare il contesto; usali quando disponibili.

Controllare le risposte del modello

Non dare per scontato che la risposta sia corretta o innocua. Adotta un atteggiamento critico:

- Verifica che la risposta segua il filo logico della tua richiesta.

- Se il modello restituisce dati sensibili senza che li hai richiesti, chiudi la sessione o aprine una nuova.

- Fai attenzione a risposte strutturate in modo insolito, ad esempio dati dentro blocchi di codice, tabelle o sezioni etichettate come output segreto.

- Un pattern comune degli attacchi è aggiungere istruzioni supplementari alla fine della risposta. Scorri sempre fino in fondo e cerca testi fuori contesto.

Playbook operativo in caso di sospetto attacco

Immediato

- Interrompi l’interazione. Chiudi la finestra o componi una nuova chat.

- Non cliccare link o eseguire codice suggerito nella conversazione sospetta.

- Segnala l’evento al team di sicurezza o al responsabile IT.

- Raccogli evidenze salvando screenshot e copiando testi rilevanti in un documento sicuro.

Azioni tecniche

- Disabilita estensioni sospette e riavvia il browser in modalità normale o in incognito con estensioni disabilitate.

- Cambia le credenziali che potrebbero essere state esposte (chiavi API, account con accesso diretto al LLM).

- Isola la macchina se sospetti compromissione a livello di sistema.

Post-incidente

- Analizza la sequenza dell’attacco: vettore, tempi, comandi iniettati.

- Esegui una verifica delle estensioni installate da tutti gli utenti esposti.

- Aggiorna policy aziendali e blocca estensioni non approvate.

Checklist per ruolo

| Ruolo | Azioni immediate | Frequenza consigliata |

|---|---|---|

| Utente | Evitare estensioni non verificate; scrivere prompt manualmente; segnalare anomalie | Ogni sessione |

| Amministratore IT | Mantenere whitelist/blacklist estensioni; monitorare aggiornamenti; policy di deployment | Settimanale/Alla segnalazione |

| SRE/Sicurezza | Audit delle integrazioni LLM; rotazione chiavi; analisi degli incidenti | Mensile/Alla segnalazione |

| Developer | Non memorizzare credenziali nei prompt; usare token limitati; validare input/output | In fase di sviluppo |

Questa lista breve aiuta a distribuire responsabilità chiare in azienda.

Matrice dei rischi e mitigazioni

| Rischio | Probabilità | Impatto | Mitigazione primaria |

|---|---|---|---|

| Estensione malevola aggiornata | Media | Alto | Whitelist estensioni, controllo centralizzato, modalità incognito senza estensioni |

| Prompt generator compromesso | Media | Medio-Alto | Validazione manuale, uso di editor plain text, template interni |

| Esfiltrazione di segreti | Bassa-Media | Alto | Rotazione chiavi, least privilege, separazione degli ambienti |

| Comandi malevoli nel codice | Media | Medio | Policy di revisione codice, sandboxing delle risposte |

Questa matrice aiuta a scegliere quali mitigazioni attuare prima.

Pratiche alternative e strumenti utili

- Usare LLM locali o on-premise per contenuti sensibili, riducendo la superficie esposta a estensioni del browser.

- Implementare firme o hash dei prompt inviati dal client all’API per rilevare modifiche in transito.

- Strumenti di data loss prevention (DLP) che analizzano i dati in uscita dai chatbot aziendali.

- Soluzioni che isolano le sessioni degli utenti in container o browser gestiti centralmente.

Queste alternative richiedono più investimento ma riducono significativamente il rischio operativo.

Sovrapposizioni con altri rischi e attacchi

- Slopsquatting: domini o servizi con nomi simili che ingannano gli utenti. Verifica sempre la fonte dei tool di prompt.

- Prompt injection tradizionale: inserimento di istruzioni all’interno del contenuto fornito all’LLM. Il man-in-the-prompt è una variante che agisce sul canale di input.

Glossario breve

- LLM: modello di linguaggio di grandi dimensioni che genera testo.

- Prompt injection: tecnica che inserisce istruzioni non volute nel testo di input.

- DOM: Document Object Model della pagina web, manipolabile da estensioni.

- Slopsquatting: abuso di nomi simili per ingannare gli utenti.

Quando queste difese possono fallire

- Un’estensione malevola compromette anche i sistemi di aggiornamento e firma digitale. In quel caso la lista delle estensioni affidabili potrebbe non proteggere.

- Un attaccante con accesso amministrativo a un LLM on-premise può aggirare molte protezioni client.

- Errori umani: se un utente incolla istruzioni malevole volutamente o per distrazione, molte difese automatiche non bastano.

Sommario finale

Importante: mantieni sempre un approccio prudente con i chatbot. Non dare mai accesso automatico a segreti e non installare componenti senza verifiche. Implementa policy, formazione e procedure tecniche per ridurre la probabilità di successo di un attacco man-in-the-prompt.

Note finali

- Usa sessioni nuove quando cambi argomento sensibile.

- Controlla estensioni e attività in background.

- Conserva template locali e ispeziona sempre i prompt prima dell’invio.

Annuncio breve

Adotta subito almeno due misure: disinstalla estensioni non indispensabili e inizia a scrivere i prompt in un editor di testo semplice. Questi due passi riducono immediatamente molti vettori di attacco.