Tradurre video con l'AI: guida pratica per scalare le traduzioni

1. Come l’AI traduce e sottotitola i video

L’uso dell’AI per tradurre video non è solo un miglioramento incrementale. È un cambiamento nel modo di rendere globale il contenuto multimediale. Modelli di riconoscimento vocale, traduzione automatica neurale e generazione vocale lavorano insieme per trasformare un video in più lingue. Di seguito spiego i componenti principali in modo chiaro.

Alt immagine: Diagramma che mostra pipeline di riconoscimento vocale, traduzione, clonazione vocale e sottotitolazione per un video

1.1 Riconoscimento vocale (ASR)

Definizione rapida: ASR (Automatic Speech Recognition) trasforma parlato in testo. L’ASR segmenta l’audio, trascrive ciò che viene detto e spesso produce metadati di tempo (timecodes). I modelli moderni tollerano rumore di fondo, accenti e sovrapposizioni leggere.

Punti chiave:

- Funziona meglio con audio pulito e microfoni vicini.

- Aggiunge trascrizioni time-stamped per i sottotitoli.

- Può includere riconoscimento dei parlanti (speaker diarization) per attributi multipli.

1.2 Traduzione automatica neurale (NMT)

Definizione rapida: NMT usa reti neurali per convertire frasi tra lingue, mantenendo contesto e stile.

Perché è utile:

- Sa gestire frasi idiomatiche meglio delle traduzioni parola-per-parola.

- Migliora con il training su domini specifici (es. finanza, medicina, marketing).

Limiti:

- Rischia errori su termini di nicchia o riferimenti culturali.

- Richiede post-editing umano per qualità professionale.

1.3 Generazione vocale e clonazione della voce

Definizione rapida: Text-to-Speech (TTS) converte testo in audio. La clonazione vocale riproduce timbro, ritmo ed espressività di una voce reale.

Cosa consente:

- Audio nella lingua target che mantiene il tono originale.

- Esperienza più naturale per lo spettatore rispetto ai sottotitoli soltanto.

Vincoli etici e tecnici:

- Serve il consenso della persona se si clona la sua voce.

- La qualità dipende dalla quantità di audio di riferimento.

1.4 Sottotitoli sincronizzati

L’AI usa timecodes controllati dall’ASR per generare sottotitoli leggibili. Buone pratiche:

- Limitare le righe a 1–2 e 32–42 caratteri per riga per la leggibilità.

- Sincronizzare i sottotitoli con pause naturali del parlato.

- Inserire trascrizioni nel formato richiesto dalla piattaforma (SRT, VTT).

1.5 Lip-sync e adattamento visivo

Alcuni strumenti avanzati allineano la nuova traccia audio con i movimenti delle labbra del parlante. Questo migliora la percezione di autenticità. Il lip-sync ha limiti quando le lingue hanno durate molto diverse: la durata complessiva dell’eloquio in giapponese può essere diversa dall’inglese, quindi si usano strategie di adattamento del ritmo e leggera compressione/espansione dell’audio.

1.6 Apprendimento e miglioramento continuo

I sistemi moderni apprendono dai feedback. Correzioni manuali, glossari e campioni di voce migliorano la qualità futura. In un progetto a lungo termine conviene costruire:

- Glossario terminologico specifico del brand.

- Esempi di stile (tono formale/informale).

- Set di frasi corrette come training per il modello.

Importante: non esistono soluzioni “one-size-fits-all”. Un buon workflow combina AI + revisione umana.

2. Vantaggi concreti della traduzione video

Tradurre i video amplia mercati, aumenta l’engagement e migliora la scoperta organica. Ecco un’analisi più pratica dei benefici.

2.1 Copertura e pubblico

Offrire contenuti in più lingue apre canali geografici e comunità nuove. Questo è utile per:

- Brand che vendono prodotti in più Paesi.

- Creatori che cercano abbonati internazionali.

- Aziende che richiedono formazione interna multilingue.

2.2 Coinvolgimento e fiducia

I contenuti che parlano la lingua dell’utente aumentano la fiducia. Le persone guardano più a lungo e condividono di più quando capiscono il messaggio nella propria lingua.

2.3 Scoperta e SEO

Sottotitoli e descrizioni multilingue migliorano l’indicizzazione. Le piattaforme video e i motori di ricerca considerano il testo associato al video. Traduzioni ben fatte estendono le query di ricerca e la visibilità.

2.4 Localizzazione culturale

La localizzazione è più della traduzione letterale. Considera:

- Riferimenti culturali (esempi, simboli, humor).

- Formati di data/ora e unità di misura locali.

- Sensibilità a immagini e colori per alcuni mercati.

Includere adattamenti culturali aumenta la rilevanza e il rispetto del pubblico.

3. Limiti e quando l’AI può fallire

L’AI è potente, ma non perfetta. Conoscere i limiti aiuta a decidere la strategia giusta.

Situazioni a rischio:

- Audio molto rumoroso o con più parlanti sovrapposti.

- Contenuto altamente tecnico con termini specializzati non presenti nel training.

- Testi con giochi di parole, umorismo locale o riferimenti culturali sottili.

- Requisiti legali o di compliance dove la traduzione deve essere certificata.

Esempi pratici di fallimento:

- Un claim legale tradotto male può cambiare un obbligo contrattuale.

- Un gioco di parole ironico perde senso senza adattamento creativo.

Mitigazioni:

- Usare post-editing professionale per contenuti sensibili.

- Integrare un glossario e un set di frasi approvate dal reparto legale.

- Testare su un campione di utenti locali prima del lancio completo.

4. Approcci alternativi e ibridi

Non tutte le organizzazioni devono migrare totalmente all’AI. Ecco le alternative pratiche:

- Traduzione umana completa: consigliata per contenuti legali, medici o di alta reputazione.

- Workflow ibrido (AI + revisione umana): l’AI fa il 70–90% del lavoro; il team umano corregge nuance, tono e cultura.

- Traduzione crowdsourced: utile per community-driven content con revisione collettiva.

- Sottotitolazione automatica solo per discovery, poi versione finale curata.

Scelta raccomandata: per la maggior parte dei casi di marketing e social content, il workflow ibrido offre il miglior rapporto qualità/costo.

5. Il modo più veloce per tradurre video con AI: esempio pratico con Wondershare Virbo

Questa sezione descrive un flusso operativo riproducibile. Localizziamo le etichette dell’interfaccia in italiano per chiarezza.

Flusso rapido (panoramica)

- Carica il video.

- Seleziona lingua originale e lingua target.

- Abilita sottotitoli e proofreading.

- Genera traduzione e/o clonazione vocale.

- Revisiona e scarica.

Procedura dettagliata

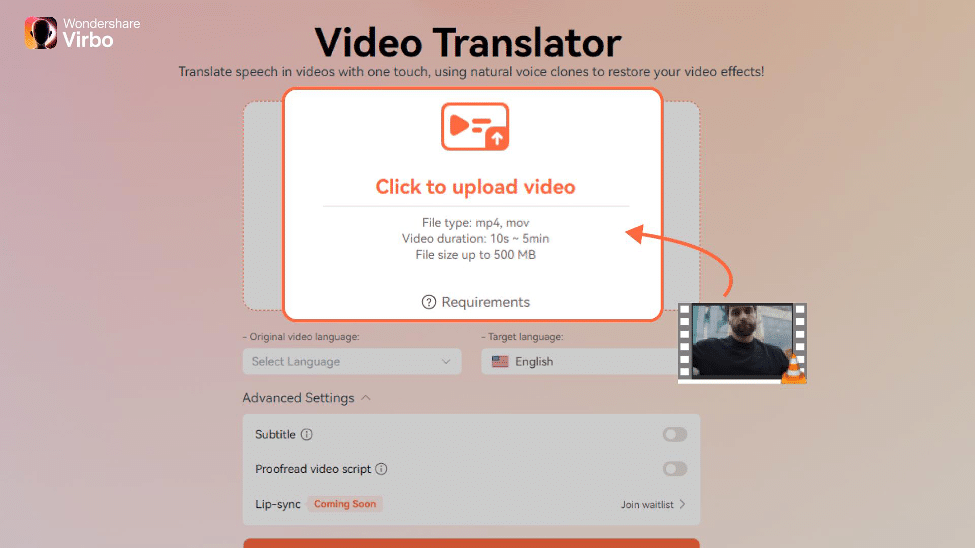

Step 1: Carica il video

Visita il sito e clicca “Clicca per caricare il video”. Supporta file comuni (MP4, MOV). Mantieni un backup locale.

Alt immagine: Interfaccia web per il caricamento di un video su Wondershare Virbo

Step 2: Imposta i parametri

Seleziona “Lingua originale del video” e “Lingua di destinazione”. Nei “Impostazioni avanzate”, attiva “Sottotitoli” e “Correzione automatica del copione”.

Suggerimento: usa la funzione di proofreading per correggere errori grammaticali e adattare lo stile.

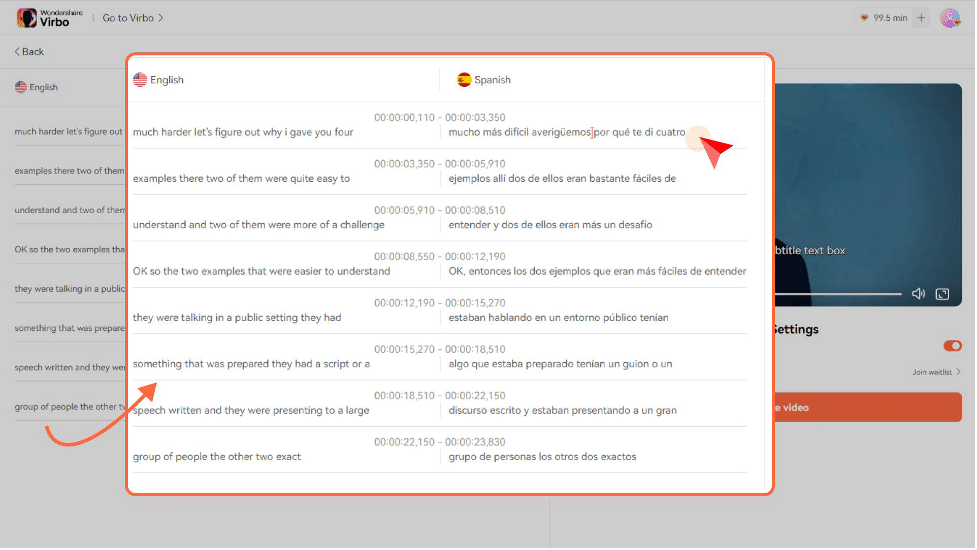

Step 3: Traduci

Clicca “Traduci questo video” per avviare l’elaborazione. Al termine, scarica il file tradotto.

Alt immagine: Anteprima del video tradotto con opzioni per scaricare sottotitoli e tracce audio

Nota: Virbo supporta oltre 30 lingue (esempi: inglese, cinese, spagnolo, giapponese, francese, hindi). Verifica l’elenco aggiornato sulla piattaforma.

6. SOP di produzione: Playbook rapido per tradurre un video

Mini-methodology: una checklist operativa per team piccoli.

- Preparazione

- Estrarre il file sorgente e la trascrizione originale.

- Creare un glossario di termini specifici del brand.

- Elaborazione AI

- Caricare il video e impostare lingue.

- Selezionare sottotitoli e clonazione vocale se necessario.

- Revisione umana

- Editor linguistico controlla la traduzione e il tono.

- Team legale verifica claim e termini sensibili.

- Test qualità

- Controllare sincronizzazione sottotitoli, pause e lip-sync.

- Effettuare un test con utenti locali (sample di 10–50 persone).

- Pubblicazione

- Caricare le varianti linguistiche sulle rispettive piattaforme.

- Monitorare metriche di engagement e feedback.

7. Criteri di accettazione e test di qualità

Criteri pratici per approvare una versione tradotta:

- Accuratezza terminologica ≥ revisione umana approvata.

- Sottotitoli senza errori ortografici e con timecodes coerenti.

- Audio generato senza artefatti udibili e con volume bilanciato.

- Durata totale del video entro ±5% rispetto all’originale (se il lip-sync è richiesto).

- Feedback utente positivo nel test locale (≥75% reazione favorevole su campione).

Test di accettazione consigliati:

- Controllo A/B fra versione originale e tradotta su audience simile.

- Test funzionale: riproduzione su dispositivi mobile e desktop.

- Controllo SEO: presenza di testo trascritto nelle meta-tag e descrizioni.

8. Role-based checklist

Per ogni ruolo, azioni concrete prima del rilascio.

Creator:

- Fornire file audio/video originali ad alta qualità.

- Indicare tono desiderato e termini chiave.

Traduttore / Editor linguistico:

- Revisione finale del testo tradotto.

- Adattamento culturale e verifica di riferimenti locali.

Marketer:

- Preparare descrizioni e titoli localizzati.

- Pianificare campagne per i mercati target.

Ingegnere/DevOps:

- Garantire backup e versioning dei file.

- Monitorare job di elaborazione e log di errore.

Legale/Data Protection Officer:

- Verificare consenso per la clonazione vocale quando necessario.

- Controllare claim e normative locali.

9. Matrice dei rischi e mitigazioni

Rischi principali e contromisure:

Rischio: Traduzione errata per contenuti legali. Mitigazione: Revisione legale obbligatoria.

Rischio: Reclami per clonazione vocale senza consenso. Mitigazione: Richiedere consenso scritto e loggare l’approvazione.

Rischio: Perdita di significato culturale. Mitigazione: Usare revisori nativi e test con utenti del mercato.

Rischio: Problemi di qualità audio dopo TTS. Mitigazione: Parametri di equalizzazione e normalizzazione automatica.

10. Privacy, GDPR e considerazioni legali

Quando raccogli dati vocali o cloni una voce, applica questi principi:

- Trasparenza: informa la persona sull’uso dei dati vocali.

- Consenso: ottieni consenso esplicito per la clonazione della voce.

- Minimizzazione: conserva solo i dati strettamente necessari.

- Sicurezza: cifra i file sensibili e limita l’accesso.

Per contenuti europei, verifica la conformità al GDPR. Consulta il DPO per procedure di conservazione e cancellazione.

11. Quando scegliere soluzioni locali o alternative

Per alcune lingue o regioni potresti preferire soluzioni locali specializzate. Esempi:

- Mercati con lessico tecnico molto specifico (es. software finanziario italiano) dovrebbero usare traduttori con competenze di dominio.

- Lingue con risorse di training limitate possono produrre traduzioni meno accurate; valuta il post-editing umano.

12. Test cases e checklist QA

Test funzionali da eseguire su ogni versione:

- Riproduzione completa senza frame drop.

- Sottotitoli sincronizzati in tutte le risoluzioni.

- Audio TTS bilanciato e privo di clipping.

- Correttezza terminologica per il glossario del brand.

13. Heuristics e mental models per decidere la strategia

Semplici regole per scegliere tra AI e umano:

- Contenuto sensibile o regolamentato → traduzione umana.

- Contenuto ad alto volume e bassa complessità → AI + revisione.

- Mercato strategico con alta competizione → investire in localizzazione culturale profonda.

14. Esempi di quando l’approccio fallisce (controesempi)

- Video con battute politicamente molto locali: traduzione letterale è fallimentare.

- Tutorial tecnico con terminologia proprietaria: NMT può introdurre errori che compromettono l’usabilità.

15. Raccomandazioni finali e roadmap operativa

Breve roadmap per implementare traduzioni video in azienda:

- Prova pilota: 5–10 video con workflow AI + revisione.

- Valuta KPI: tempo, costi, engagement, feedback qualitativo.

- Automatizza i processi ripetuti (glossari, preset TTS).

- Scala gradualmente a più lingue e mercati.

Conclusione

L’intelligenza artificiale ha trasformato la localizzazione video. Per molti casi d’uso l’AI riduce tempi e costi e migliora la presenza globale. Tuttavia, per contenuti sensibili o strategici, la revisione umana rimane indispensabile. Implementa un workflow ibrido, costruisci glossari e testa le versioni locali prima del lancio completo.

Importante: rispetta sempre la privacy e ottieni i consensi necessari per la clonazione vocale.

Fatti principali:

- Combina AI e revisione umana per bilanciare velocità e qualità.

- Prepara glossari e test utenti locali per migliorare l’accuratezza.

- Applica procedure GDPR quando tratti dati vocali.

1-linea glossario:

- ASR: riconoscimento vocale automatico; NMT: traduzione automatica neurale; TTS: sintesi vocale.

Breve annuncio (100–200 parole): Vuoi rendere i tuoi video comprensibili in tutto il mondo? L’AI ora rende la traduzione e la sottotitolazione rapide ed economiche. Con strumenti come Wondershare Virbo puoi caricare un video, scegliere la lingua di origine e di destinazione, attivare sottotitoli e la clonazione vocale, e ottenere versioni localizzate in pochi minuti. Per contenuti fondamentali, mantieni la revisione umana. Segui il playbook in questa guida per creare un workflow scalabile, rispettoso della privacy e ottimizzato per SEO. Inizia con una prova pilota di 5 video e misura engagement, tasso di completamento e feedback locali.

Suggerimento per condivisione social (Open Graph): titolo breve e descrizione concisa nella sezione SEO.