Traduire des vidéos à grande échelle avec l'IA — guide pratique

Pourquoi ce guide

Atteindre un public mondial ne se résume plus à publier une seule version d’une vidéo et espérer qu’elle soit comprise. Les barrières linguistiques et culturelles limitent la portée, l’engagement et la découverte. L’intelligence artificielle (IA) fournit aujourd’hui des chaînes de traitement qui automatisent une grande partie du travail : transcription, traduction, génération de sous-titres, clonage vocal et ajustement des lèvres (lip-sync). Ce guide vous aide à comprendre ces composants, à choisir une approche adaptée et à déployer des vidéos localisées sans sacrifier la qualité ni l’authenticité.

Important : ce document présente des bonnes pratiques et des précautions générales ; adaptez-les à vos besoins juridiques et à la politique de confidentialité de votre organisation.

1. Comment l’IA traduit et sous-titre les vidéos

L’IA n’est pas une seule technologie mais une chaîne d’outils qui coopèrent pour convertir une vidéo source en une version localisée.

- Transcription automatique : conversion de la piste audio en texte dans la langue source.

- Traduction automatique : transformation du texte source en texte cible via des modèles de traduction neuronale.

- Génération de sous-titres : segmentation, timing et mise en forme pour la lecture à l’écran.

- Synthèse vocale et clonage vocal : création d’une piste audio traduite, parfois en reproduisant la voix de l’intervenant.

- Lip-sync et alignement audio/vidéo : ajustement temporel et phonétique pour que la parole traduite corresponde aux mouvements de lèvres.

Ces étapes peuvent être exécutées séparément ou dans un pipeline intégré selon l’outil choisi.

Transcription automatique : ce qu’il faut savoir

La première étape est la plus critique : si la transcription contient des erreurs, la traduction et la synthèse vocale en seront affectées. Les modèles modernes exploitent l’apprentissage profond et des modèles acoustiques robustes pour gérer les accents, le bruit de fond et diverses qualités d’enregistrement. Une relecture humaine reste recommandée pour les contenus sensibles.

Définition rapide : transcription automatique = texte généré à partir de l’audio (ASR, Automatic Speech Recognition).

Traduction neuronale et adaptation contextuelle

Les systèmes de traduction neuronale (NMT) traitent le texte en tenant compte du contexte, des expressions idiomatiques et du registre. Ils offrent souvent des options de post-édition humaine (PEMT) pour corriger la terminologie métier, la voix de marque et les nuances culturelles.

Note : les outils peuvent proposer des glossaires et des mémoires de traduction (TM) pour garantir la cohérence terminologique entre vidéos.

Clonage vocal et synthèse vocale naturelle

Le clonage vocal reproduit la couleur de voix, l’intonation et parfois l’expressivité d’un locuteur pour produire un doublage en langue cible. L’objectif est de garder l’identité sonore du locuteur tout en parlant une autre langue.

Important : le clonage vocal exige généralement le consentement explicite du locuteur et le respect des règles de propriété intellectuelle et d’image.

Sous-titrage et synchronisation

Le sous-titrage implique plus que traduire : il faut adapter la longueur, le rythme et la lisibilité (nombre de caractères par ligne, durée d’affichage). Les outils d’IA synchronisent automatiquement les sous-titres avec l’audio et génèrent des fichiers standard (SRT, VTT) prêts pour les plateformes.

Lip-sync : pourquoi c’est utile

Le lip-sync réduit la perception d’artificialité lorsque la piste audio traduite est jouée. Il améliore l’immersion et la crédibilité, surtout dans les formats interview et e-learning. Les algorithmes modifient légèrement les images de la bouche ou ajustent l’audio pour mieux coller aux mouvements labiaux.

2. Avantages de traduire vos vidéos avec l’IA

Voici les bénéfices concrets que les créateurs et entreprises observent lorsqu’ils investissent dans la localisation vidéo basée sur l’IA.

Portée élargie et meilleure rétention

Proposer une vidéo dans la langue maternelle du spectateur augmente la probabilité qu’il regarde jusqu’au bout, interagisse et partage. Une audience plus large signifie davantage d’opportunités commerciales, d’abonnés et de visibilité organique.

Découvrabilité améliorée

Les sous-titres et descriptions localisés améliorent l’indexation par les moteurs de recherche et les plateformes vidéo. Les requêtes multilingues ont plus de chances de remonter votre contenu si les métadonnées et les sous-titres sont adaptés.

Sensibilité culturelle et pertinence locale

La traduction n’est efficace que si elle est culturellement adaptée. L’IA peut proposer des variantes, mais la relecture humaine ou la localisation éditoriale permet d’éviter les faux-pas et d’adapter références, unités et exemples au public cible.

Efficacité et rapidité

Comparé à un workflow entièrement manuel, l’IA accélère les délais de production et réduit les coûts par vidéo. Pour des séries de vidéos, l’utilisation de mémoires de traduction et de modèles vocaux stabilise la qualité au fil du temps.

3. Quand l’IA peut échouer ou nécessiter une intervention humaine

L’IA n’est pas infaillible. Voici des cas où l’intervention humaine est indispensable :

- Contenu hautement technique ou juridique : la précision terminologique est cruciale.

- Jeux de mots, humour culturel ou références locales : la traduction littérale casse souvent l’effet.

- Fichiers audio de mauvaise qualité, chevauchement de voix, ou fort bruit de fond.

- Demandes de conformité légale (contrats, disclaimers) où chaque mot compte.

Contre-exemples : une vidéo promotionnelle informelle peut souvent être entièrement traitée par IA puis revue; un webinaire juridique long demandera une relecture spécialisée.

4. Méthodologie rapide : comment traduire une vidéo efficacement (flux recommandé)

- Préparation

- Rassemblez la vidéo source, les scripts originaux et tout glossaire métier.

- Vérifiez la qualité audio.

- Transcription automatique

- Lancez l’ASR et exportez la transcription.

- Relecture initiale

- Corrigez erreurs majeures dans la transcription (noms, chiffres, termes techniques).

- Traduction automatique

- Utilisez NMT avec un glossaire. Activez la mémoire de traduction.

- Post-édition humaine

- Relisez pour le ton, la clarté et la cohérence culturelle.

- Génération audio (optionnel)

- Synthèse vocale neutre ou clonage vocal si vous avez le consentement.

- Lip-sync et finalisation

- Ajustez l’audio et les images pour une synchronisation optimale.

- Export

- Produisez les fichiers localisés (MP4, SRT/VTT, métadonnées).

Mini-méthode : la règle des 3 passes — automatique, post-édition linguistique, contrôle qualité technique.

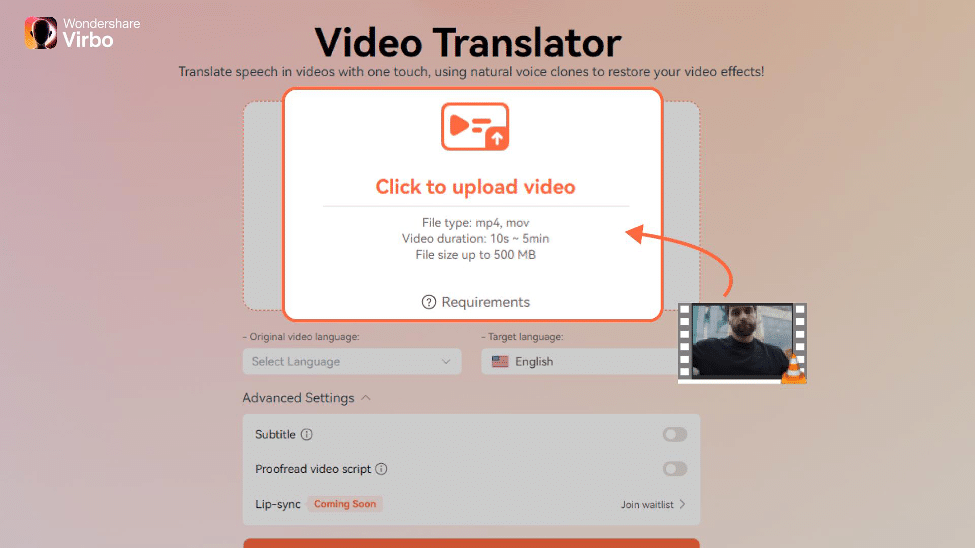

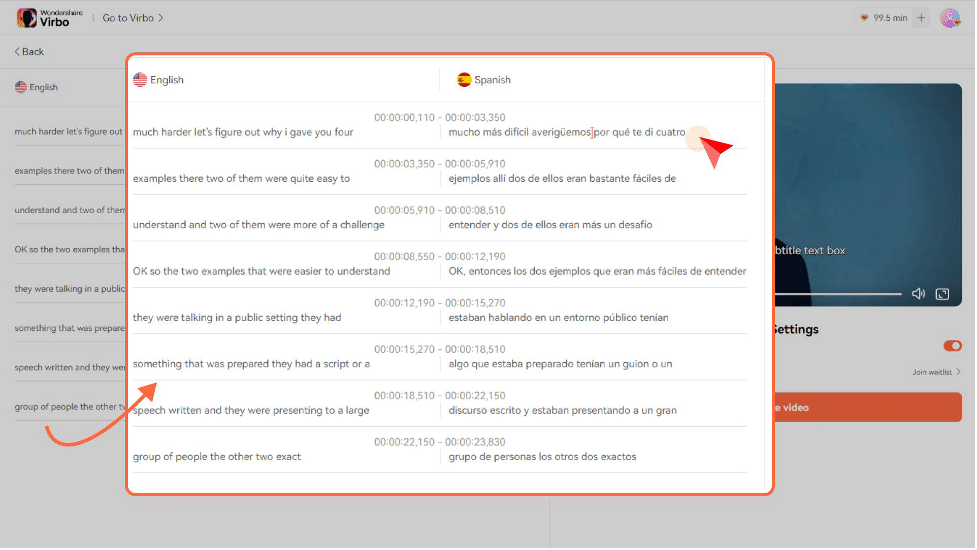

5. Tutoriel rapide avec Wondershare Virbo (exemple d’outil)

Wondershare Virbo est cité comme exemple d’outil en ligne qui propose un pipeline intégré : transcription, traduction, clonage vocal, lip-sync et sous-titrage.

Étapes condensées :

- Rendez-vous sur le site et cliquez sur “Cliquez pour télécharger la vidéo“ pour charger votre fichier.

- Choisissez la “Langue originale de la vidéo“ et la “Langue cible“.

- Dans Paramètres avancés, activez “Sous-titres“ et “Relire le script vidéo“.

- Lancez “Traduire cette vidéo“ et téléchargez le résultat une fois l’opération terminée.

Astuce : activez la relecture du script pour éliminer les incohérences grammaticales avant la génération audio.

6. Checklist par rôle avant publication

Créateur de contenu

- Vérifier la qualité audio source.

- Fournir glossaire et ton de marque.

- Obtenir consentements pour l’utilisation de la voix.

Localisation / Traducteur

- Relire la transcription.

- Adapter les références culturelles.

- Contrôler la fluidité et la lisibilité des sous-titres.

Équipe technique

- Vérifier synchronisation audio/vidéo.

- Tester export sur plateformes cibles (YouTube, Vimeo, LMS).

- Valider formats SRT/VTT et encodage.

Marketing

- Traduire les titres et descriptions.

- Localiser les miniatures si nécessaire.

- Planifier les heures de publication selon les fuseaux horaires cibles.

7. Matrice risques / mitigations

- Risque : erreur terminologique → Mitigation : glossaire + relecteur spécialisé.

- Risque : problèmes de propriété vocale → Mitigation : consentement écrit et clause dans les contrats.

- Risque : exposition de données personnelles dans l’audio → Mitigation : anonymisation et conformité RGPD.

- Risque : mauvaise synchronisation sur mobile → Mitigation : tests multi-appareils et réglages adaptatifs.

8. Sécurité, confidentialité et RGPD

Points clés :

- Consentement : obtenez l’accord explicite des personnes dont la voix est clonée ou utilisée.

- Données personnelles : traitez les fichiers audio comme des données potentiellement sensibles si des informations personnelles sont vocalement partagées.

- Sous-traitance : vérifiez que le fournisseur d’IA dispose de mesures techniques et contractuelles (accords de traitement des données) conformes à vos obligations légales.

Note : la simple utilisation d’un service cloud pour traiter des vidéos impliquant des résidents européens peut déclencher des obligations RGPD. Consultez votre délégué à la protection des données.

9. Critères de qualité et tests d’acceptation

- Exactitude linguistique : 95% des noms/termes métiers corrects après post-édition (objectif qualitatif).

- Synchronisation : sous-titres affichés au bon moment ± 200 ms.

- Lisibilité : max 42 caractères par ligne sur mobile, 2 lignes par écran préférables.

- Satisfaction utilisateur : test A/B avec métadonnées localisées et version non localisée pour mesurer gain d’engagement.

10. Alternatives et stratégies mixtes

- Approche hybride : IA pour la première version + post-édition humaine pour contenus stratégiques.

- Sous-titres uniquement : solution la plus rapide et souvent la meilleure pour l’accessibilité et le référencement.

- Voix off professionnelle : pour des campagnes haut de gamme, les doubleurs humains restent un choix premium.

11. Maturité et roadmap d’adoption

Niveau 1 — Expérimental : tests ponctuels, sous-titres automatiques publiés après vérification.

Niveau 2 — Opérationnel : pipeline automatisé pour séries de vidéos, mémoire de traduction active, relecture minimale.

Niveau 3 — Industrialisé : flux complet (ASR → NMT → clonage → lip-sync), contrôles QA, intégrations CMS et tableaux de bord SLI/SLO pour suivi de la qualité.

12. Petites bonnes pratiques SEO pour vidéos localisées

- Traduisez et localisez le titre, la description et les tags.

- Incluez sous-titres (SRT/VTT) pour chaque langue.

- Utilisez transcriptions complètes dans la zone description si la plateforme le permet.

- Localisez les miniatures si l’iconographie dépend de références culturelles.

13. Flow décisionnel rapide (Mermaid)

flowchart TD

A[Vidéo source prête ?] -->|Non| B[Améliorer audio / script]

A -->|Oui| C[Transcription automatique]

C --> D{Contenu sensible ?}

D -->|Oui| E[Post-édition humaine]

D -->|Non| F[Traduction automatique]

E --> G[Synthèse vocale ou sous-titre]

F --> G

G --> H{Lip-sync requis ?}

H -->|Oui| I[Appliquer lip-sync]

H -->|Non| J[Exporter sous-titres + vidéo]

I --> J

J --> K[QA final et publication]14. Glossaire (1 ligne chacun)

- ASR : Reconnaissance automatique de la parole.

- NMT : Traduction neuronale.

- TM : Mémoire de traduction (conserve paires source-cible).

- SRT/VTT : Formats de sous-titres standard.

- Lip-sync : Alignement lèvres/voix.

15. Exemples d’usage par cas d’emploi

- Marketing produit : doublage pour vidéos de lancement sur marchés cibles.

- E-learning : sous-titres et voix locales pour améliorer la compréhension.

- Support client : FAQ vidéo traduites pour réduire les tickets.

- Médias : diffusion internationale d’interviews avec lip-sync pour conserver l’authenticité.

16. Écueils fréquents

- Trop s’appuyer sur la traduction automatique sans relecture humaine pour des messages sensibles.

- Omettre la localisation culturelle et conserver des références inadaptées.

- Négliger le consentement pour le clonage vocal.

Conclusion

L’IA a transformé la localisation vidéo : elle permet d’atteindre de nouveaux publics plus vite et à moindre coût, tout en conservant une expérience proche de l’original grâce au clonage vocal et au lip-sync. Pour un résultat professionnel, combinez les capacités automatiques avec une relecture humaine ciblée, adoptez des workflows répétés (mémoires et glossaires) et respectez les règles de confidentialité et de consentement. Commencez par une vidéo pilote, mesurez l’impact sur l’engagement, puis itérez vers une industrialisation progressive.

Résumé : testez, corrigez, mesurez et scalez.

Important : adaptez toujours la chaîne de traitement à la sensibilité du contenu et aux obligations légales de votre pays.

Matériaux similaires

Installer et utiliser Podman sur Debian 11

Guide pratique : apt-pinning sur Debian

OptiScaler : activer FSR 4 dans n'importe quel jeu

Dansguardian + Squid NTLM sur Debian Etch

Corriger l'erreur d'installation Android sur SD